Apache Spark性能项目Tungsten与硬件趋势:迈向极限

需积分: 0 143 浏览量

更新于2024-07-17

收藏 1.3MB PDF 举报

在2017年的Spark Summit大会上,Sameer Agarwal发表了一篇题为《Apache Spark's Performance Project Tungsten and Beyond》的演讲,深入探讨了当时Apache Spark性能优化项目Tungsten的发展以及未来可能的扩展。这次演讲聚焦于硬件发展趋势,特别是针对存储、网络和CPU的性能变化,并指出这些变化对Spark性能的影响。

首先,演讲者回顾了过去几年硬件技术的显著进步。在2010年,硬盘的存储速度约为50MB/s,网络带宽为1Gbps,CPU频率通常在3GHz左右。到了2016年,尽管硬盘速度保持稳定,但SSD的读写速度提高了近10倍,达到500MB/s以上;网络连接提升到了10Gbps,比十年前快了10倍;而CPU频率也基本维持在3GHz,但随着计算密集型应用的增长,CPU逐渐成为性能瓶颈。

Spark IO(输入/输出)部分已经进行了优化,如通过数据剪枝减少不必要的输入数据读取,以及引入新的shuffle和网络实现(如2014年的sort record)。此外,数据格式的改进也是关键,例如Parquet作为一种密集的列式存储格式,使得数据处理更高效。

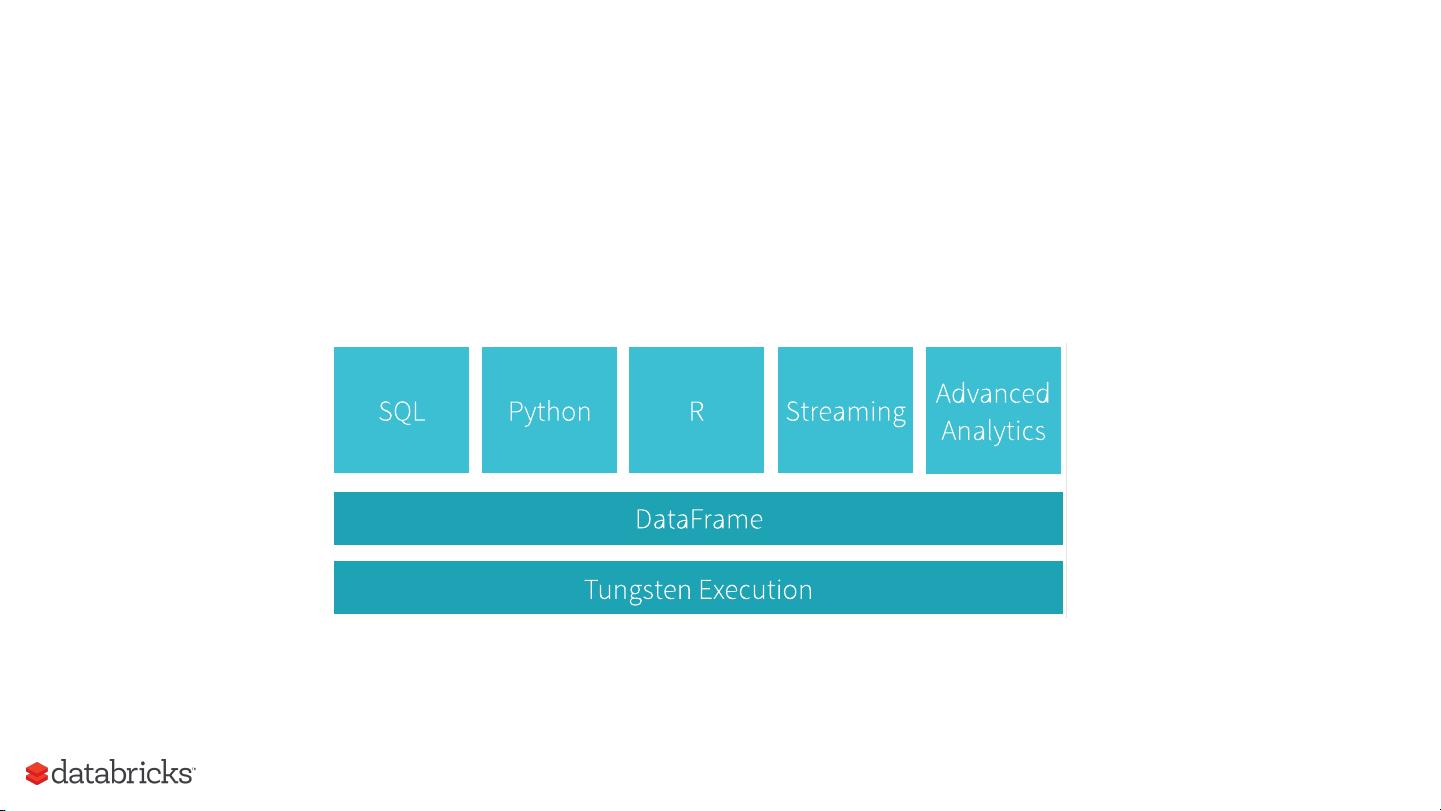

然而,尽管有了这些优化,Spark在内存和CPU效率上的提升空间依然较大。这就是Project Tungsten的主要目标,旨在大幅提高Spark后台执行的内存和CPU效率,使其性能更加接近现代硬件的极限。值得注意的是,Tungsten项目的重点在于执行效率的提升,而不是优化器的选择,这意味着更侧重于底层执行层面的优化,而非仅仅依赖于算法优化。

演讲者分享了硬件技术如何驱动Spark性能的需求升级,以及如何通过Project Tungsten这类项目来应对这一挑战。未来,随着硬件技术的持续发展,优化内存和CPU利用将成为Apache Spark性能优化的重要方向,同时,数据格式的进一步优化和更智能的执行策略也将是关键要素。

2024-12-30 上传

2024-12-30 上传

2024-12-30 上传

2024-12-30 上传

2024-12-30 上传

2024-12-30 上传

weixin_38744153

- 粉丝: 348

- 资源: 2万+

最新资源

- 语音清浊音分类及浊音谐波提取算法_三阶累积量基于正弦语音模型的应用.pdf

- 有源电力滤波器中谐波提取的数字法实现.pdf

- 谐波提取理论的实践.pdf

- 基于谐波恢复方法的直升机声信号特征提取.pdf

- ASP.NET程序设计基础篇.pdf

- ASP.NET_XML深入编程技术.pdf

- 试采用FFT方法实现加速度_速度与位移的相互转换.pdf

- eclipse开发教程得到 的点点滴滴

- DWR中文文档.pdf

- 一种基于DNS和第七层交换的CDN实现方案

- keepalived the definitive guide权威指南

- 数据库原理课后答案(自考).doc

- 图书管理系统毕业论文

- 数字信号处理课程设计+matlab滤波器设计

- 基于提升方案小波和混沌映射的盲水印算法

- 基于快速提升小波变换与人眼视觉特性的数字水印算法