从CART到XGBoost:深度解析GBDT及其优化

需积分: 0 83 浏览量

更新于2024-08-05

收藏 1.11MB PDF 举报

"本文主要介绍了集成学习中的CART回归树、提升树(BDT)以及梯度提升树(GBDT),并特别关注了XGBoost在这些算法基础上的改进。"

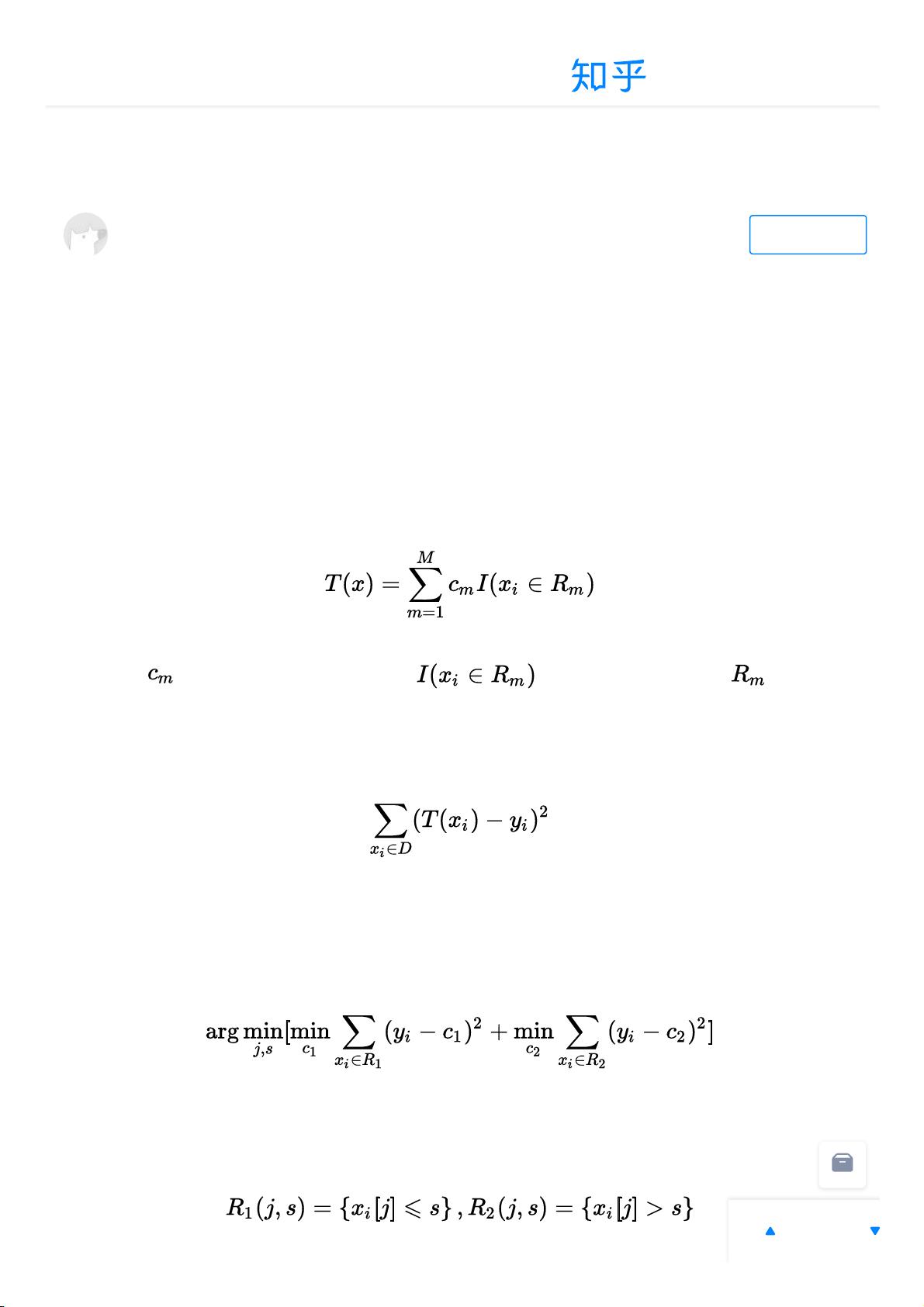

一、CART回归树

CART(Classification and Regression Trees)回归树是一种用于连续数值预测的决策树模型。它的目标是最小化平方误差,通过遍历所有特征和阈值找到最佳分裂点,使得分裂后的子树内样本方差最小。分裂后,每个叶节点的输出值为该叶节点内样本的平均值。

二、提升树(BDT)

提升树(Boosting Decision Trees)是一种集成学习方法,通过构建多棵CART树并组合它们的预测结果来提高整体预测准确度。核心思想是残差拟合,即每棵树试图修正前一棵树的预测误差。每一轮的损失函数是前一轮预测值与真实值之间的残差,以此指导新树的生长。BDT中的每棵树的叶节点输出通常是所有样本在该叶节点的均值。

三、GBDT(Gradient Boosting Decision Trees)

GBDT是对BDT的一种改进,它使用负梯度代替残差作为弱学习器的训练目标。这实际上是利用泰勒展开式的第一项近似损失函数的下降方向。GBDT的流程包括:

1. 初始化一个常数预测模型。

2. 对于每一轮,计算每个样本的负梯度作为残差的替代。

3. 使用这些负梯度来拟合新的CART回归树,每个叶节点的输出需要根据损失函数优化确定。

4. 将新树的预测结果加入到当前模型中,更新预测值。

四、XGBoost与GBDT的区别

XGBoost是基于GBDT的优化实现,它对GBDT做了以下几点改进:

1. 它引入了正则化项,以防止过拟合并提升模型的泛化能力。

2. XGBoost采用了二阶泰勒展开,更精确地逼近损失函数的梯度和Hessian矩阵。

3. 效率优化,包括列抽样、并行计算等,使得训练速度更快。

4. 支持自定义损失函数,提供了更大的灵活性。

五、XGBoost损失函数推导

XGBoost的损失函数不仅考虑了梯度,还考虑了Hessian,这样可以更好地平衡模型复杂度和拟合程度。在训练过程中,它通过最小化带有正则化的加性模型的目标函数来优化模型。

六、XGBoost的多分类

除了回归任务,XGBoost还支持多分类任务,通过构建多棵树分别预测每个类别的概率,然后选择概率最高的类别作为最终预测。

总结来说,从CART回归树到提升树(BDT),再到梯度提升树(GBDT)和XGBoost,每一步都是为了优化预测效果和模型的解释性。XGBoost通过各种技术改进,成为实际应用中非常高效且强大的机器学习工具,广泛应用于数据挖掘、竞赛项目和工业级应用。

点击了解资源详情

点击了解资源详情

2022-07-15 上传

2024-04-28 上传

2021-07-11 上传

2023-08-09 上传

2021-02-21 上传

2024-12-23 上传

ai

- 粉丝: 874

- 资源: 314

最新资源

- 非常不错phpmailer邮件类系统下载 v5.1

- STM32F0-AM2302:STM32F0探索板上AM2302DHT22温湿度传感器的测试程序

- WLSegmentedControls:具有多项选择和垂直布局支持的UISegmentedControl的自定义实现

- 黑苹果版驱动精灵Hackintosh

- Build-a-Portfolio-Website-Deploy

- 精灵传信系统支持网站+小程序双端源码

- ER English to Bengali Dictionary-开源

- 交通灯PLC程序.rar

- 企业图邮件群发系统官方版v20111123

- KarmaTestAdapter-Demo

- bookstore

- abaqus arc length-开源

- JavaLabs:Java跨平台编程实验室

- 域格模块Windows下驱动

- gcc编译工具的源码包

- makeup:一些关于女孩的化妆品的东西,给男孩的东西如何给你的爱人买