Hadoop入门:分布式存储与计算解析

"本文档是对Hadoop的初步学习介绍,涵盖了Hadoop的基本概念、优点以及核心组件HDFS和MapReduce。"

在分布式计算领域,Hadoop是一个不可或缺的名字。它是一个开源的分布式系统基础架构,由Apache基金会开发,允许开发者在不了解分布式系统底层细节的情况下编写分布式程序,从而实现大规模数据的高效处理和存储。Hadoop主要包括两个核心部分:分布式存储系统HDFS(Hadoop Distributed File System)和分布式计算框架MapReduce。

Hadoop的设计理念是可扩展性、经济性和可靠性。它能够轻松地扩展存储容量和计算能力,适应不断增长的数据需求。由于Hadoop能够在普通的PC机上运行,这大大降低了部署成本。通过分布式文件系统的备份恢复机制和MapReduce的任务监控,Hadoop确保了数据处理的高可靠性。

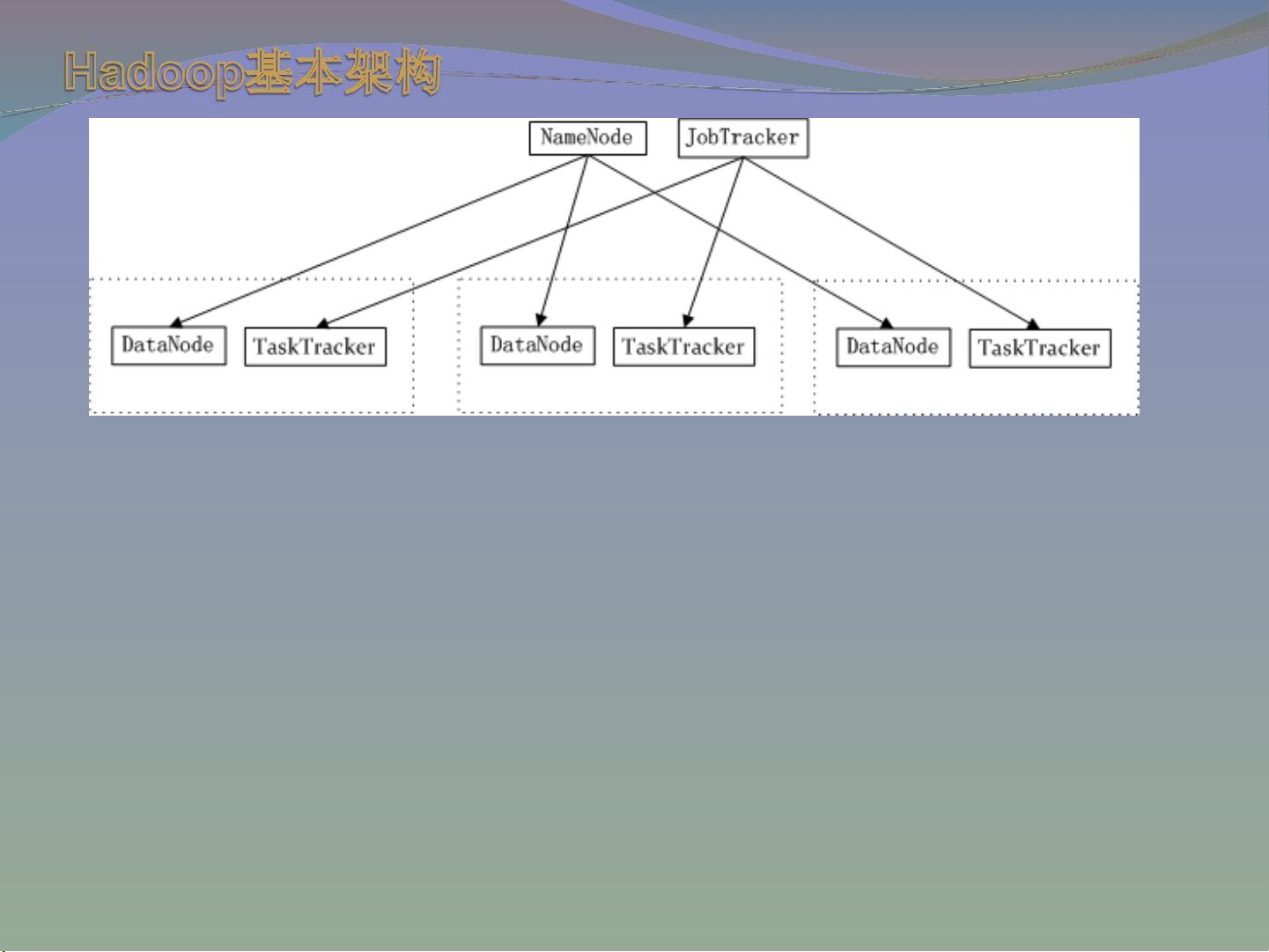

Hadoop系统由Master节点和Slave节点组成。Master节点包含NameNode和JobTracker,负责全局的管理和任务调度。NameNode管理文件系统的命名空间,跟踪文件和目录的位置信息,而DataNode作为Slave节点的一部分,存储实际的数据块并向NameNode发送心跳信息以报告其状态。JobTracker则负责分配和监控作业的执行,TaskTracker在Slave节点上运行,执行由JobTracker分配的Map和Reduce任务。

HDFS是Hadoop的核心存储组件,适合存储超大文件,如几百MB到几百PB的数据。它遵循一次写入、多次读取的原则,优化了数据的批量读取性能,而不追求低延迟访问。HDFS的设计目标是能够在商用硬件上运行,不依赖昂贵的高可用设备。

MapReduce是Hadoop的计算模型,它将复杂的大规模数据处理任务分解为一系列Map任务和Reduce任务,分别在多台机器上并行执行。Map阶段将原始数据拆分成键值对,处理后生成中间结果,Reduce阶段则将这些中间结果进行聚合,最终得到处理后的数据。

Hadoop是应对大数据挑战的重要工具,它的出现使得企业和组织能够以相对较低的成本处理海量数据,挖掘其中的价值。通过深入理解Hadoop的原理和机制,开发者可以构建出高效、可靠的分布式数据处理系统。

2019-02-25 上传

2020-02-18 上传

2013-02-21 上传

2018-09-29 上传

2018-06-27 上传

2012-01-09 上传

2012-08-19 上传

schaha_2015

- 粉丝: 0

- 资源: 3