概率近似正确学习理论及其在神经网络中的应用

需积分: 9 159 浏览量

更新于2024-07-20

收藏 26.33MB PDF 举报

"Computational Learning Theory"

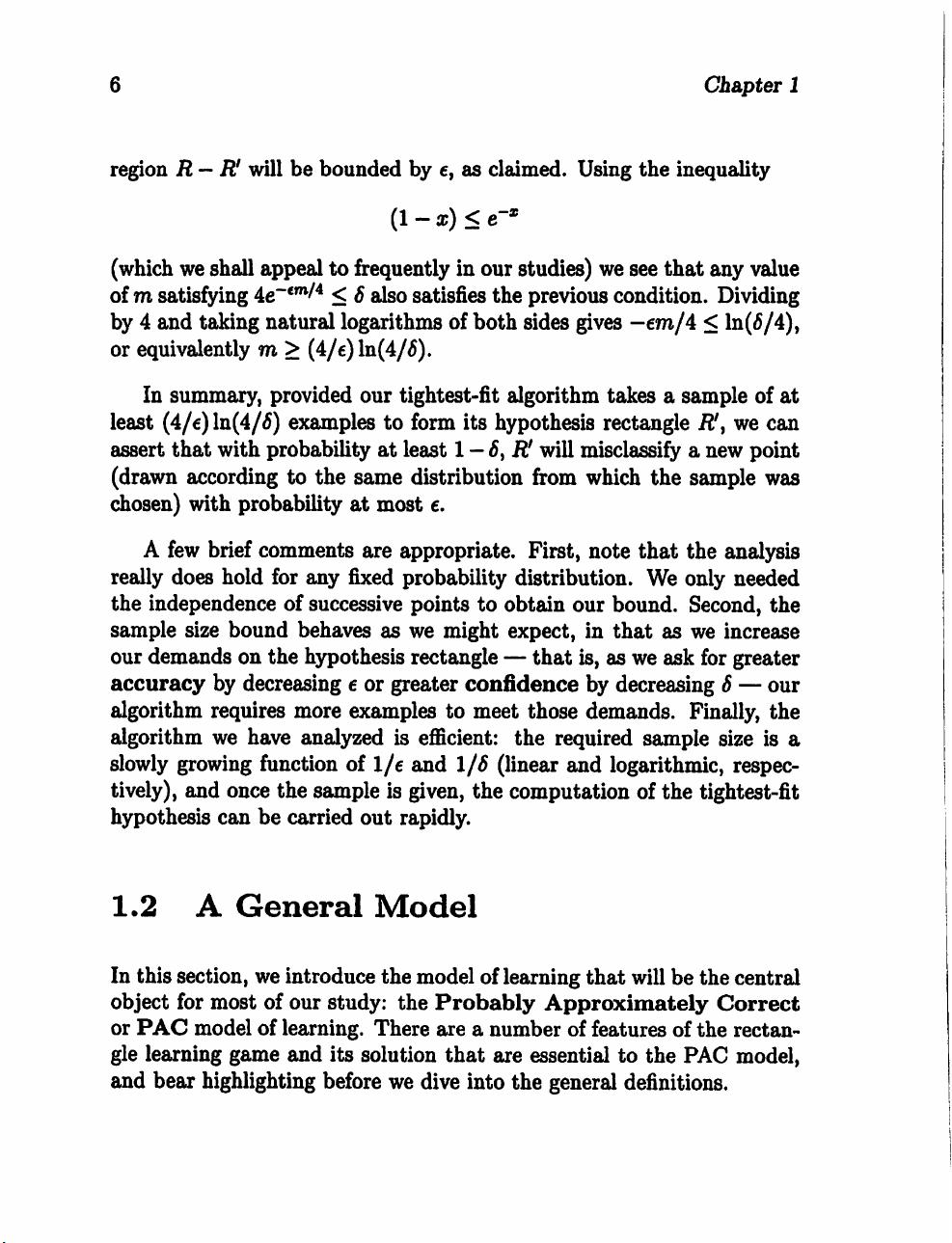

计算学习理论是近年来发展迅速的一个学科领域,主要研究在概率近似正确(Probably Approximately Correct, PAC)模型下的学习机制,并关注效率问题。本书由Michael J. Kearns和Umesh V. Vazirani撰写,提供了广泛应用于人工神经网络的理论基础。书中包含大量练习题,参考文献丰富,旨在为理论计算机科学和数学领域的研究生提供一个相对自洽的计算学习理论入门教程。

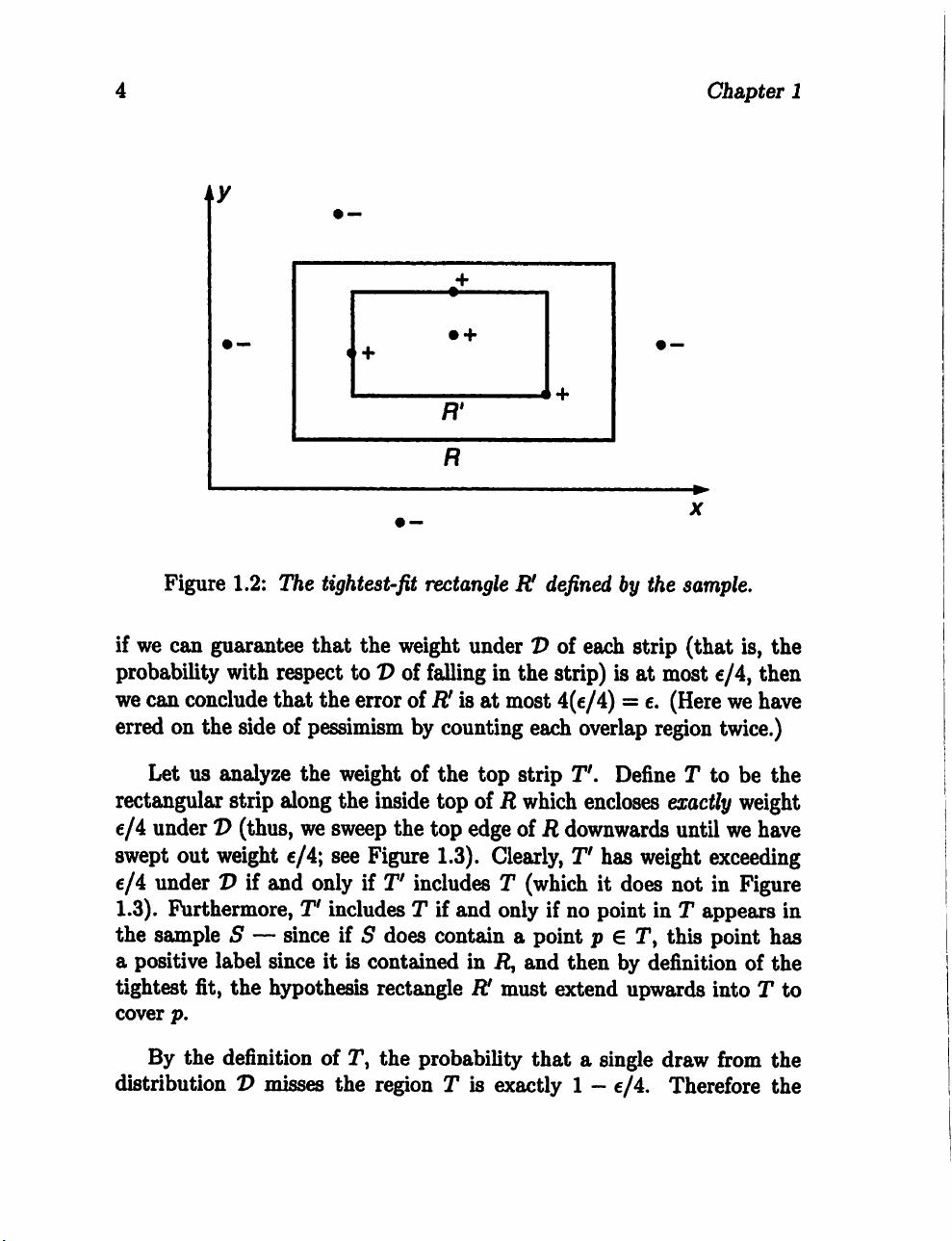

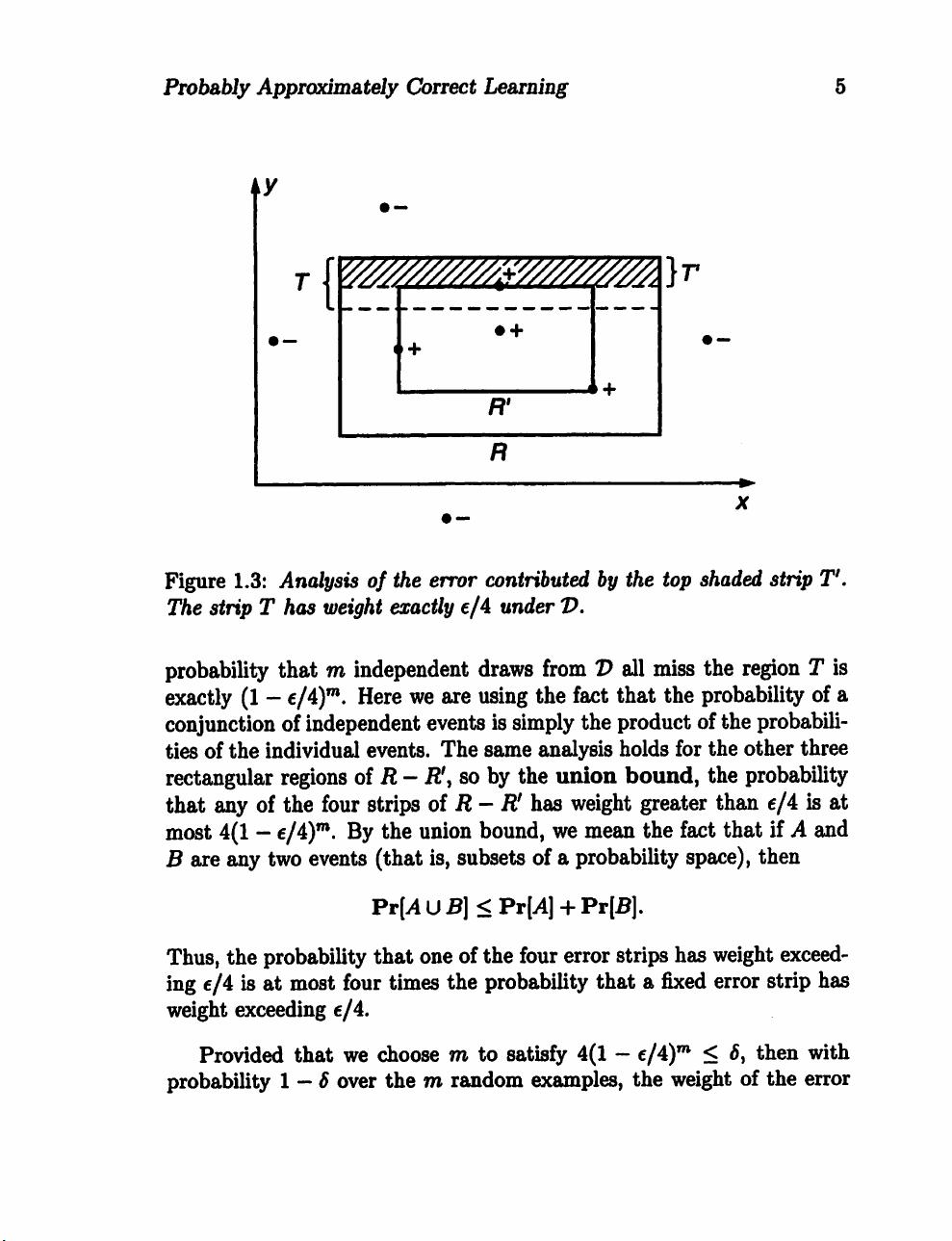

PAC学习模型是计算学习理论的核心概念之一,它定义了一种理想化的学习过程,即在有限的数据样本下,学习算法能够以高概率找到一个近似的最佳解。这个模型通过矩形学习游戏来直观地阐述,学习者需要在给定的假设空间中找到一个能够最好地解释训练数据的模型。在1.1节的矩形学习游戏中,学习者试图确定一个隐藏的矩形边界,通过与教师的交互逐步完善其猜测。

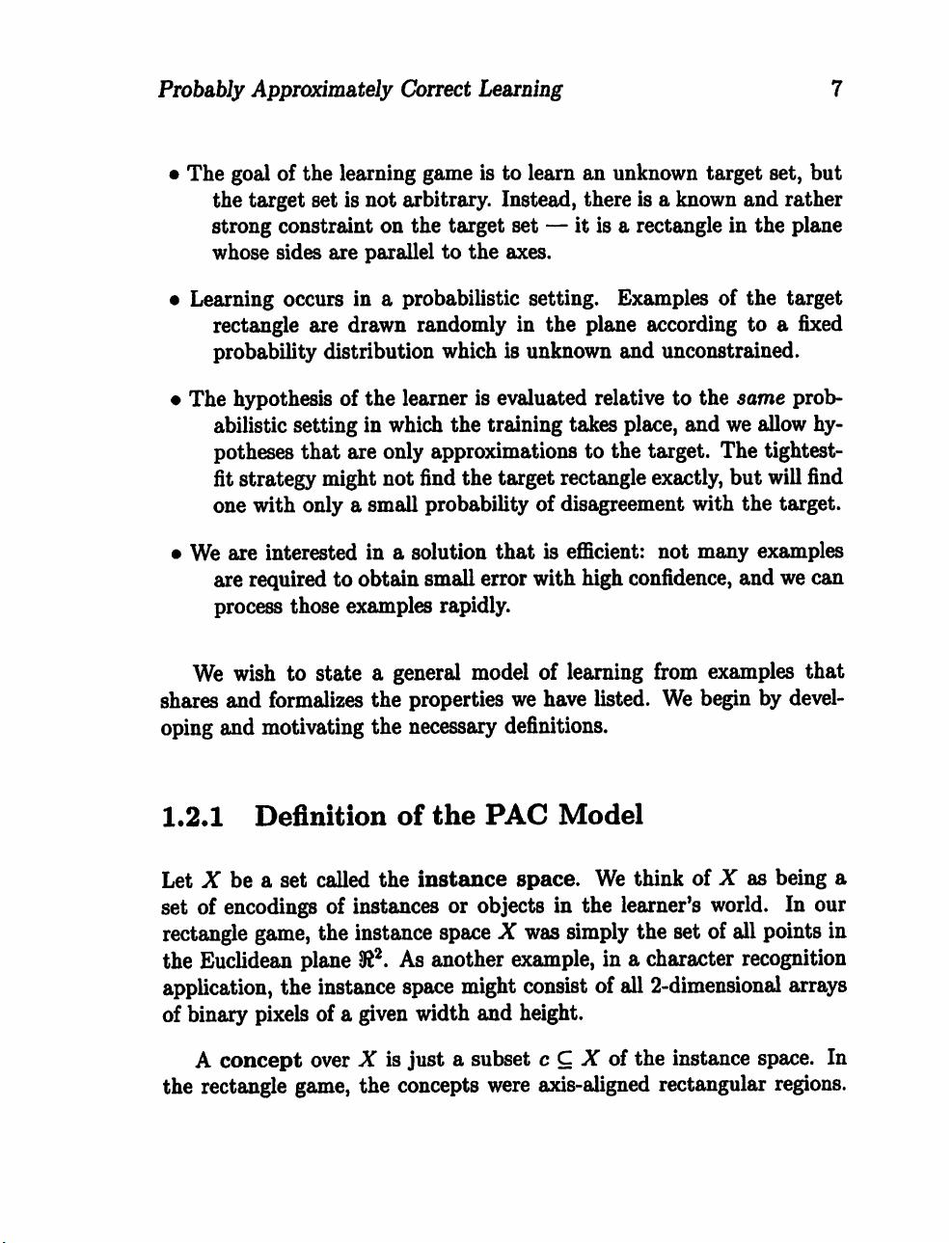

在1.2节中,作者引入了一个通用的学习模型,详细讨论了效率考虑因素。这个模型不仅限于简单的矩形问题,而是涵盖了更广泛的假设类。1.2.1小节可能涉及了如何量化学习的复杂性,例如学习问题的难度与其假设类的大小、结构以及数据分布的关系。学习算法的效率通常用时间复杂性和空间复杂性来衡量,这关系到算法在实际应用中的可行性。

计算学习理论还探讨了在不同假设类上的学习可能性和难度,比如线性函数、决策树和神经网络等。对于这些复杂模型,学习算法需要处理的不仅是找到合适的模型,还要能够在有限的资源下完成学习任务。神经网络作为计算学习理论的重要应用,它们的可学习性和泛化能力是研究的热点,涉及到权重的初始化、训练策略和网络结构优化等问题。

书中包含的背景材料涵盖了逻辑、概率和复杂性理论,这些都是理解计算学习理论的基础。概率理论用于描述学习过程中的不确定性,复杂性理论则用于分析学习任务的难易程度。这些理论工具帮助读者深入理解为什么某些学习问题是困难的,以及如何设计有效的学习算法。

"Computational Learning Theory" 是一本深入浅出介绍计算学习理论的教材,不仅适合计算机科学和数学领域的研究生,也对从事机器学习、人工智能和神经网络研究的专业人士具有很高的参考价值。通过阅读和实践书中的例子和习题,读者将能够掌握计算学习理论的基本概念、方法和应用,为未来在相关领域的研究和工作打下坚实的基础。

186 浏览量

2019-03-30 上传

148 浏览量

504 浏览量

2019-08-04 上传

109 浏览量

122 浏览量

191 浏览量

github_35819563

- 粉丝: 0

最新资源

- Avogadro:跨平台分子编辑器的开源实力

- 冰点文库下载工具Fish-v327-0221功能介绍

- 如何在Android手机上遍历应用程序并显示详细信息

- 灰色极简风格的html5项目资源包

- ISD1820语音模块详细介绍与电路应用

- ICM-20602 6轴MEMS运动追踪器英文数据手册

- 嵌入式学习必备:Linux公社问答精华

- Fry: Ruby环境管理的简化解决方案

- SimpleAuth:.Net平台的身份验证解决方案和Rest API调用集成

- Linux环境下WTRP MAC层协议的C代码实现分析

- 响应式企业网站模板及多技术项目源码包下载

- Struts2.3.20版发布,迅速获取最新稳定更新

- Swift高性能波纹动画实现与核心组件解析

- Splash:Swift语言的快速、轻量级语法高亮工具

- React Flip Toolkit:实现高效动画和布局转换的新一代库

- 解决Windows系统Office安装错误的i386 FP40EXT文件指南