零基础快速掌握Hadoop安装与配置全攻略

需积分: 9 182 浏览量

更新于2024-07-24

收藏 1.26MB PDF 举报

本篇教程详细介绍了如何安装和配置Hadoop集群,适合初学者入门。Hadoop是由Apache软件基金会支持的开源分布式计算平台,其核心组件包括Hadoop分布式文件系统(HDFS)和MapReduce。HDFS主要负责存储和管理大规模数据,它由一个NameNode(主服务器)和多个DataNode(数据节点)组成,NameNode负责维护文件系统的命名空间和客户端访问,而DataNode则负责实际的数据存储。

MapReduce是另一个关键组件,它提供了分布式计算的能力,通过一个JobTracker(主节点)和多个TaskTracker(从节点)协作完成任务。JobTracker负责任务的调度、监控和失败任务的重试,而TaskTracker执行分配给它们的任务。HDFS为MapReduce提供了文件操作和存储的支持,两个组件协同工作,构建了Hadoop分布式系统的基石。

为了进行Hadoop的集群部署,教程假设读者将搭建一个包含1个Master节点和3个Slave节点的集群,所有节点间通过局域网连接,彼此可以互相ping通。具体的IP地址配置在文中并未列出,但提到了可以从之前的文章“Hadoop集群(第2期)”获取更多关于节点设置的信息。

安装和配置Hadoop涉及以下步骤:

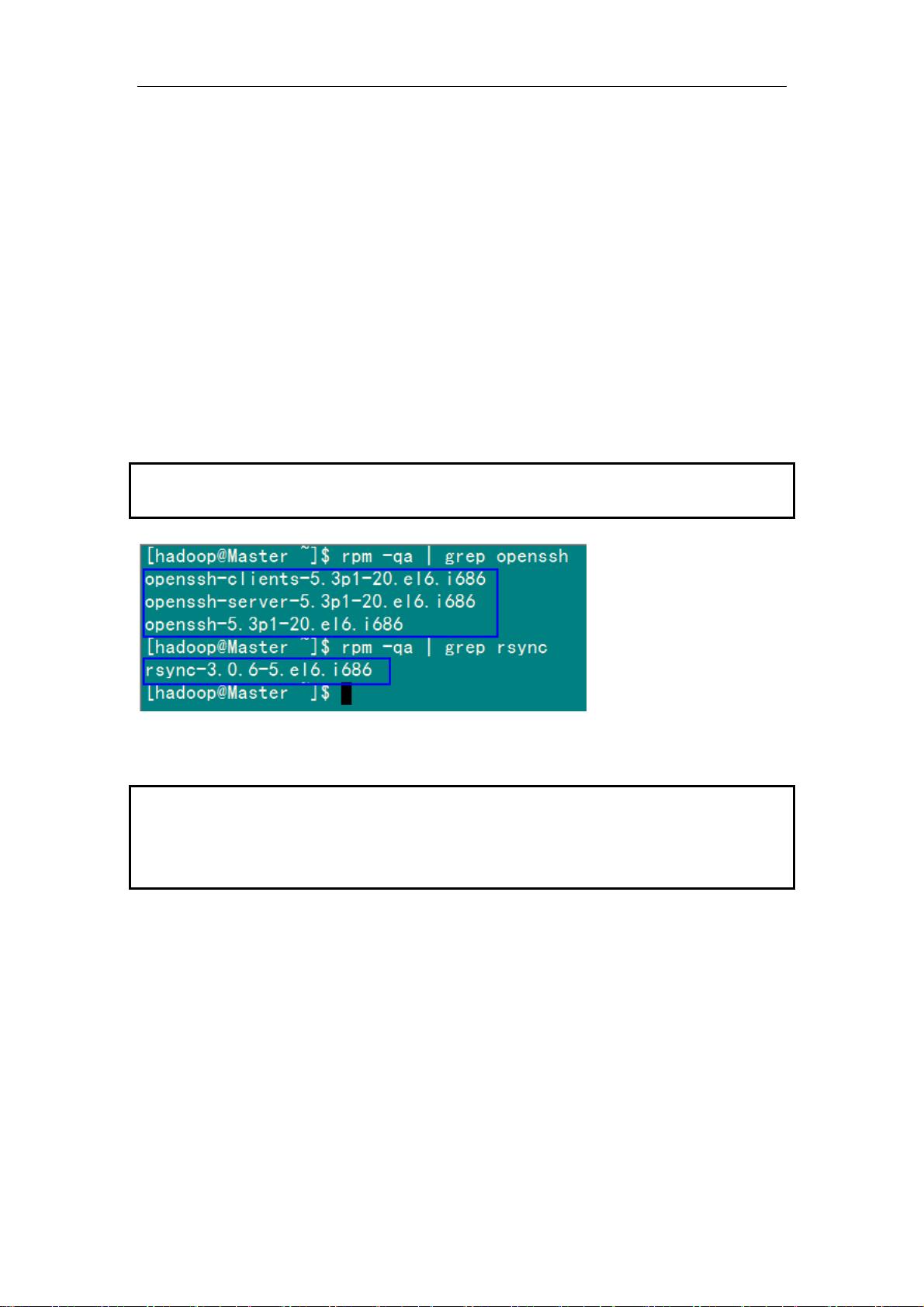

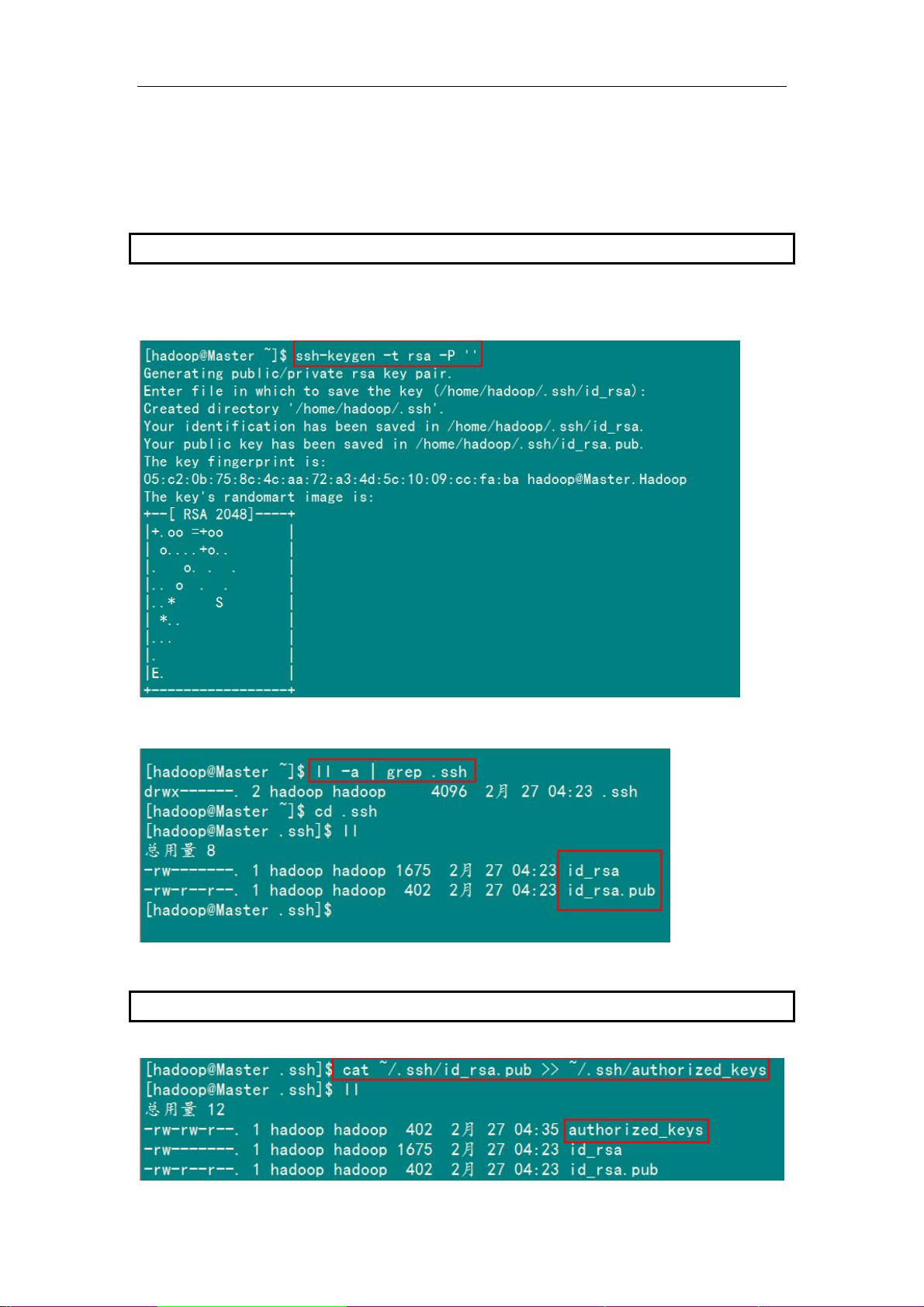

1. 环境准备:确保所有节点的操作系统兼容Hadoop,如Linux或macOS,并具备基本的网络配置。

2. 下载和安装Hadoop:从Apache官方网站下载Hadoop源代码或预编译版本,并按照文档指示进行安装。

3. 配置HDFS:编辑Hadoop配置文件(如core-site.xml和hdfs-site.xml),设置NameNode和DataNode的地址、数据路径等参数。

4. 启动服务:启动HDFS和MapReduce服务,包括NameNode、DataNode、JobTracker和TaskTracker。

5. 验证和测试:使用命令行工具(如hadoop fs和hadoop job)检查服务是否正常运行,通过执行简单的MapReduce任务测试分布式计算功能。

遵循这些步骤,即使是对Hadoop不熟悉的初学者也能掌握Hadoop的安装和配置过程,从而开启对大数据处理和云计算技术的探索。通过实践,读者将能更好地理解分布式计算模型以及Hadoop如何简化复杂的数据处理任务。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-09-07 上传

2020-04-22 上传

2022-08-03 上传

2024-03-13 上传

点击了解资源详情

点击了解资源详情

yulin010203

- 粉丝: 5

- 资源: 10

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器