解析可解释推荐系统:历史、现状与未来趋势

需积分: 24 177 浏览量

更新于2024-07-15

收藏 16.31MB PDF 举报

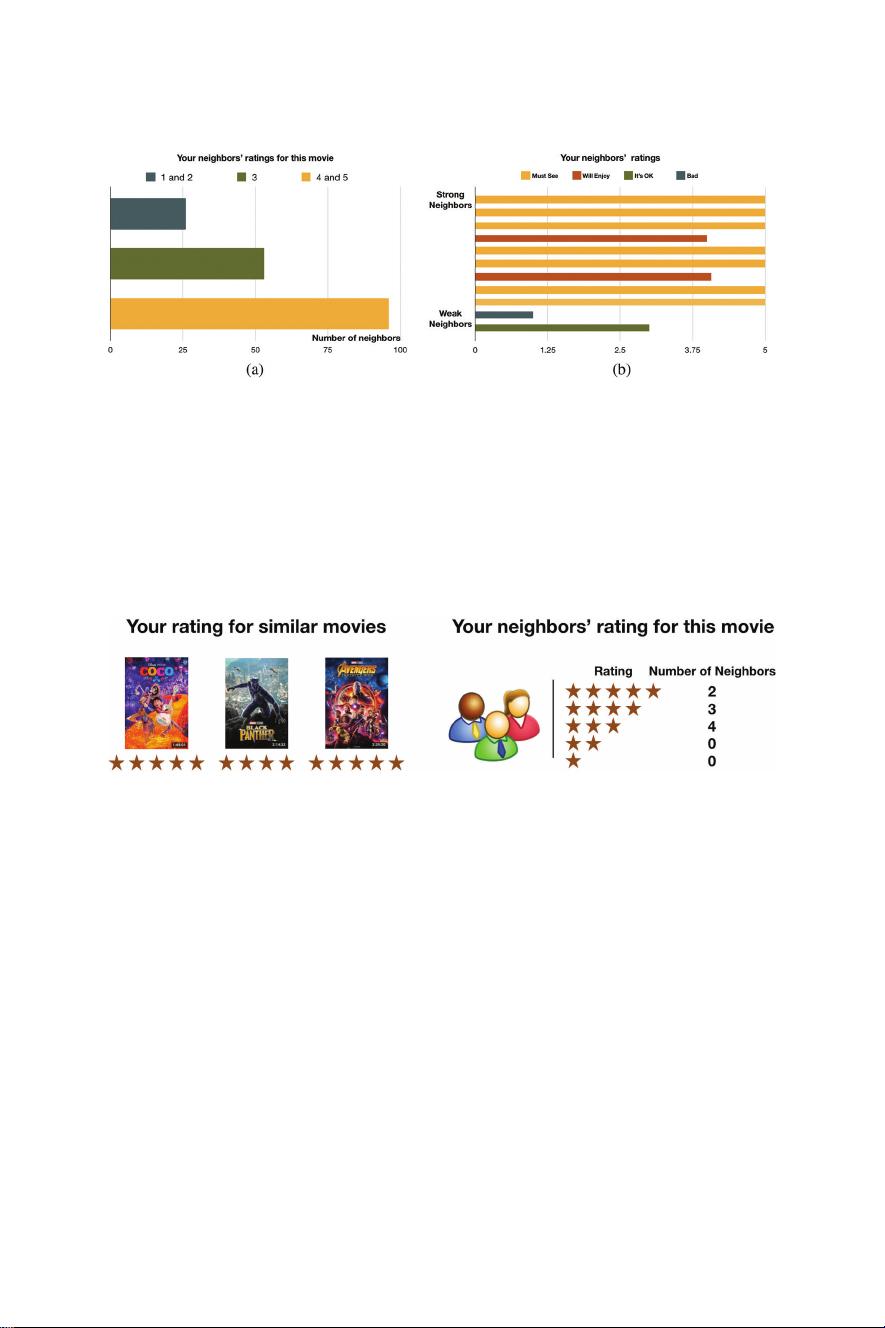

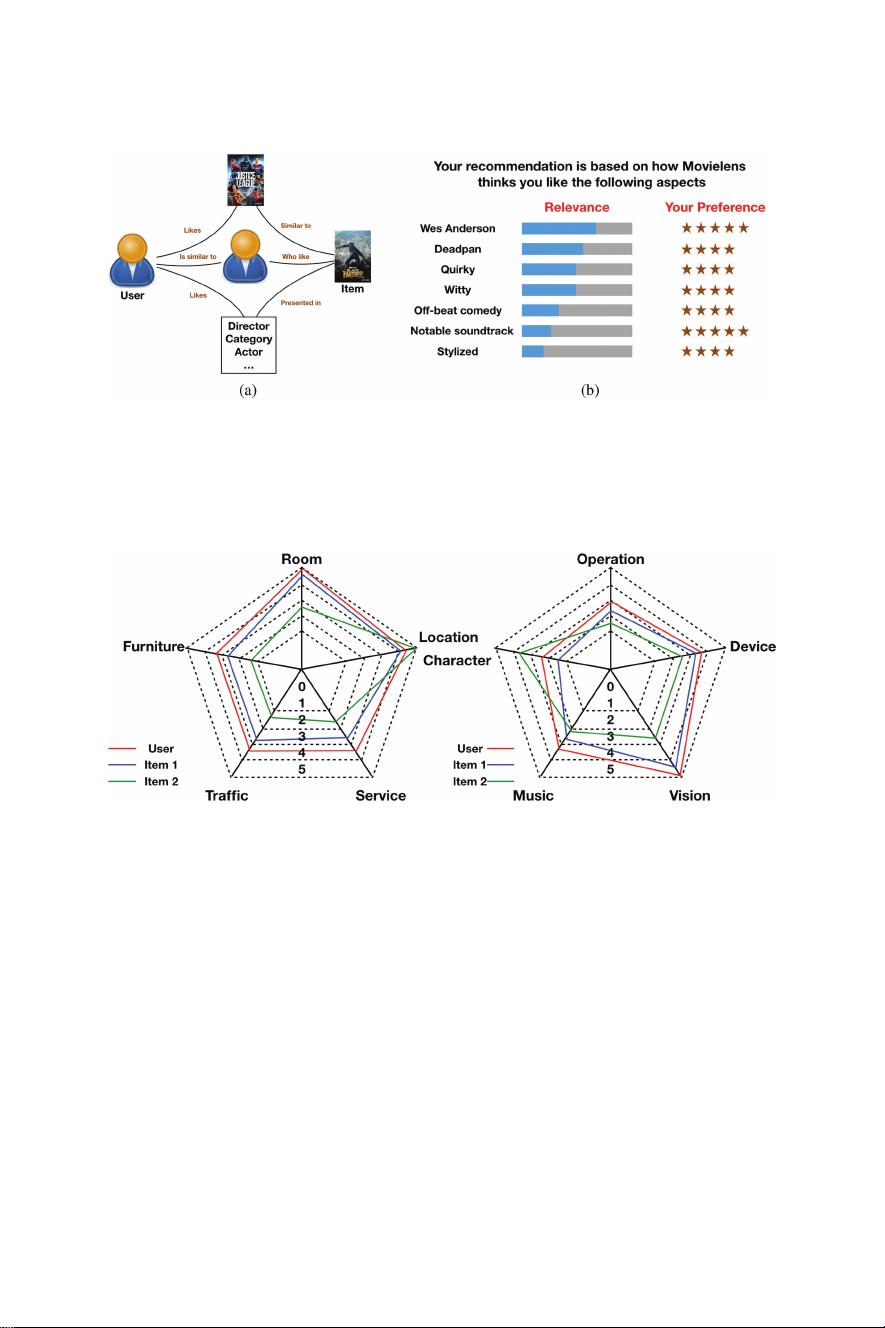

可解释推荐系统(Explainable Recommendation)是一种致力于开发既能提供高质量推荐,又能给出直观解释的智能技术。该领域的研究始于对传统推荐算法透明度不足问题的关注,随着用户对于推荐背后逻辑的理解需求增加,解释性成为现代推荐系统设计中的关键要素。文章《ExplainableRecommendation:A Survey and New Perspectives》详细回顾了这一领域的发展历程,从早期的历史背景到2020年2月的最新进展。

历史上,可解释推荐系统的重点在于解决“为什么”问题,即解释推荐算法为何选择特定项目。这主要通过两种方式实现:一是后知后觉的解释(post-hoc),即在推荐结果生成后,提供针对推荐决策的解释;二是直接来自解释性模型(也称为可解释或透明模型),这类模型本身就能生成易于理解的决策依据。

当前的研究现状聚焦于模型方法的发展,特别是模型基础方法的大量提出和应用。这些方法包括但不限于基于规则的解释、基于案例的学习、特征重要性分析、局部可解释性模型(如树模型和线性模型)、以及最近的深度学习模型的可解释性增强策略,如注意力机制和可视化技术。

评价可解释推荐系统的标准通常涉及以下几个方面:透明度(Transparency)、说服力(Persuasiveness)、有效性(Effectiveness)、可信度(Trustworthiness)和满意度(Satisfaction)。透明度评估推荐系统的解释是否清晰易懂,说服力关注用户是否接受并信任推荐,有效性则衡量推荐结果的质量。同时,解释性还有助于系统调试,帮助开发者更好地识别和修复潜在问题。

未来发展趋势方面,可解释推荐系统将继续融合深度学习与解释性技术,探索更深层次的因果关系理解和用户个性化需求的满足。此外,随着数据隐私和伦理问题日益突出,如何在保护用户隐私的同时提供有效的解释也将是重要的研究方向。

可解释推荐系统作为提升用户理解和信任、推动推荐系统优化的重要手段,正逐步成为信息技术领域的一个研究热点。随着技术的不断进步和应用场景的扩展,它将在未来的推荐服务中扮演越来越重要的角色。

2019-03-08 上传

2022-08-03 上传

2022-05-15 上传

2022-03-18 上传

2019-08-09 上传

2020-02-02 上传

2021-02-27 上传

2021-03-08 上传

qq_28147259

- 粉丝: 2

- 资源: 13

最新资源

- 新型智能电加热器:触摸感应与自动温控技术

- 社区物流信息管理系统的毕业设计实现

- VB门诊管理系统设计与实现(附论文与源代码)

- 剪叉式高空作业平台稳定性研究与创新设计

- DAMA CDGA考试必备:真题模拟及章节重点解析

- TaskExplorer:全新升级的系统监控与任务管理工具

- 新型碎纸机进纸间隙调整技术解析

- 有腿移动机器人动作教学与技术存储介质的研究

- 基于遗传算法优化的RBF神经网络分析工具

- Visual Basic入门教程完整版PDF下载

- 海洋岸滩保洁与垃圾清运服务招标文件公示

- 触摸屏测量仪器与粘度测定方法

- PSO多目标优化问题求解代码详解

- 有机硅组合物及差异剥离纸或膜技术分析

- Win10快速关机技巧:去除关机阻止功能

- 创新打印机设计:速释打印头与压纸辊安装拆卸便捷性