Spark RDD:弹性分布式数据集详解

需积分: 9 131 浏览量

更新于2024-09-03

收藏 267KB DOCX 举报

"SparkRDD是Spark的核心抽象,它是一种弹性分布式数据集,具有容错机制,只读且不可变,支持分布式并行处理。RDD由多个分区组成,可以在集群的不同节点上并行计算。RDD的设计目标是优化迭代计算场景,减少磁盘I/O,提高性能。RDD的操作包括转化和行动,转化生成新RDD而不立即计算,行动操作触发实际计算。"

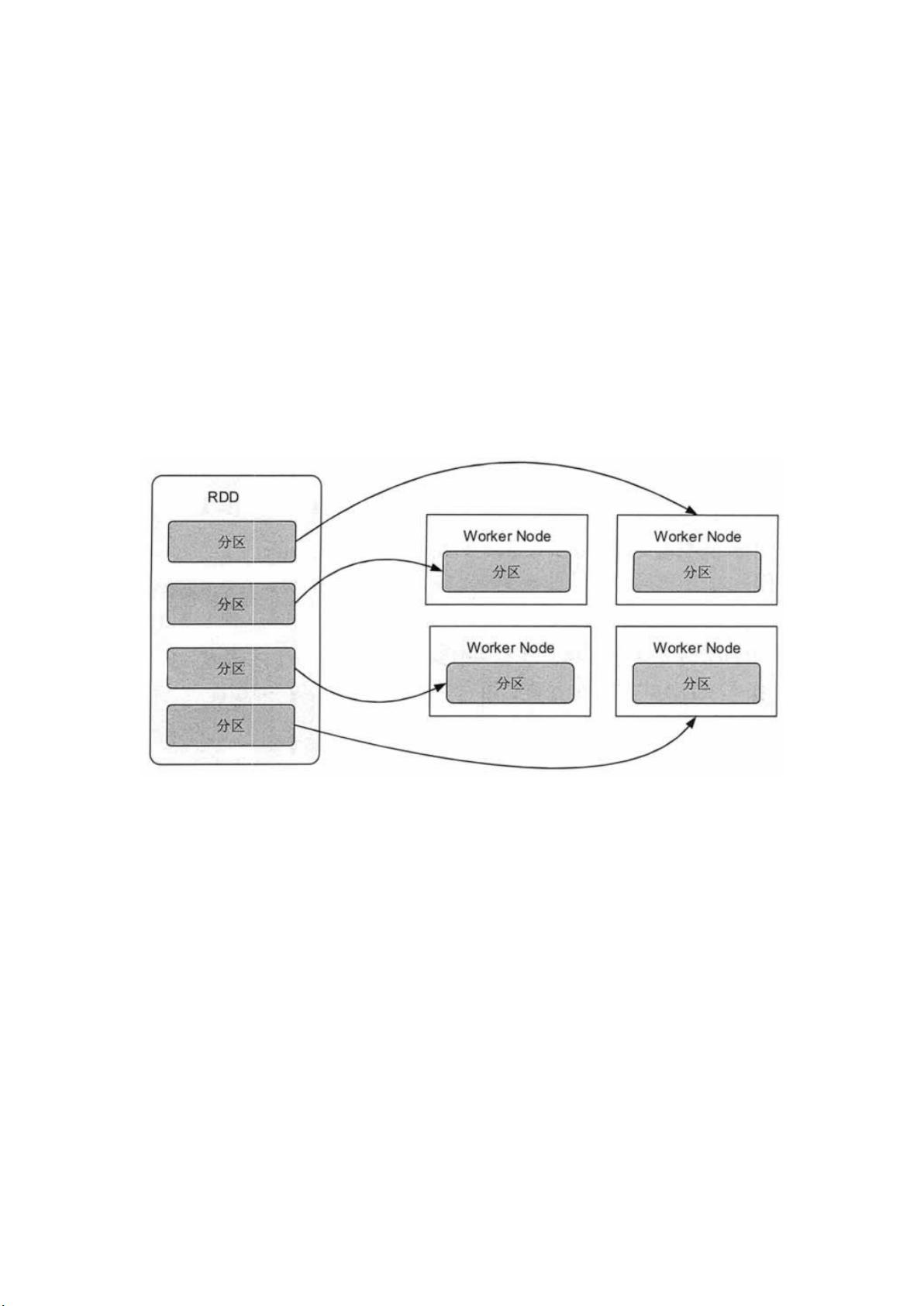

Spark的RDD(Resilient Distributed Datasets)是其核心数据结构,它为大数据处理提供了高效、灵活的基础。RDD是一种抽象的数据集合,具备容错性,可以在集群的多个节点上分布式存储和处理,以实现大规模数据的并行计算。这种数据结构是不可变的,一旦创建,就不能直接修改,但可以通过一系列确定性的转换操作创建新的RDD。

RDD的分布式特性体现在它可以被分割成多个分区,每个分区代表数据集的一个片段,这些分区可以分布在不同的计算节点上,允许并行计算。此外,RDD还具有弹性,当内存不足时,它可以将数据溢写到磁盘,以适应不同计算环境的需求。同时,RDD支持基于内存的缓存,这使得在多次计算间重用中间结果成为可能,显著提高了计算效率。

在实际应用中,RDD特别适合于需要多次迭代的算法,如机器学习和图算法。传统的MapReduce模型不适用于迭代计算,因为它强制要求数据流是一次性的,导致每次迭代都需要大量磁盘I/O。RDD通过在内存中保持中间结果,避免了这种开销,提升了性能。

RDD提供了两种主要的操作类型:转化操作和行动操作。转化操作,如`map`和`filter`,创建新的RDD而不立即执行计算,它们是惰性的。而行动操作,如`count`和`save`,会触发实际的计算并将结果返回给驱动程序或写入外部存储。这种延迟计算的策略减少了不必要的计算和数据传输,提高了系统效率。

Spark的RDD设计巧妙地解决了大数据处理中的许多挑战,包括容错、并行计算、内存管理和迭代计算效率。通过理解并熟练运用RDD,开发者能够构建出高效的大数据处理应用程序。

2019-12-11 上传

2021-04-15 上传

2019-07-19 上传

2018-06-01 上传

2018-01-16 上传

2019-10-26 上传

2019-07-09 上传

2019-08-28 上传

2023-03-11 上传

yan冰

- 粉丝: 0

- 资源: 1

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能