Scrapy入门:构建异步爬虫框架的全面指南

需积分: 16 65 浏览量

更新于2024-09-09

收藏 121KB DOCX 举报

Scrapy入门教程

Scrapy是一款强大的Python网络爬虫框架,专为高效地从网站上抓取结构化数据而设计。它建立在异步处理框架Twisted之上,适合处理多任务、高并发且任务间相互独立的场景,允许在等待网络事件时保持其他任务的执行效率。

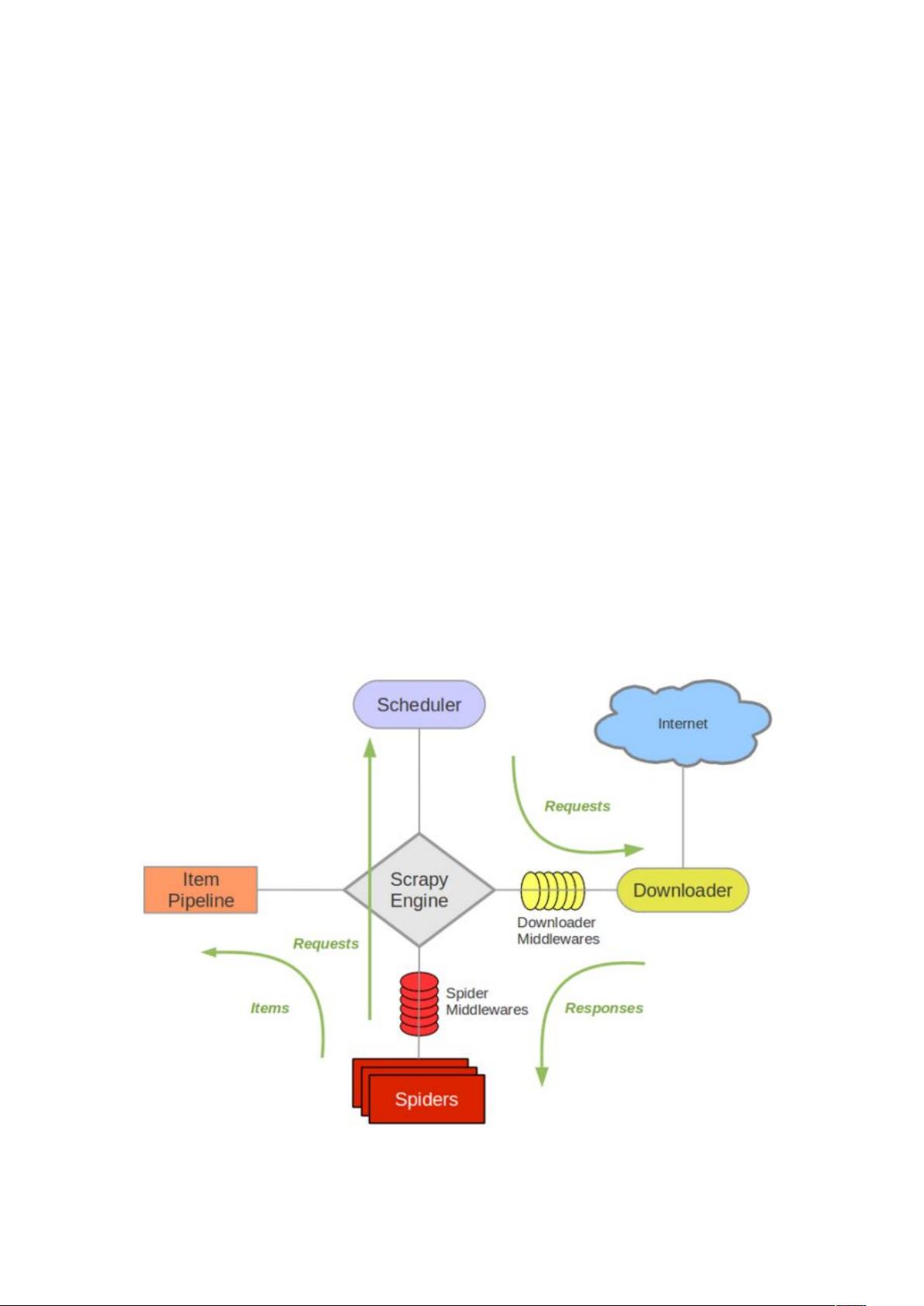

Scrapy的核心组件包括ScrapyEngine(引擎)、Scheduler(调度器)、Downloader(下载器)、Spider(蜘蛛)和ItemPipeline(项目管道),它们共同协作完成爬取、解析和数据处理流程。

1. ScrapyEngine(引擎):它是整个系统的心脏,负责控制数据处理流程并管理事务。它启动爬虫的执行,接收来自Spider的请求,确保按照预设的逻辑顺序进行。

2. Scheduler(调度器):作为中间件,调度器接收ScrapyEngine发送的请求,根据一定的策略(如优先级、频率等)对请求进行排序,并在满足条件后将请求分配给下载器。

3. Downloader(下载器):负责实际的网络抓取,接收调度器分发的请求,下载网页内容,然后将数据传递给Spider进行解析。

4. Spider(蜘蛛):这是用户编写的自定义类,用于解析特定网站的结构,定义爬取规则。它通过回调函数处理响应,解析数据并生成项目对象,这些对象随后进入ItemPipeline。

5. ItemPipeline(项目管道):此环节是数据处理的关键部分,对从Spider返回的项目进行一系列操作,如清洗HTML数据、验证数据完整性、去重处理和存储到数据库等。这一步旨在确保数据的质量和一致性。

Scrapy的数据处理流程如下:

- 引擎启动,选择一个域名,交给蜘蛛开始抓取。

- 蜘蛛获取首个爬取URL,并将其作为请求发送给调度器。

- 调度器根据策略安排请求,发送给下载器进行下载。

- 下载器下载网页后,将数据返回给蜘蛛进行解析。

- 蜘蛛在回调函数中处理数据,生成项目对象,通过管道进一步处理。

- 项目管道进行数据清洗、验证、去重等操作,最终将结果存储到指定的数据库或其他存储介质中。

掌握Scrapy,对于数据抓取和处理任务来说是一项重要的技能,尤其在大数据分析和自动化信息检索等领域具有广泛的应用价值。通过学习和实践Scrapy的组件及工作原理,可以更好地定制爬虫策略,满足各种复杂的网络抓取需求。

2016-12-02 上传

2023-10-18 上传

2017-04-11 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

ganshisheng

- 粉丝: 11

- 资源: 10

最新资源

- IEEE 14总线系统Simulink模型开发指南与案例研究

- STLinkV2.J16.S4固件更新与应用指南

- Java并发处理的实用示例分析

- Linux下简化部署与日志查看的Shell脚本工具

- Maven增量编译技术详解及应用示例

- MyEclipse 2021.5.24a最新版本发布

- Indore探索前端代码库使用指南与开发环境搭建

- 电子技术基础数字部分PPT课件第六版康华光

- MySQL 8.0.25版本可视化安装包详细介绍

- 易语言实现主流搜索引擎快速集成

- 使用asyncio-sse包装器实现服务器事件推送简易指南

- Java高级开发工程师面试要点总结

- R语言项目ClearningData-Proj1的数据处理

- VFP成本费用计算系统源码及论文全面解析

- Qt5与C++打造书籍管理系统教程

- React 应用入门:开发、测试及生产部署教程