大数据学习路径:Linux与Hadoop核心技术

版权申诉

171 浏览量

更新于2024-07-13

收藏 2.55MB DOCX 举报

"大数据学习路径2.docx"文档提供了一个全面的大数据学习指南,分为两个主要阶段:Linux基础和分布式集群技术,以及离线计算系统课程阶段,特别是Hadoop技术框架的学习。

第一阶段:Linux基础和分布式集群技术

在这个阶段,学生将深入学习Linux操作系统,包括但不限于基础命令、软件安装、网络管理、防火墙设置以及Shell编程。通过这一阶段的学习,学员能够掌握以下核心能力:

1. 熟练运用Linux操作系统,进行日常管理和维护。

2. 能够在Linux上安装和配置各种软件,提升服务器性能。

3. 了解并实践负载均衡和高可靠性集群技术,构建能够应对高并发、确保服务连续性的服务架构。

实际应用方面,学员可以解决的问题包括搭建高效、稳定的服务器集群,通过负载均衡提高网站的并发访问量,保证服务的持续可用性,显示出初级程序员必备的服务器运维技能。

第二阶段:离线计算系统课程阶段

主要关注Hadoop技术,这是大数据处理的核心组件。学习内容包括:

1. 理解Hadoop的基本概念,包括其诞生背景、行业应用以及在中国的就业市场现状。

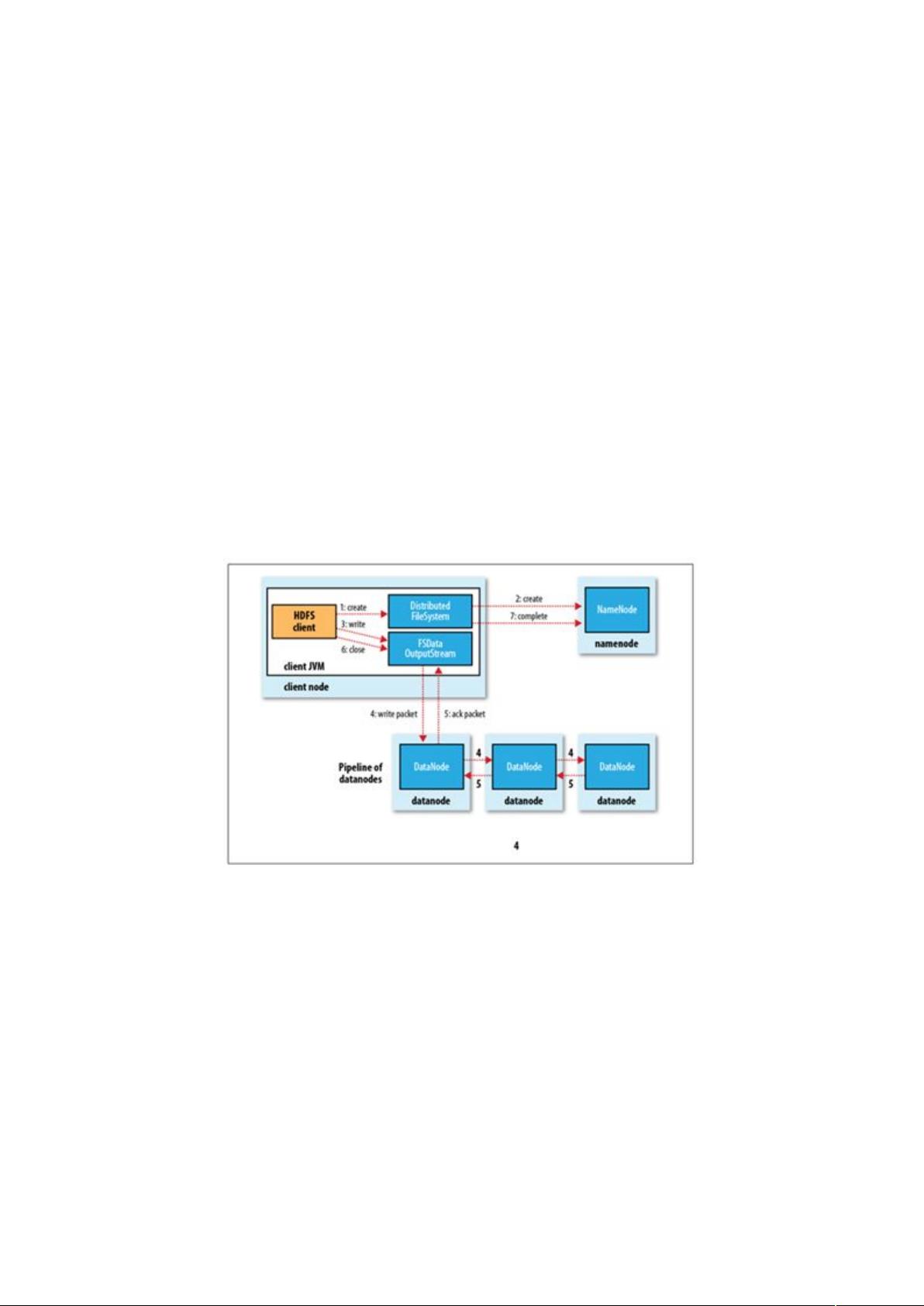

2. 深入解析Hadoop分布式文件系统HDFS(Hadoop Distributed File System)的原理和操作,以及如何进行数据存储和应用开发。

3. 掌握MapReduce,这个分布式计算模型,用于处理大规模数据集的并行计算。

4. 学习Hive,一个数据仓库工具,用于数据查询和分析,能设计和实现基于Hadoop的数据存储和分析方案。

通过这个阶段,学员可以实现如下的目标:

- 熟练搭建离线大数据计算平台,支持海量数据的存储和处理。

- 结合业务场景设计和实现数据存储策略,满足特定分析需求。

- 实现基于MapReduce的分布式运算程序,进行数据分析。

整个学习路径不仅提供了理论知识,还通过实战案例演示了Web点击流日志数据挖掘的完整流程,包括需求分析、数据获取、处理、结果导出和展示,以及Hadoop数据分析系统集群的搭建过程。这样的学习路径对于寻求大数据领域职业发展的人来说,具有很高的实用性和市场价值,能够帮助他们成为企业数据部门的初级应用开发人员。"

2019-12-24 上传

2019-06-24 上传

2021-11-14 上传

2021-04-19 上传

2022-12-24 上传

2022-06-21 上传

xiaowu0912

- 粉丝: 0

- 资源: 13万+

最新资源

- VC6.0yycksc,小游戏c语言源码,c语言项目

- C-Vdovlov-Evgeni-Smet-Matthew-Project-MHP:C-Widow-Evgeni-Smet-Matthew-Project-MHP

- PIC-10-Projects

- hackathon_emotivate

- 井字游戏

- M-Tear魔兽职业游戏公司人员销售管理系统 v1.0_m-tear_电子商务网站开发模板(使用说明+源代码+html).zip

- Pregnancy - Fetus Size-crx插件

- hop-expression:跳表达语言和转换插件

- OpenGL_MFC,b2b2c多语言源码,c语言项目

- Universal-Setup-OLD:这是一个通用的设置应用程序

- angularjs-lazyload

- 清华数学模型讲义.zip

- Rare tijden-crx插件

- botica_indica:受Shonku教授启发的食谱

- lamnv-demo-angular-deloy:部署到https

- Android应用源码之theme.zip项目安卓应用源码下载