Spark算子基础:Scala版RDD操作详解

需积分: 9 25 浏览量

更新于2024-09-14

收藏 63KB DOCX 举报

"Spark算子基础讲义,涵盖了Spark的核心概念——算子和RDD,以及如何在Scala环境下操作Spark集群进行数据处理。"

Spark是一种快速、通用且可扩展的大数据处理框架,它提供了丰富的算子用于对分布式数据集进行操作。在本讲义中,我们将重点讨论Spark的基本算子,并通过实例演示如何在Scala环境下使用这些算子。

1. Spark算子

Spark算子分为转换算子(Transformation)和行动算子(Action)。转换算子不会立即执行任何计算,而是创建一个新的RDD(弹性分布式数据集)表示。而行动算子会触发实际的计算,并返回结果或写入数据到外部存储。

- 转换算子:

- `textFile`: 从指定路径读取文件并创建一个RDD。

- `flatMap`: 对每个输入元素应用函数,然后展开结果为多个元素。

- `map`: 对RDD中的每个元素应用函数并返回新的RDD。

- `reduceByKey`: 将具有相同键的值聚合在一起,使用指定的函数合并值。

- `sortBy`: 根据提供的函数对键值对进行排序。

- 行动算子:

- `collect`: 将RDD的所有元素收集到驱动程序的内存中,通常用于小规模数据的检查。

- `saveAsTextFile`: 将RDD的内容保存为文本文件。

2. RDD(弹性分布式数据集)

RDD是Spark的核心抽象,它是不可变的、分区的数据集,分布在集群的不同节点上。RDD可以由其他RDD转换而来,或者通过读取外部数据源创建。

3. Spark Shell操作集群

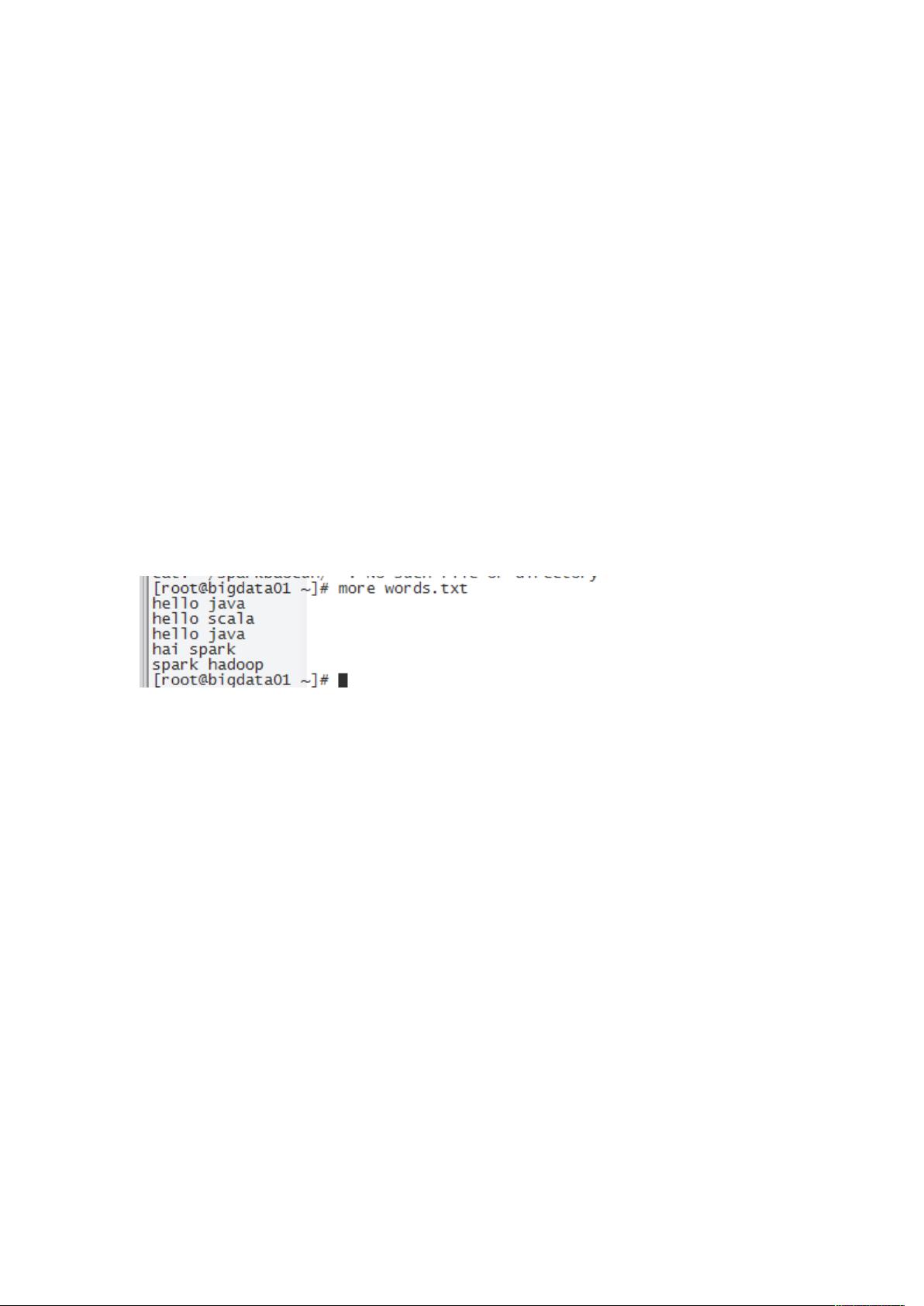

- 创建HDFS目录并上传数据:在Hadoop集群上创建目录`/spark`,并将文件`word.txt`分发到`/spark/1.log`和`/spark/2.log`。

- 启动Spark集群:在master节点的`bin`目录下,使用`spark-shell`命令启动Spark Shell,并指定master节点和资源参数。

- 统计单词:在Shell中,读取HDFS上的数据,使用`flatMap`、`map`、`reduceByKey`和`sortBy`算子进行单词计数,最后使用`collect`和`saveAsTextFile`行动算子处理结果。

4. IDEA中操作集群

- Maven配置:在IDEA项目中添加Scala库、Spark Core和Hadoop Client的依赖。

- 编写Scala代码:实现与Spark Shell类似的操作,创建SparkContext,读取数据,应用算子,然后保存结果。

5. Spark运行模式

Spark可以运行在本地模式、集群模式(例如YARN或Mesos)和独立部署模式下。在这个例子中,我们使用的是独立部署模式,通过`--master spark://bigdata01:7077`指定master地址。

总结:Spark的算子和RDD是其强大功能的基础,通过理解并熟练运用这些工具,开发者可以高效地处理大规模数据。在Scala环境中,我们可以方便地利用这些算子进行数据处理,无论是简单的统计分析还是复杂的机器学习任务,Spark都能提供高效的支持。

2018-08-16 上传

2018-04-06 上传

2019-07-19 上传

2021-01-07 上传

2021-01-07 上传

2018-12-05 上传

2020-07-02 上传