线性映射与矩阵分析精华概要

需积分: 5 121 浏览量

更新于2024-07-16

收藏 3.95MB DOCX 举报

"该文档是剑桥大学机器学习暑期学校的矩阵分析讲义,涵盖了线性映射、矩阵表示、最简形、λ矩阵的相关性质、内积空间以及矩阵的相似性和Jordan标准型等内容,特别强调了在复数域上的应用和奇异值分解。"

在矩阵分析中,线性映射是一个重要的概念,它是指保持向量加法和标量乘法运算性质的函数。证明一个映射是线性映射的关键在于检查是否满足线性组合的性质,即f(ax + by) = af(x) + bf(y),其中a和b是标量,x和y是向量。线性映射在不同的基下有不同的矩阵表示,通过基变换可以得到这些矩阵。

线性映射的最简形是通过初等行变换和列变换来实现的,目的是将矩阵转化为阶梯形。在这个过程中,行变换对应于矩阵的左侧操作,列变换对应于右侧操作。矩阵Q和P分别用于记录行变换和列变换,而Q逆则是在化为最简形后需要进一步变换得到的结果。

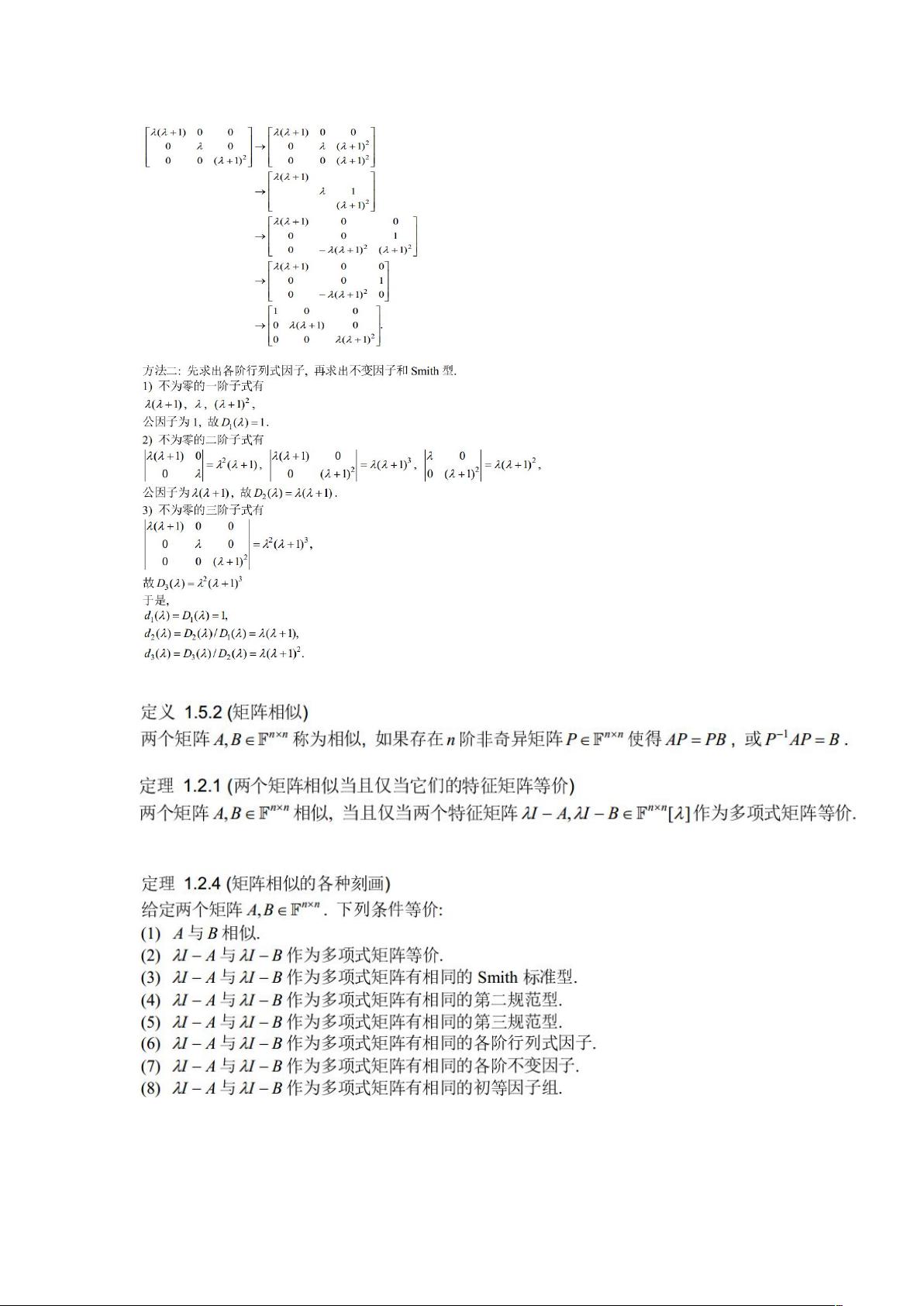

λ矩阵的行列式因子、不变因子和初等因子是矩阵理论中的核心概念,它们在研究矩阵的特征值和特征向量时起到关键作用。单位模阵,即单位矩阵In,是所有方阵中的一种特殊矩阵,它在矩阵运算中具有基础性地位。

λ矩阵的Smith标准型是一种特殊的对角形式,它在理解和处理线性映射的不变性质时非常有用。矩阵的相似性是一个重要的话题,它涉及到矩阵的对角化和Jordan标准型。两个矩阵相似意味着它们可以通过可逆矩阵的左乘和右乘相互转换,并且有相同的特征值和迹。

内积空间,特别是欧几里得空间,是向量空间的一个重要推广,其中定义了内积,使得可以计算向量的长度和角度。证明一个向量组是正交向量组,意味着这些向量之间的内积为零。施密特正交化过程可以将任意向量组转化为标准正交组,这对于理解和计算非常方便。

复矩阵的奇异值分解(SVD)是矩阵分析中的另一个核心工具,特别是在信号处理和数据分析中。SVD表达为A=UDVH,其中U和V是酉矩阵,D是对角矩阵,包含了A的奇异值。特征值为0的特征向量在SVD中有特别的含义。在复数域上,需要注意转置和共轭转置的使用,以及在求解λIn-AAH时符号的变化。

点到平面的距离可以通过投影矩阵和平面向量的运算来计算,首先找到平面的投影矩阵P,然后利用投影和向量的性质求解。正规矩阵是可以酉相似对角化的,这意味着在适当的基下,它可以被表示为对角矩阵,这对于理解和简化矩阵运算非常有用。

这份讲义深入探讨了矩阵分析的各个方面,不仅包括基本概念,也涉及了高级主题,为理解和应用线性代数提供了坚实的基础,特别是在机器学习和人工智能领域。

129 浏览量

159 浏览量

2025-01-09 上传

2025-01-09 上传

21电平MMC整流站、MMC逆变站、两端柔性互联的MATLAB仿真模型,4端柔性互联、MMC桥臂平均值模型、MMC聚合模型(四端21电平一分钟即能完成2s的工况仿真) 1-全部能正常运行,图四和图五为

2025-01-09 上传

2025-01-09 上传

invincible827

- 粉丝: 0

- 资源: 3

最新资源

- Pandas

- Platformer:仅具有浏览器功能的应用

- ssm海尔集团商务系统的设计毕业设计程序

- 手机接收单片机数据例程.zip

- notify-monitor:REST API可以观察任何新广告的给定URL,并将其发送到notify-client。 堆

- pgsync:将数据从一个Postgres数据库同步到另一个数据库

- Klaverjas Score-开源

- Simple Web Paint Application using JavaScrip

- Incremental-Adventure-Genesis:网页游戏(WIP)

- NET3.5 LINQ操作数据库实例_aspx开发教程.rar

- stm32 跑马灯实验+例程

- python之knnk近邻算法实现属性为连续性及混淆矩阵评估.zip

- g30l0:地理定位应用程序,用于在培训之前测试ESDK

- Kifu Generator-开源

- css-essentials-css-issue-bot-9000-midtown-web-071519

- chargeTracker