EM算法详解与在HMM中的应用

需积分: 9 164 浏览量

更新于2024-09-13

收藏 757KB PDF 举报

"本文主要介绍了EM算法的基本概念、在隐马尔科夫模型(HMM)中的应用以及Jensen不等式在EM算法推导过程中的作用。EM算法是一种处理含有隐含变量的优化问题的有效方法,常用于参数估计。文章首先回顾了Jensen不等式,它是凸函数和凹函数性质的一种体现,对于优化理论至关重要。接着,文章详细解释了EM算法的步骤,包括E步和M步,以及如何通过构建下界来逐步优化目标函数。在HMM中,EM算法被用来估计模型参数,解决隐藏状态不可观测的问题。"

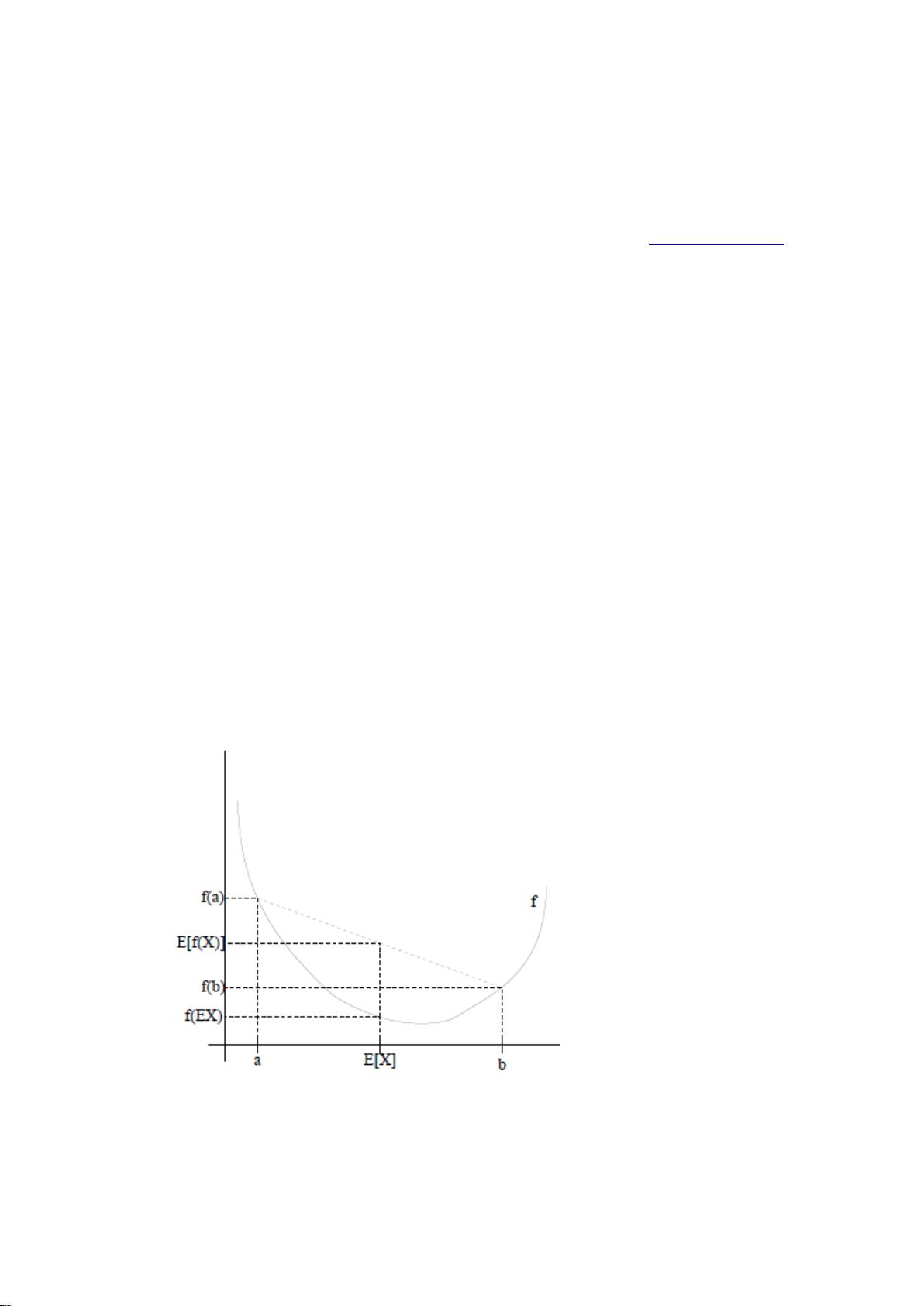

EM算法是一种迭代方法,主要用于含有未观测或隐含变量的概率模型的参数估计。在描述EM算法前,我们先了解Jensen不等式,它是EM算法推导的基础。Jensen不等式指出,如果一个函数f是凸函数,那么对于任何随机变量X,其期望值的函数值至少等于函数在期望值处的值。在EM算法中,这个不等式被用来构造目标函数的下界,即期望值(E步)和最大化(M步)之间的关系。

EM算法通常用于最大化带有隐藏变量的似然函数。在HMM中,EM算法可以帮助我们估计观察序列和隐藏状态间的转移概率以及发射概率。HMM是一个统计模型,其中观察序列是可见的,而隐藏状态是不可见的。在E步中,我们利用当前的参数估计计算每个样例的隐藏状态的后验概率分布;在M步中,我们固定这些后验概率,然后更新模型参数以最大化对数似然函数,即最大化每个样例的期望贡献。

具体来说,对于每个样例i,我们定义一个分布Q𝑖,它代表了隐藏变量z的分布。这个分布需要满足概率分布的特性,即所有z的Q𝑖之和为1。在E步,我们根据当前参数计算每个样例的Q𝑖;在M步,我们使用这些Q𝑖来更新参数,使似然函数的期望值最大。这个过程不断迭代,直到模型参数收敛,达到局部最优或全局最优。

EM算法的优点在于它能够处理非凸优化问题,并且在每次迭代中都能保证目标函数不会减少。然而,它并不保证找到全局最优解,可能会陷入局部最优。此外,EM算法对初始参数敏感,选择合适的初始值对于算法的收敛速度和结果质量至关重要。

在实际应用中,EM算法不仅在HMM中有广泛的应用,如语音识别、自然语言处理等领域,还被用于其他模型,如混合高斯模型(GMM)和贝叶斯网络。EM算法是一种强大的工具,能够有效地处理含有隐含变量的统计建模问题。

208 浏览量

2010-06-24 上传

2009-05-07 上传

2018-11-21 上传

2010-06-28 上传

2009-12-20 上传

2022-09-19 上传

2022-07-15 上传

lordvmxxx

- 粉丝: 1

- 资源: 1

最新资源

- 构建基于Django和Stripe的SaaS应用教程

- Symfony2框架打造的RESTful问答系统icare-server

- 蓝桥杯Python试题解析与答案题库

- Go语言实现NWA到WAV文件格式转换工具

- 基于Django的医患管理系统应用

- Jenkins工作流插件开发指南:支持Workflow Python模块

- Java红酒网站项目源码解析与系统开源介绍

- Underworld Exporter资产定义文件详解

- Java版Crash Bandicoot资源库:逆向工程与源码分享

- Spring Boot Starter 自动IP计数功能实现指南

- 我的世界牛顿物理学模组深入解析

- STM32单片机工程创建详解与模板应用

- GDG堪萨斯城代码实验室:离子与火力基地示例应用

- Android Capstone项目:实现Potlatch服务器与OAuth2.0认证

- Cbit类:简化计算封装与异步任务处理

- Java8兼容的FullContact API Java客户端库介绍