ACL'22 | 陈丹琦的CoFi模型剪枝:10倍加速,精度无损

版权申诉

135 浏览量

更新于2024-08-04

收藏 2.68MB PDF 举报

"ACL'22 _ 陈丹琦提出CoFi模型剪枝,加速10倍,精度几乎无损"

在当前的AI科技领域,深度学习模型的规模不断增大,这导致了推理速度变慢和计算资源的需求增加。为了应对这一挑战,研究人员一直在探索模型压缩技术,以提高模型的效率。模型剪枝和模型蒸馏是两种常见的模型压缩方法。陈丹琦在ACL'22大会上提出的CoFi模型剪枝方法,旨在解决传统剪枝方法加速效果有限以及模型蒸馏训练成本高的问题。

传统的模型剪枝策略通过移除对模型预测影响较小的参数来减少模型大小,然而,这种方法通常只能实现2-3倍的加速比,且可能牺牲一定的精度。另一方面,模型蒸馏虽然能提供更大的加速比,保持较好的推理精度,但需要大量无标签数据进行预训练,增加了训练成本。

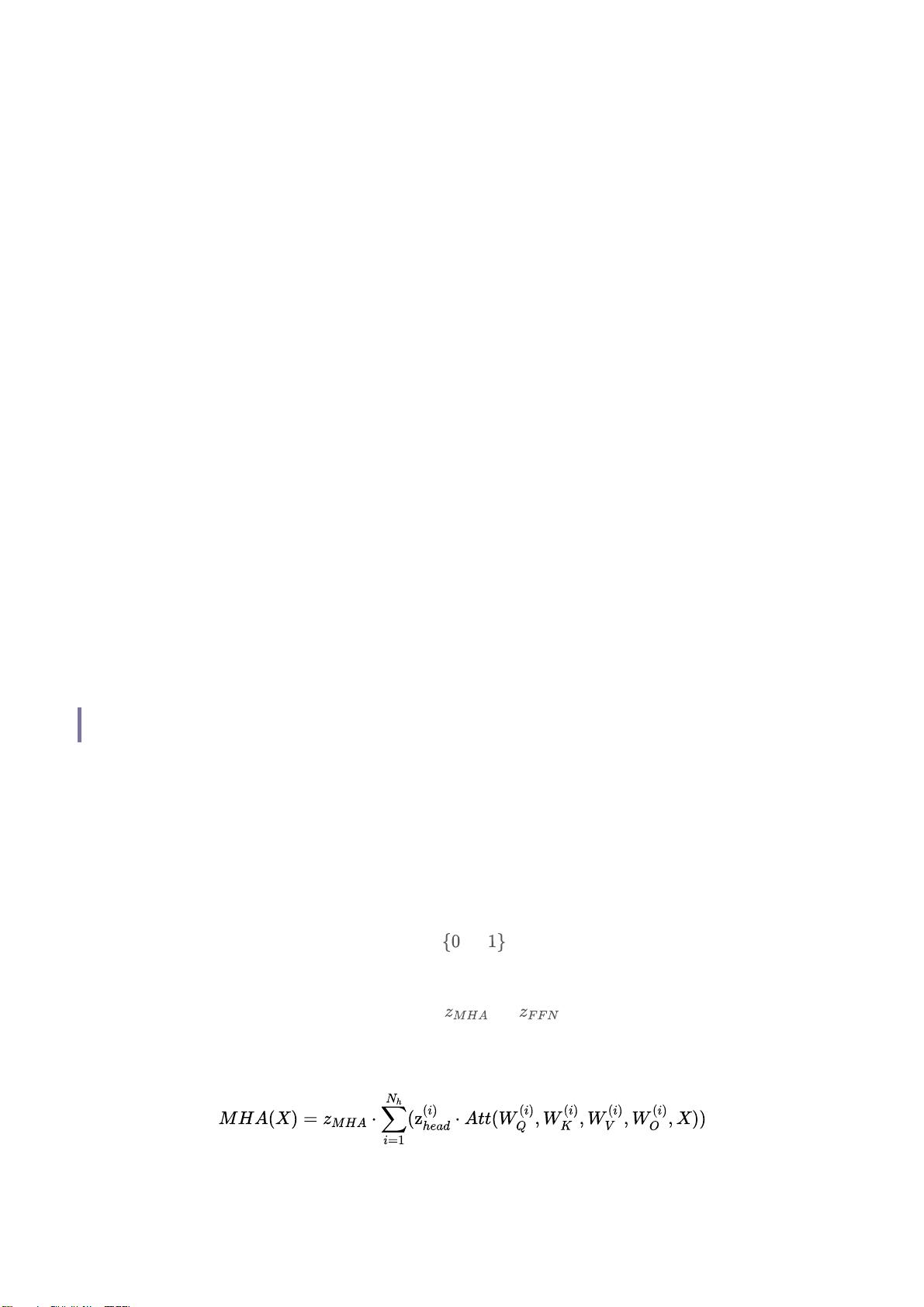

陈丹琦的CoFi(Confidence-based Filter Pruning)模型剪枝方法则提供了一个新颖的解决方案。该方法的核心思想是基于参数的置信度来进行剪枝,通过对模型参数的重要性进行更精准的评估,实现更大程度的压缩,同时保持近乎无损的精度。论文《Structured Pruning Learns Compact and Accurate Models》详细介绍了这种方法,它通过结构化剪枝策略,不仅显著提高了模型的加速比,达到了10倍之多,而且还有效地控制了精度损失。

在实际应用中,CoFi剪枝技术可能对边缘计算设备特别有益,这些设备通常资源有限,需要高效运行的模型。此外,由于其降低了训练成本,CoFi也适用于那些数据获取和计算资源有限的场景。通过这种方式,陈丹琦的这项工作为深度学习模型的优化提供了新的思路,有望推动AI技术在效率与性能之间找到更好的平衡。

论文链接和GitHub地址分别为:https://arxiv.org/pdf/2204.00408.pdf 和 https://github.com/princeton-nlp/CoFiPruning,感兴趣的读者可以深入研究,了解具体的技术实现和实验结果。这一创新方法的出现,对于AI领域的模型优化和实际应用具有重要的意义。

2023-10-18 上传

2023-08-13 上传

2023-10-11 上传

2023-10-18 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

地理探险家

- 粉丝: 1253

- 资源: 5601

最新资源

- 开源通讯录备份系统项目,易于复刻与扩展

- 探索NX二次开发:UF_DRF_ask_id_symbol_geometry函数详解

- Vuex使用教程:详细资料包解析与实践

- 汉印A300蓝牙打印机安卓App开发教程与资源

- kkFileView 4.4.0-beta版:Windows下的解压缩文件预览器

- ChatGPT对战Bard:一场AI的深度测评与比较

- 稳定版MySQL连接Java的驱动包MySQL Connector/J 5.1.38发布

- Zabbix监控系统离线安装包下载指南

- JavaScript Promise代码解析与应用

- 基于JAVA和SQL的离散数学题库管理系统开发与应用

- 竞赛项目申报系统:SpringBoot与Vue.js结合毕业设计

- JAVA+SQL打造离散数学题库管理系统:源代码与文档全览

- C#代码实现装箱与转换的详细解析

- 利用ChatGPT深入了解行业的快速方法论

- C语言链表操作实战解析与代码示例

- 大学生选修选课系统设计与实现:源码及数据库架构