一元线性回归的梯度下降法实践

版权申诉

39 浏览量

更新于2024-07-03

收藏 766KB DOCX 举报

"该资源是一个关于机器学习的上机作业,主要内容聚焦于使用梯度下降法进行一元线性回归的实践。作业涉及到算法描述、步骤解析以及MATLAB程序代码的编写与解释。"

在机器学习领域,一元线性回归是一种基本的预测模型,用于分析两个变量之间的线性关系。在给定的数据集中,目标是找到一条直线(回归线)最佳地拟合这些数据点,以便于对未来观测值进行预测。梯度下降法是优化算法的一种,常被用来寻找损失函数最小化的参数。

一、算法描述与步骤:

1. 初始化:首先,我们需要对模型参数θ进行初始化,这可以是随机选择的数值或全零向量。

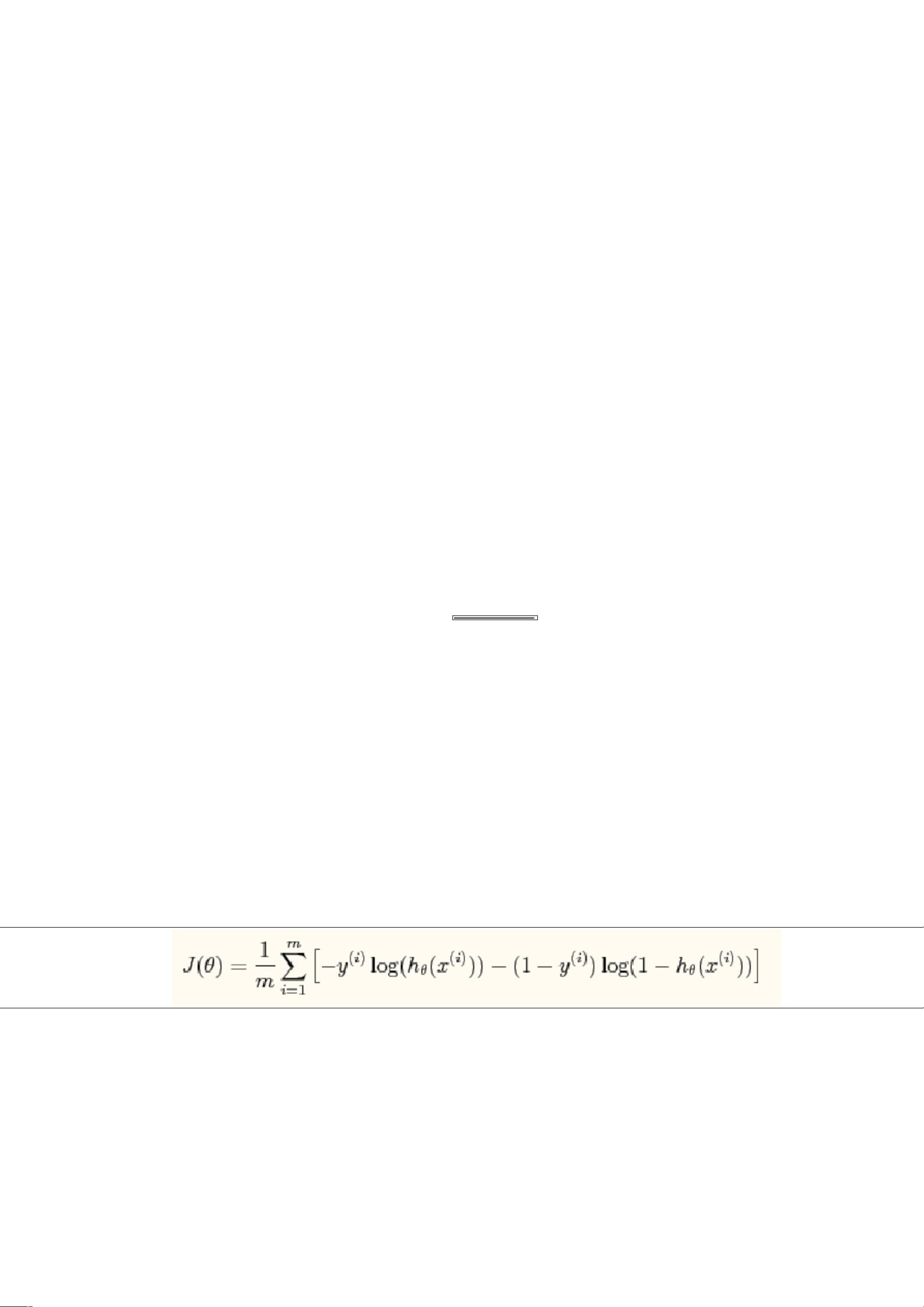

2. 损失函数定义:损失函数J(θ)通常采用均方误差,即所有样本预测值与真实值之差的平方和的平均值。

3. 梯度计算:对损失函数J(θ)求偏导数,得到梯度,它指示了损失函数减少最快的方向。

4. 参数更新:按照梯度的反方向更新θ,以减小损失函数的值。更新公式通常写作θ = θ - α * ∇J(θ),其中α是学习率,控制每次更新的步长。

5. 迭代过程:重复步骤3和4,直到梯度的范数小于某个预设阈值或达到最大迭代次数。

二、MATLAB程序代码及解释:

这段MATLAB代码执行以下操作:

1. 清除工作空间并加载数据。

2. 分离输入变量x和输出变量y,并绘制数据点。

3. 定义符号变量θ0和θ1,初始化θ0和θ1为1。

4. 设置学习率α为0.005。

5. 使用while循环进行梯度下降迭代,直到梯度范数小于0.3。

6. 在循环内,计算损失函数J的总和,然后除以数据点的数量得到平均损失。

7. 计算损失函数对θ0和θ1的梯度,更新θ值。

8. 当梯度范数小于0.3时,退出循环。

通过上述步骤,代码将逐步调整θ0和θ1,使一元线性回归模型更接近数据集的内在规律,从而实现对新数据的有效预测。这种基础的机器学习技术在许多实际应用中都有广泛的应用,如数据分析、预测建模等。

2021-11-06 上传

2022-09-26 上传

2021-11-23 上传

2022-06-14 上传

2022-11-16 上传

2022-10-14 上传

2022-07-09 上传

2021-12-22 上传

2022-06-16 上传

春哥111

- 粉丝: 1w+

- 资源: 6万+

最新资源

- scoop-bucket

- QuickFork:QuickFork允许您从git repo创建符号链接

- Urban Abodes Craigslist Posting-crx插件

- obdgpslogger-0.15.zip_GPS编程_Unix_Linux_

- afs42d-开源

- 人工智能学习课程练习.zip

- 参考资料-409.混凝土拌合用水质量检查报告.zip

- matlab心线代码-electrostatic-simulation-tools:我有效使用SIMION进行电子和离子光谱仪设计的工具(VM

- sysdigcloud-kubernetes:Kubernetes上的Sysdig Cloud

- 你好,世界

- opencv_test.rar_视频捕捉/采集_Visual_C++_

- familyline-server-test:测试服务器,提供有关Familyline网络协议的想法

- torch_sparse-0.6.10-cp39-cp39-win_amd64whl.zip

- matlab人脸检测框脸代码-ait-research-study-finished:我的研究的最终版本

- 人工智能经典算法Python实现.zip

- benjamingeets