机器学习模型评估:策略与过拟合控制

需积分: 10 73 浏览量

更新于2024-07-15

1

收藏 623KB PPTX 举报

机器学习模型评估是机器学习过程中至关重要的环节,它旨在通过实验手段测量学习器的性能表现,以便对其进行有效评估和优化。模型评估不仅关注学习器在训练集上的表现,更关键的是考察其在未见过的新数据上的泛化能力,即泛化误差。泛化误差是指学习器在实际应用中对新样本的预测准确度,与训练误差(训练样本上的误差)相区别。

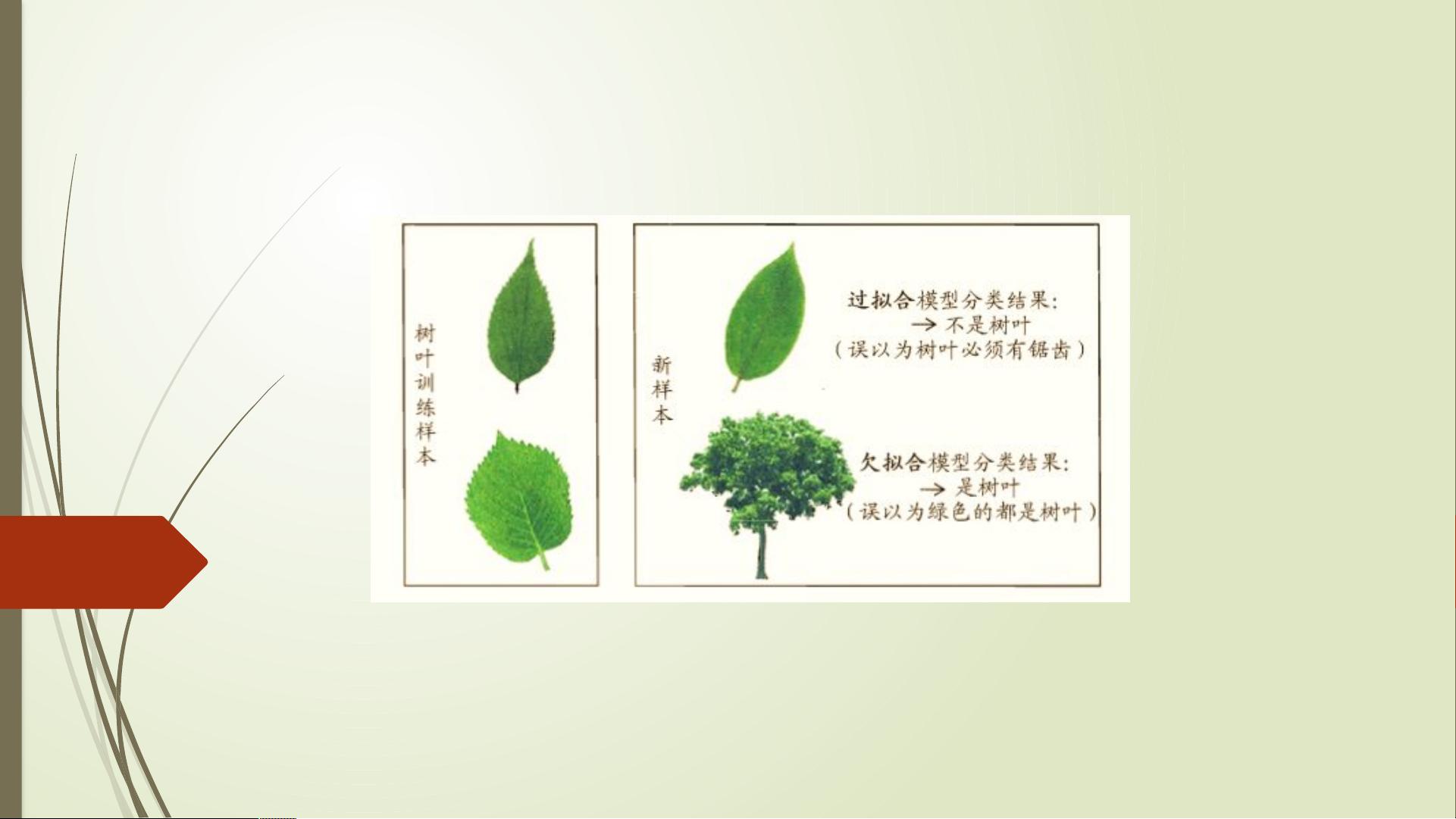

评估模型性能通常采用精度(Accuracy)、错误率(Error Rate)和误分类率等指标。精度是正确分类的样本数占总样本数的比例,而错误率则是错误分类的样本数所占比例。过拟合(Overfitting)和欠拟合(Underfitting)是评估中需要注意的现象。过拟合指的是学习器过于适应训练数据的特性,导致在新样本上的表现下降;欠拟合则是指学习器未能充分捕捉数据的规律,表现为训练误差较大。为了减少过拟合,可以通过调整模型复杂度、增加训练数据或者使用正则化等技术。

模型评估常用的方法之一是交叉验证(如留出法),它将数据集划分为训练集和测试集,保证了数据分布的一致性和随机划分的稳定性。留出法的具体实施步骤包括:

1. **分层采样**:确保在划分过程中,训练集和测试集的类别分布保持一致,避免因为随机划分导致类别比例失衡,从而引入额外的偏差。

2. **多次随机划分**:即使采用了分层采样,仍需进行多次划分并取平均值,以提高结果的稳定性和可靠性。

3. **K折交叉验证**:将数据集分为K个子集,依次用其中K-1个子集作为训练集,剩下的一个子集作为测试集,重复K次,最终将所有测试集的结果汇总,得到更稳定的性能估计。

除了以上方法,还有一些其他的评估策略,比如自助采样(Bootstrap)、留一法等,它们都有各自的优缺点,适用于不同的场景。模型评估是一个迭代过程,根据评估结果调整模型参数和算法,以期达到最佳的泛化性能,这是机器学习项目成功的关键步骤。

2021-11-26 上传

2022-01-25 上传

2024-11-01 上传

2024-11-01 上传

2024-11-01 上传

2024-11-01 上传

2023-02-15 上传

2024-11-01 上传

weixin_52017857

- 粉丝: 2

- 资源: 1

最新资源

- 平尾装配工作平台运输支撑系统设计与应用

- MAX-MIN Ant System:用MATLAB解决旅行商问题

- Flutter状态管理新秀:sealed_flutter_bloc包整合seal_unions

- Pong²开源游戏:双人对战图形化的经典竞技体验

- jQuery spriteAnimator插件:创建精灵动画的利器

- 广播媒体对象传输方法与设备的技术分析

- MATLAB HDF5数据提取工具:深层结构化数据处理

- 适用于arm64的Valgrind交叉编译包发布

- 基于canvas和Java后端的小程序“飞翔的小鸟”完整示例

- 全面升级STM32F7 Discovery LCD BSP驱动程序

- React Router v4 入门教程与示例代码解析

- 下载OpenCV各版本安装包,全面覆盖2.4至4.5

- 手写笔画分割技术的新突破:智能分割方法与装置

- 基于Koplowitz & Bruckstein算法的MATLAB周长估计方法

- Modbus4j-3.0.3版本免费下载指南

- PoqetPresenter:Sharp Zaurus上的开源OpenOffice演示查看器