Kubernetes与AI融合实践:从零开始的架构解析

版权申诉

90 浏览量

更新于2024-06-14

收藏 3.48MB PDF 举报

"Kubernetes 与 AI 相结合架构 落地解析(从 0 到 1)"

在当今的云计算和大数据时代,Kubernetes 和人工智能(AI)的结合已经成为推动技术创新的重要驱动力。这份资料深入解析了如何从零开始构建一个将 Kubernetes 与 AI 结合的架构,由技术总监赵慧智分享,涵盖了从 Kubernetes 的基础知识到 AI 技术的介绍,以及两者如何融合应用。

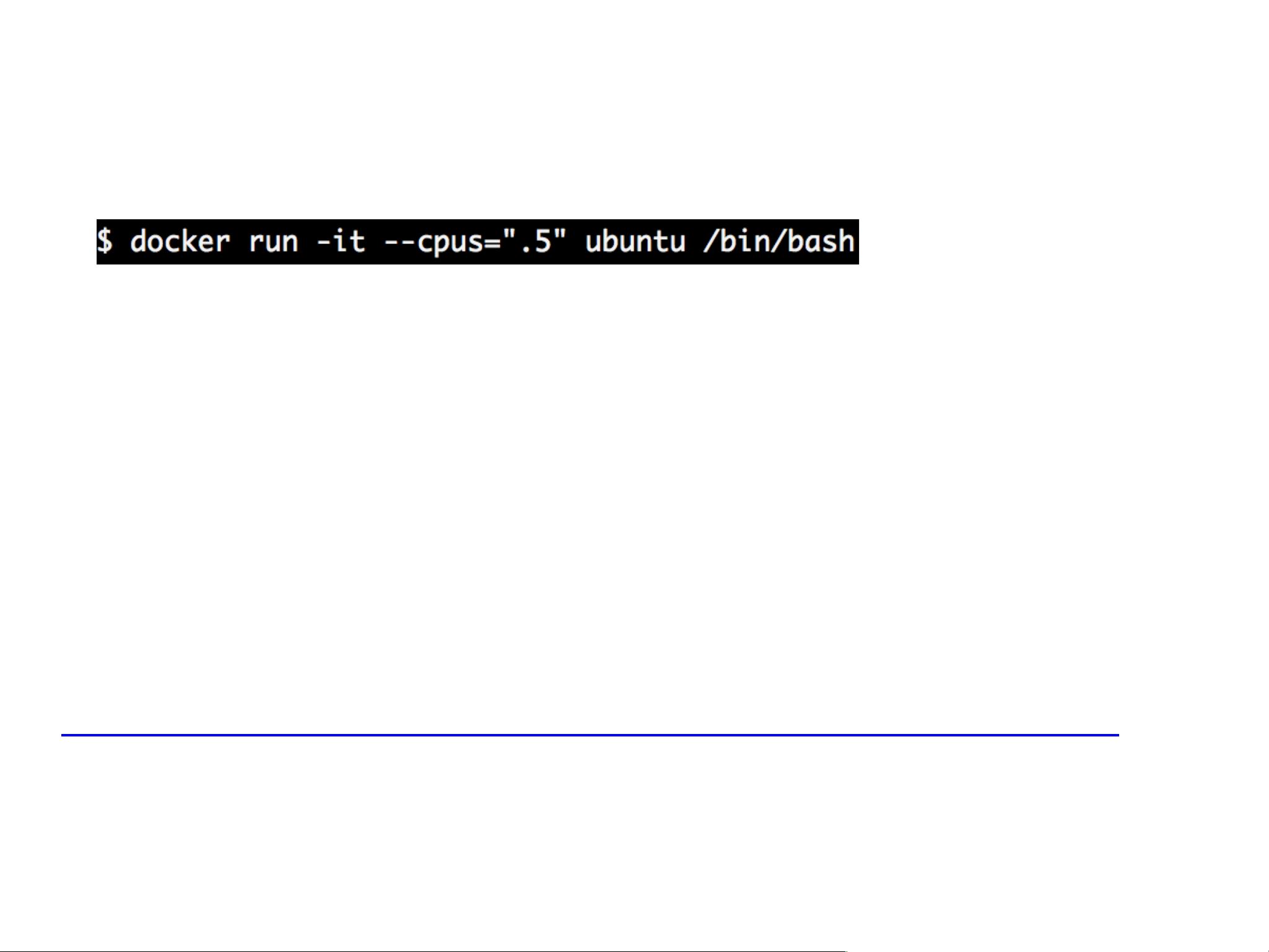

Kubernetes 是一个开源的容器编排系统,它允许开发者和运维人员自动化部署、扩展和管理容器化的应用程序。Kubernetes 提供了一系列功能,如自动部署、弹性扩容、负载均衡和应用无缝升级。其核心设计原则是硬件隔离,通过 Linux 容器(LXC)技术实现资源的高效利用。LXC 利用内核的 cgroups 和 namespace 实现了软硬件环境的隔离,使应用程序能在独立的容器环境中运行。

容器框架,如 Docker,是 Kubernetes 运行的基础。Docker 提供了一个标准化的容器格式,称为 Container Image,用于打包应用程序及其依赖环境。这些镜像可以通过 Docker Registry 进行管理和分发,便于版本控制和重复使用。OCI(Open Container Initiative)是一个旨在制定容器格式和运行时开放标准的组织,确保跨平台的兼容性。

Kubernetes 架构中,Node 是基础单元,每个 Node 都是集群中的工作节点,承载 Pod(Kubernetes 的基本部署单位)运行。Pod 包含一个或多个紧密相关的容器,共享存储和网络资源。此外,Kubernetes 提供了服务发现、存储编排、网络策略等功能,使得大规模分布式 AI 应用的管理变得更为简便。

AI 技术方面,随着深度学习和机器学习的发展,AI 云平台成为了训练和部署模型的关键基础设施。这些平台通常由计算资源、数据存储、模型管理和服务接口等组件构成。当 Kubernetes 与 AI 云平台结合时,可以实现 AI 模型的动态调度、资源优化和自动扩缩容,极大地提升了 AI 工作负载的灵活性和效率。

在实际落地过程中,将 AI 模型部署到 Kubernetes 集群,需要考虑数据处理、模型训练、推理服务等多个环节的集成。这可能涉及到 TensorFlow、PyTorch 等深度学习框架,以及 Inference Serving、Seldon Core 等服务化解决方案。通过 Kubernetes 的 API,开发者可以轻松地将 AI 应用程序部署到集群中,同时利用 Kubernetes 的自动扩展能力应对变化的流量需求。

这份资料提供了从理论到实践的全面指导,帮助读者理解如何将 Kubernetes 的强大功能应用于 AI 架构,从而实现高效的 AI 解决方案部署和管理。对于想要在 Kubernetes 上构建和运行 AI 应用的开发团队来说,这是一个宝贵的资源。

2019-08-29 上传

2023-07-21 上传

2021-07-07 上传

百态老人

- 粉丝: 5440

- 资源: 2万+

最新资源

- Android圆角进度条控件的设计与应用

- mui框架实现带侧边栏的响应式布局

- Android仿知乎横线直线进度条实现教程

- SSM选课系统实现:Spring+SpringMVC+MyBatis源码剖析

- 使用JavaScript开发的流星待办事项应用

- Google Code Jam 2015竞赛回顾与Java编程实践

- Angular 2与NW.js集成:通过Webpack和Gulp构建环境详解

- OneDayTripPlanner:数字化城市旅游活动规划助手

- TinySTM 轻量级原子操作库的详细介绍与安装指南

- 模拟PHP序列化:JavaScript实现序列化与反序列化技术

- ***进销存系统全面功能介绍与开发指南

- 掌握Clojure命名空间的正确重新加载技巧

- 免费获取VMD模态分解Matlab源代码与案例数据

- BuglyEasyToUnity最新更新优化:简化Unity开发者接入流程

- Android学生俱乐部项目任务2解析与实践

- 掌握Elixir语言构建高效分布式网络爬虫