强化学习笔记:伯克利CS285前10讲重点概览

需积分: 9 91 浏览量

更新于2024-07-15

收藏 7.17MB DOCX 举报

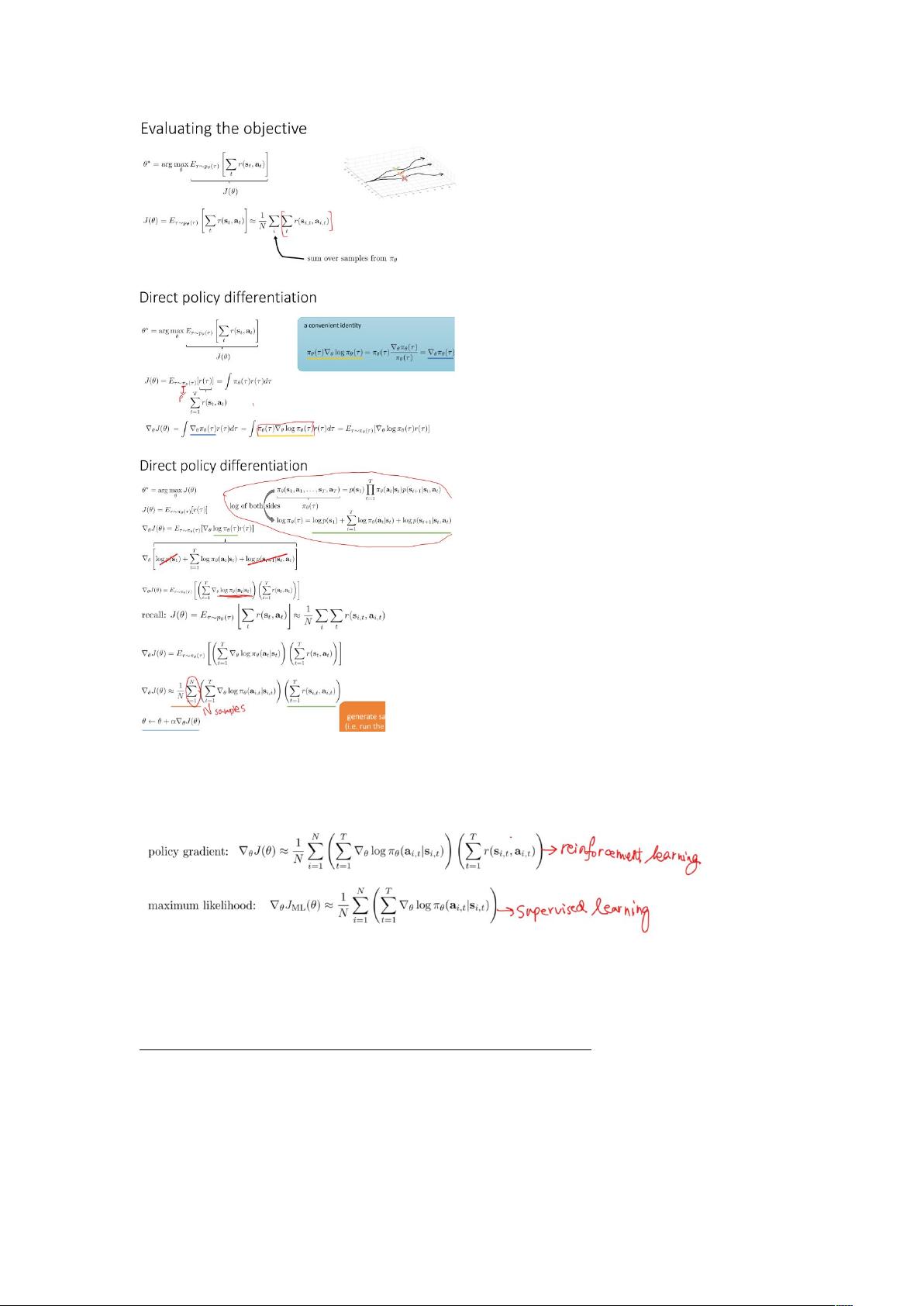

"Berkeley CS285 强化学习笔记涵盖了强化学习的基础概念和重要算法,主要讨论了马尔可夫决策过程(Markov Decision Process, MDP)和部分可观测马尔可夫决策过程(Partially Observed Markov Decision Process, POMDP),并涉及Q函数、值函数、策略学习以及批评网络对策略的优化等内容。"

在强化学习中,马尔可夫性质(Markov Property)是关键概念,它指出系统当前状态完全决定了未来的发展,而与过去的历史状态无关。这使得强化学习问题可以通过状态转移概率来建模,简化了问题的复杂性。

行为学习的问题在于,当机器出现轻微错误时,可能会遇到未学习过的情况,导致更多错误,从而逐渐偏离学习到的行为模式。Dagger算法被提出来解决这个问题,但步骤3需要大量数据集,且在涉及记忆时会面临挑战,例如过多的输入可能导致过拟合。

部分可观测马尔可夫决策过程(POMDP)是强化学习的一个扩展,考虑了环境信息的不完全可观察性。在这种情况下,智能体必须依赖于观测历史来推断隐藏状态,增加了学习的复杂度。

Q函数和值函数是评估策略的关键工具,它们分别表示在给定策略下,从某个状态出发,未来可能获得的累积奖励的期望。强化学习的基本思想是通过不断调整策略,使好的状态更可能出现,坏的状态更少发生。

在优化J(θ)梯度的过程中,添加基线是为了减少方差,提高学习效率。实践中,可以采用固定的或随时间变化的基线;理论上,基线应保持策略的期望回报不变。政策学习分为两类:策略学习(on-policy learning)和离策略学习(off-policy learning)。在离策略学习中,学习的策略与执行的策略不一致,如Q-learning。

批评网络(Critic)用于改进策略,通过估计值函数来指导策略的更新,例如在Actor-Critic算法中,批评网络负责评估演员(Actor)提出的行动策略,从而实现策略的迭代优化。这种结合策略和值函数的方法是强化学习中的一种有效策略优化技术。

132 浏览量

2021-10-07 上传

124 浏览量

156 浏览量

138 浏览量

110 浏览量

2019-11-10 上传

yuanye_shift

- 粉丝: 0

- 资源: 6

最新资源

- 数独游戏_副本1_snakes3t_C++_easyX_数独_图形界面_

- Areeba客户驱动任务

- ConsoleGIF:控制台和基于Java的动画GIF编码器。-开源

- Semtech公司LoRa技术资料.rar

- Oracle数据库客户端instantclient21.6系列文件

- Newstrition (Legacy)-crx插件

- java写webapi源码-apidoc-master:apidoc-master

- srping4.1.6核心包_spring4.1.6_

- simple-game-server-js:用JavaScript编写的简单的多人,基于回合的游戏服务器

- 乌鲁木齐水系数据.rar

- Ponder-crx插件

- testingasp-v3

- Oracle数据库客户端instantclient19.16系列文件

- Test:这是我的第一次经历

- 【ssm项目源码】信息管理系统.zip

- G84攻丝循环_g31跳转指令_g84指令格式_G84攻丝程序_g31指令_G84消除指令_