利用Django、Celery和Redis部署高效定时任务与多队列管理

版权申诉

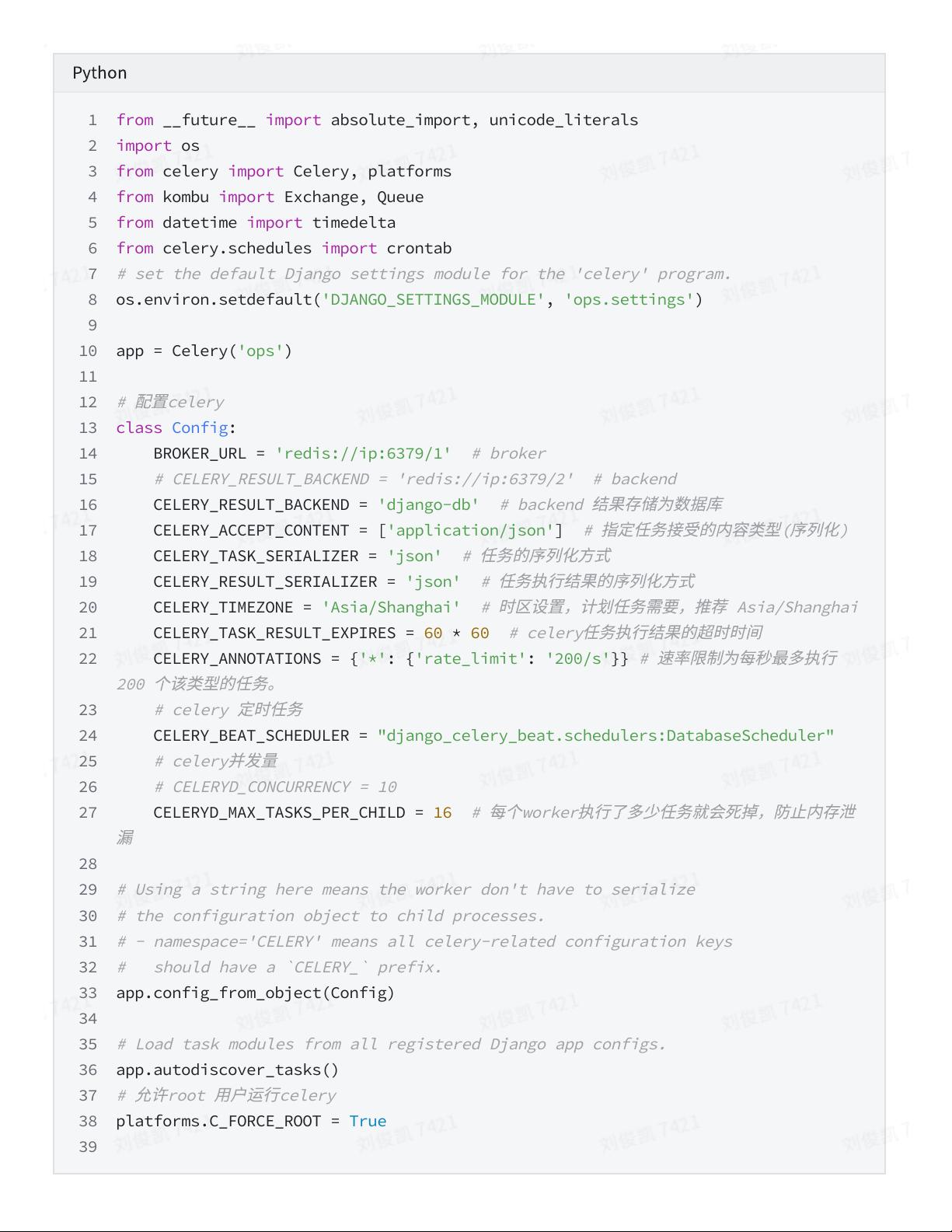

本文档主要探讨如何在Python的Django框架中集成Celery和Redis来部署定时任务,并实现多工作(worker)、多队列的高效管理。Celery是一个强大的分布式任务队列和任务调度工具,它设计用于处理大量消息,支持实时处理和任务调度。其核心组件包括:

1. Celery Worker:作为任务的执行者,负责接收并处理来自任务队列的任务。多台Worker可以提高任务执行的并行性和吞吐量。

2. Celery Beat:作为任务调度器,定期从配置文件中读取任务,并将其添加到队列中,确保定时任务的执行。

3. Broker(消息代理):如RabbitMQ或Redis,作为队列系统,存储生产者发送的任务,并在适当的时候分发给Worker。官方推荐使用RabbitMQ,但Redis也可作为备选。

4. Producer(任务生产者):通过Celery API或函数调用创建任务,并将其提交到broker,开始任务流程。

5. Result Backend:存储任务执行的结果和状态信息,以便后续查询。支持多种后端选项,如AMQP、Redis、MongoDB等。

6. 特性与优势:

- 易于监控任务执行情况,包括成功/失败状态、执行时间等。

- 支持管理后台和命令行操作,方便任务的添加、更新和删除。

- 可以关联任务和配置,提升管理灵活性。

- 提供多线程、多进程模型,以及错误处理机制。

- 允许任务分组、拆分和调用链,增强任务处理的复杂性。

- 语言无关性,支持Python等语言的接口。

通过结合Django、Celery和Redis,开发者能够构建高效、可靠的分布式任务处理系统,解决定时任务的重复执行问题,并确保任务的稳定、灵活运行。这对于任何需要处理大量并发任务或者需要在不同环境间进行任务分发的项目来说,都是非常有价值的资源。

2020-09-16 上传

2020-12-16 上传

2020-09-09 上传

2020-09-19 上传

点击了解资源详情

2023-05-12 上传

2023-06-08 上传

2023-12-22 上传

day>day>up

- 粉丝: 10

- 资源: 2

最新资源

- TuringMachines:图灵机计算模拟器

- Sage Bionetworks-开源

- QT AES CBC加密和解密

- godesim:ODE系统求解器变得简单。 对于IVP(初始值问题)

- react-query-essentials:React Query Essentials课程的模块源代码

- 根据 RSS 订阅源抓取最新前端技术文章,来源:Node Weekly、JavaScript Weekly、前端早读.zip

- 盲信号处理,多源信号分析

- fl0htest

- 易语言-易语言文件夹加密软件

- ng-file-input:ngModel指令用于文件输入

- Layout Ultimate 2006-开源

- 电信设备-基于两级数字下变频的雷达工作信道采集系统及其方法.zip

- Symfony-Algolia

- skull:Skull位于Backbone的顶部,可保护您的应用程序的大脑

- weatherApp:使用 Weather Underground API 的 weatherApp,用 JavaScript 编写

- RPMA回传+ Arduino Yun –第3部分-项目开发