深度解析Transformer架构的发展历程及其未来趋势

100 浏览量

更新于2025-03-20

收藏 3.9MB PDF 举报

知识点详细解析:

1.Transformer架构的过去和现在

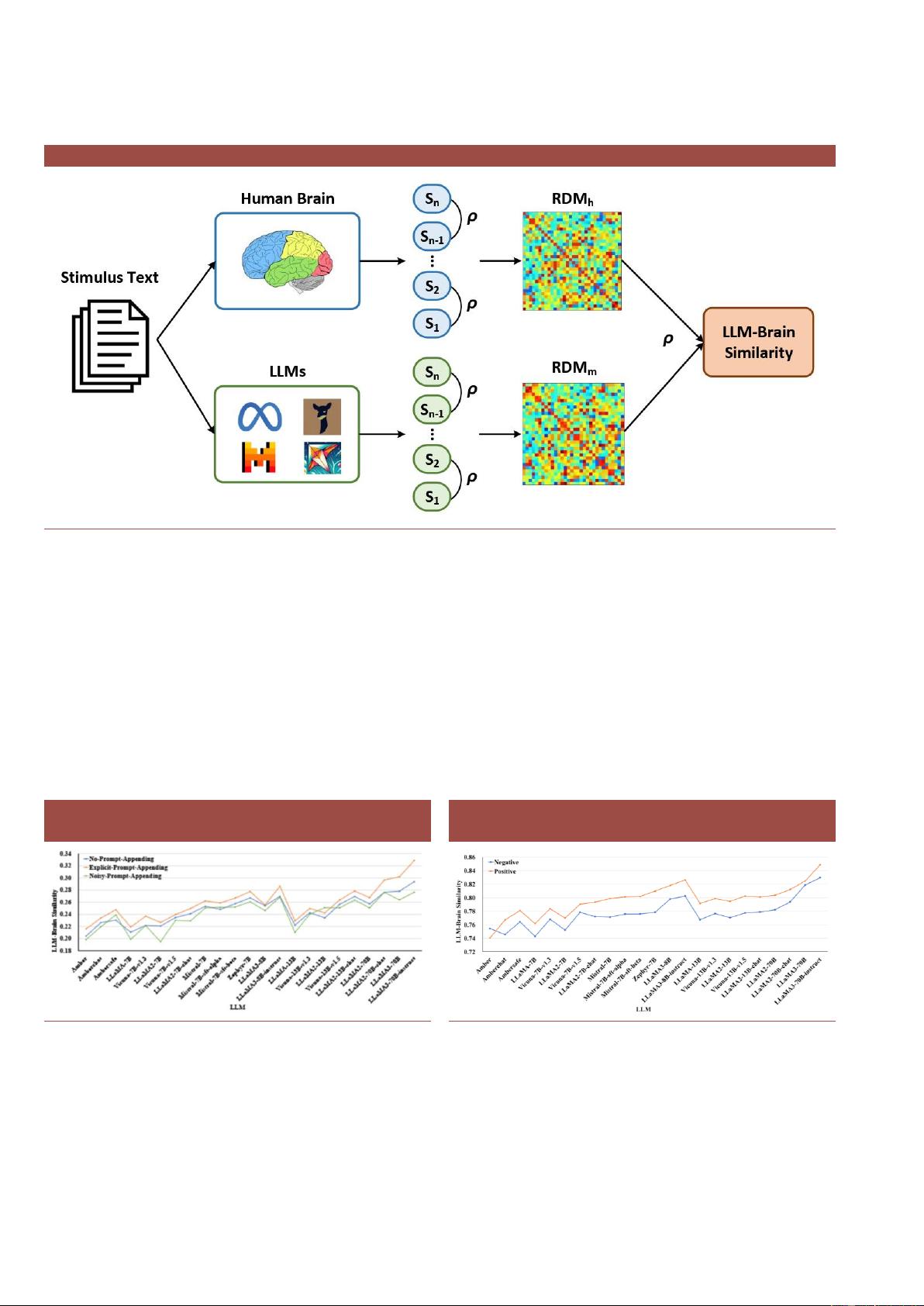

- 1.1 人脑带来的启示:数据的无损压缩

数据的无损压缩概念源于人脑处理信息的方式,人类的大脑能够高效处理复杂信息,并且在处理过程中不丢失关键数据。在Transformer架构的设计中,借鉴了这种处理机制,从而实现对数据的高效编码与解码。这一部分强调了数据压缩技术在模型构建中的重要性,并对无损压缩在Transformer中的应用进行了探讨。

- 1.2 Transformer应运而生:Attention is all you need

“Attention is all you need”是Google发表的一篇论文,首次提出了一种新颖的模型结构,即Transformer。这篇论文标志着自然语言处理(NLP)领域的一个重大突破,因为Transformer完全基于自注意力(self-attention)机制,它能够有效地捕捉序列内各元素之间的依赖关系,无需传统的循环神经网络结构(RNN)或卷积神经网络结构(CNN)。Transformer能够处理长距离依赖问题,并提高了处理速度和训练效率。

- 1.3 Transformer的优势:规模扩展、多模态能力

Transformer模型的一个显著优势是其在规模上的可扩展性,这使得模型可以轻松地通过增加层数或参数量来获得更好的性能。随着计算资源的不断提升,大型Transformer模型在各种任务中取得了令人瞩目的成绩。此外,Transformer展示出了处理多模态数据的能力,比如结合文本、图像和声音等不同模态的信息,为解决复杂问题提供了新的可能性。

2.Transformer架构的未来

- 2.1 Transformer架构的局限性

尽管Transformer在许多方面表现出色,但它也存在一些局限性。例如,由于模型参数量巨大,训练和推理成本都非常高,这对于计算资源是一种巨大的挑战。此外,模型的可解释性和对偏见数据的敏感性也是需要解决的问题。Transformer模型过于依赖大规模数据集,可能会导致模型过拟合,并且难以适应不同的语言或领域。

- 2.2 Transformer架构的挑战者

随着对Transformer架构的深入研究,研究人员开始尝试寻找或设计能够克服当前局限性的新型模型。这可能包括改进的自注意力机制、新的网络结构、更高效的训练算法等。在未来的发展中,这些挑战者模型将对现有的Transformer架构形成竞争,推动模型向更加高效、准确和鲁棒的方向发展。

综上所述,Transformer架构自提出以来已经在多个领域取得了突破性的成果,其设计理念和方法对于深度学习模型的发展产生了深远的影响。然而,为了应对现实世界中多样化的挑战,Transformer需要不断地进行优化和创新。未来的发展趋势可能会朝向模型的轻量化、提高效率、增强可解释性以及对偏见的处理能力等多个方面。此外,Transformer的多模态能力和跨领域的泛化能力也将成为研究的热点,有望推动人工智能技术在更多领域取得应用突破。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-12-31 上传

2021-12-25 上传

2025-03-07 上传

2024-07-19 上传

1022 浏览量

2021-07-22 上传

AI方案2025

- 粉丝: 1325

最新资源

- HTML5广告展示技术:Flash+XML图片轮播

- STM32 DSP库更新:包含FFT算法及完整文档

- C#控件属性全面解析与教程指南

- Firebase云通知功能实现与PuTTY测试工具使用指南

- Flexbox布局实战项目:项目开发深入解析

- 创新横向滚动展示技术:带倒影的图片展

- Python+PyQt5教程:自定义槽函数调用及可视化编辑示例

- Winform实现Word2007样式的调用及控件导航

- 实现图片轮换播放效果的JavaScript技术

- libxml2与libxslt测试压缩包解析

- 轻量级PDF电子书阅读器软件发布

- 学生成绩管理系统:初学者实践教程

- 奇瑞汽车VIN码转PIN码计算器 便捷安全操作

- VC2005环境成功编译X264源码教程(附代码)

- 全面的MSP430库文件分享:实用库文件大集合

- HD2刷机包及电脑辅助软件下载指南