深度学习神经网络设计与优化教程概览

需积分: 9 189 浏览量

更新于2024-07-16

收藏 44.94MB PDF 举报

本教程深入探讨了深度神经网络(DNN)的关键设计要素以及在硬件架构、开发资源、计算模型优化、加速器选择、评估指标和训练过程等方面的重要内容。首先,参与者将对深度学习和人工智能的基本概念有深刻理解,包括机器学习,特别是其赋予计算机无需明确编程就能学习的能力的概念,这是由Arthur Samuel在1959年提出的。

在硬件架构部分,教程将介绍DNN的不同实现方式,重点关注微控制器的硬件架构,如Eyeball异构计算平台,它展示了如何通过硬件优化来支持深度学习任务。了解这些架构有助于决策者根据具体应用需求选择最适合的硬件基础。

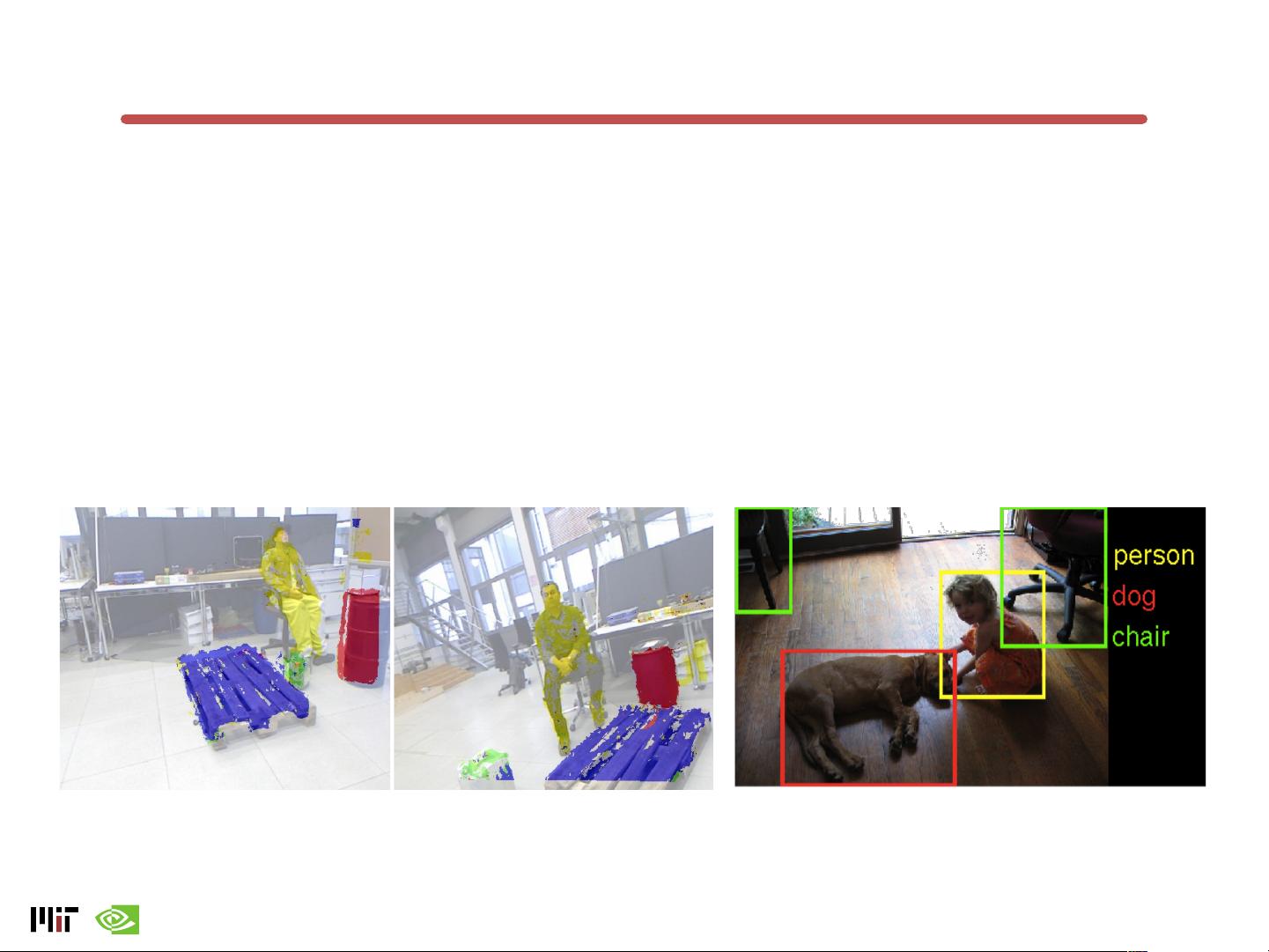

接下来,演讲者将提供丰富的开发资源,包括工具、库和框架,如TensorFlow、PyTorch等,以指导开发人员构建和部署DNN。对于DNN的计算模型,会涵盖卷积神经网络(CNN)、循环神经网络(RNN)等核心类型的内部工作原理及其在实际场景中的应用。

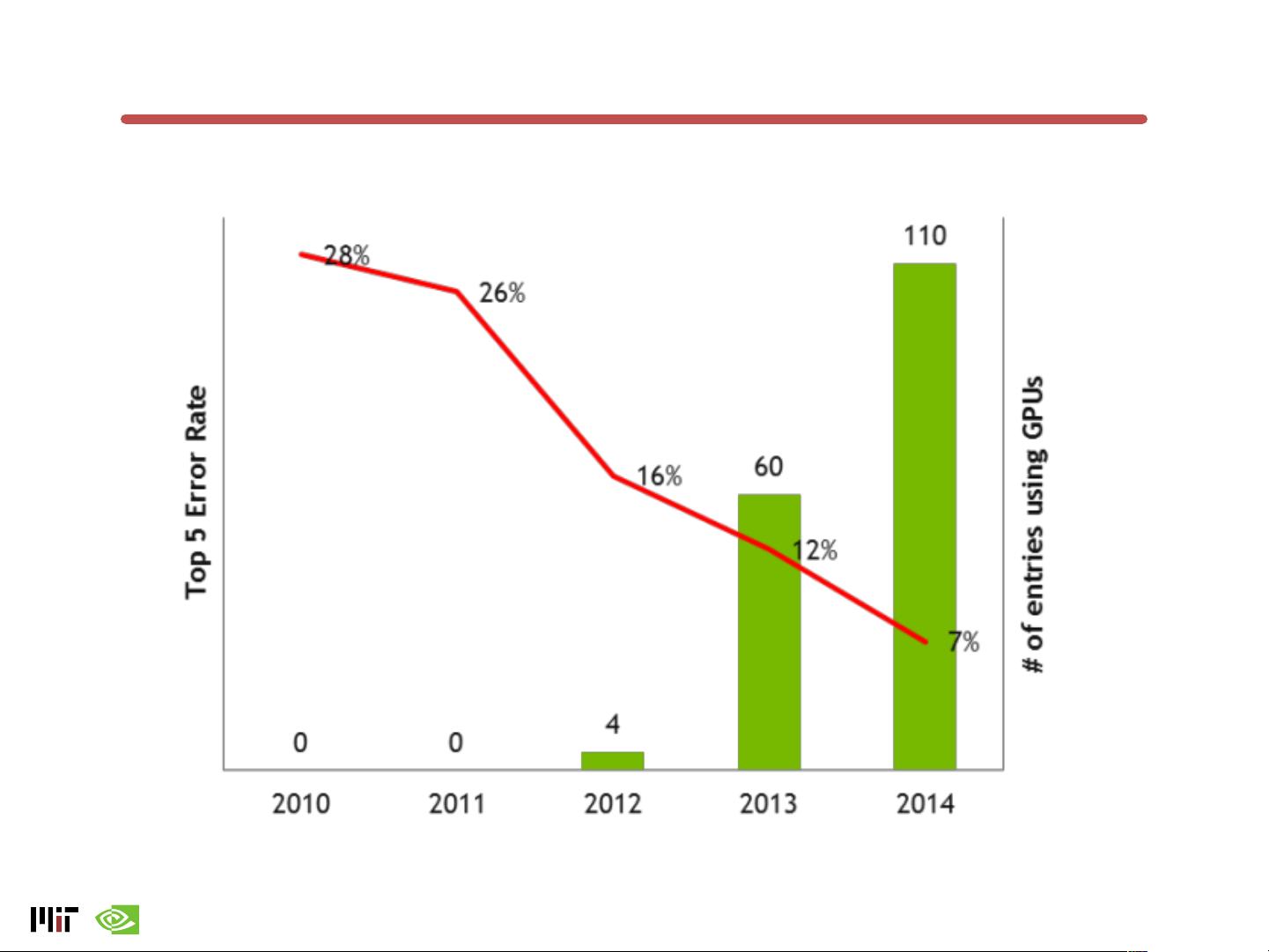

在DNN加速器方面,教程将讨论如何通过专门设计的硬件来加速神经网络运算,例如GPU、TPU(Google的张量处理单元)和ASIC(专用集成电路)等。这些加速器的比较分析将帮助理解它们在性能、能耗和成本上的权衡。

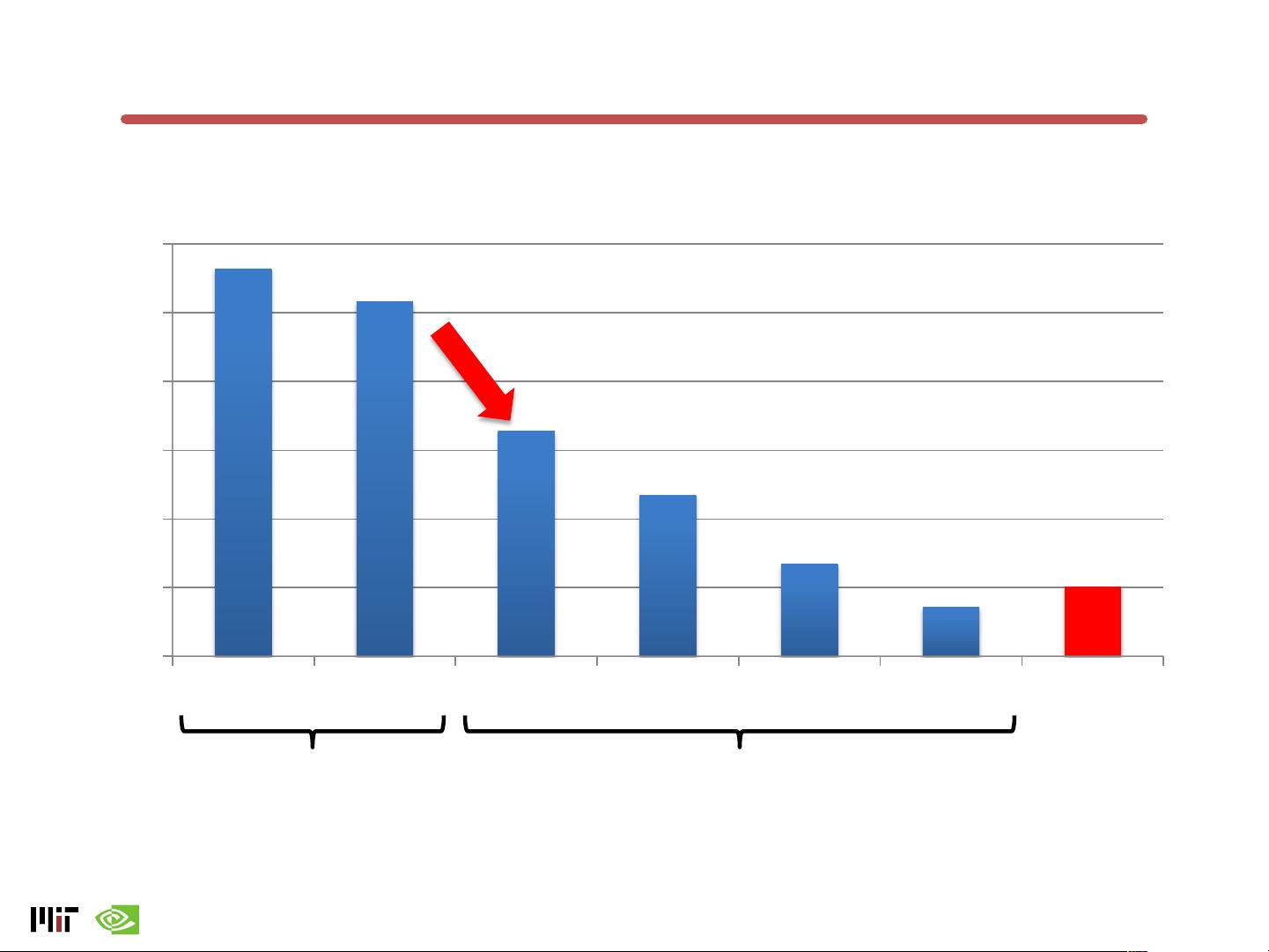

此外,网络优化是关键环节,涉及数据预处理、模型结构调整、剪枝、量化和编译技术,这些都可以提高DNN的效率和可扩展性。教程还将教授如何利用基准测试和比较指标来评估不同DNN实现的质量和效率。

最后,关于DNN训练,参与者将掌握如何进行有效的模型训练,包括学习率策略、批量大小的选择、正则化方法,以及如何利用分布式系统进行大规模训练。此外,还会讨论最新的实施趋势和技术机遇,比如迁移学习、自监督学习和云计算在深度学习训练中的角色。

通过本教程,参与者不仅能理解DNN设计的核心要素,还能掌握如何选择合适的平台和优化策略,以提升DNN的性能并把握未来发展趋势。这对于任何在AI领域从事开发、研究或应用的人来说,都是极其宝贵的知识储备。

2018-09-20 上传

2022-05-25 上传

2017-08-08 上传

2021-08-11 上传

2011-04-18 上传

2021-03-18 上传

2021-04-01 上传

netshell

- 粉丝: 11

- 资源: 185

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用