掌握MPI并行编程:高性能服务器训练实战

需积分: 3 107 浏览量

更新于2024-07-29

收藏 8.16MB PDF 举报

并行技术编程是现代高性能计算领域的重要组成部分,特别是在浪潮公司的内部培训课程中,刘羽博士主讲了MPI(Message Passing Interface)并行编程的入门知识。MPI是一种广泛应用于分布式内存并行计算环境的标准接口,它允许开发者在多台计算机上协同工作,通过消息传递来实现程序的并行执行。

课程的核心内容分为几个部分:

1. **并行计算概述**:介绍了并行计算的基本概念,强调了在日益增长的数据处理需求下,利用多处理器或分布式系统提升计算效率的重要性。

2. **MPI消息传递**:这部分详细讲解了MPI的主要功能,即如何在不同进程间进行数据交换和通信,包括发送、接收、同步等操作,这是并行程序设计的关键。

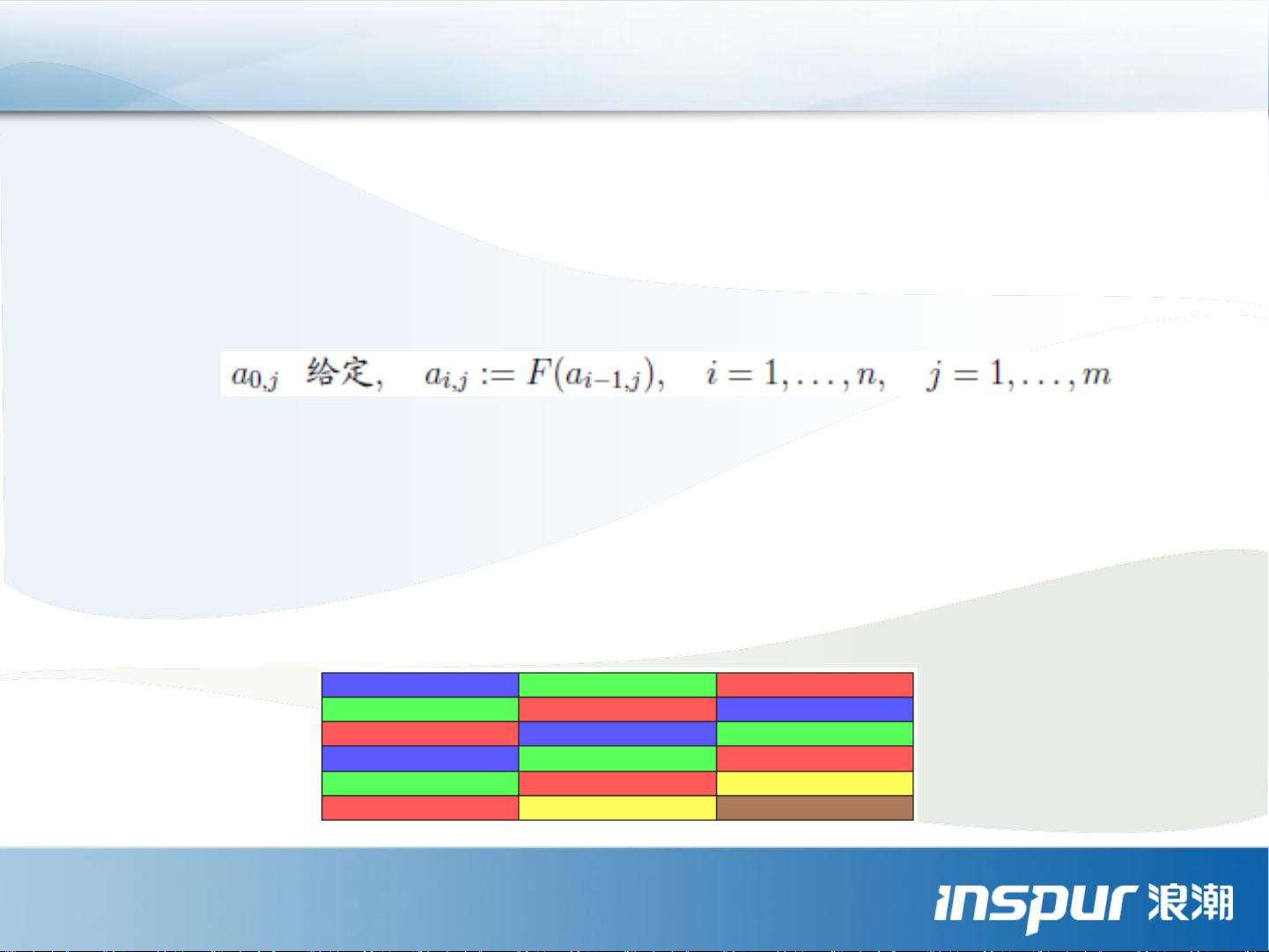

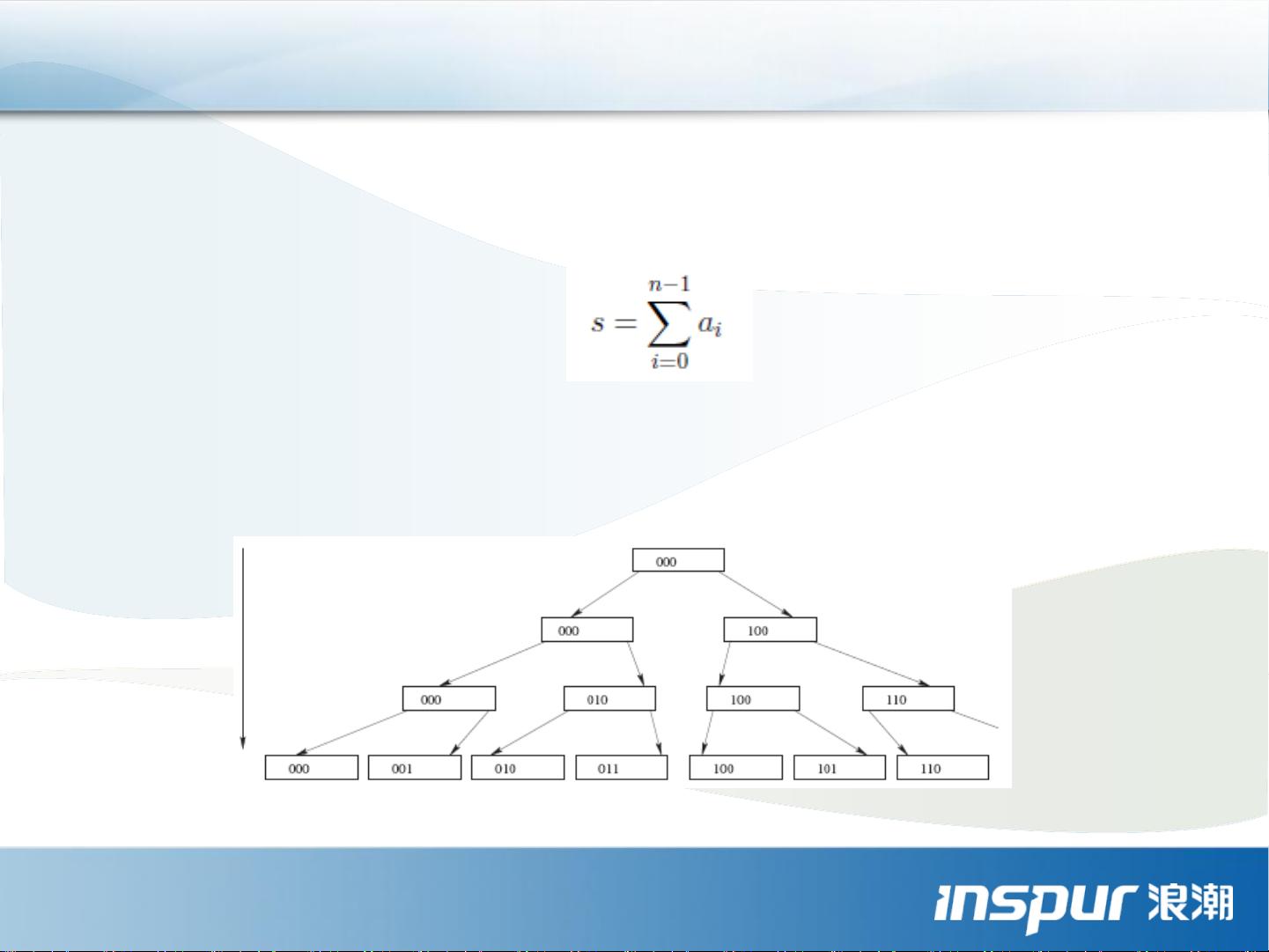

3. **MPI程序性能分析方法**:教授了如何通过工具和技术来评估并行程序的性能,如任务分配的负载均衡、通信开销的优化以及资源利用率等。

4. **并行计算机结构介绍**:区分了不同的并行计算机架构,如SISD、SIMD、MISD和MIMD,特别强调了MIMD架构,如对称多处理机(SMP)、分布式共享存储多处理机(DSM)、大规模并行处理机(MPP)和机群(Cluster),以及它们各自的优缺点。

5. **并行程序示例**:通过C、C++和Fortran语言的简单程序展示了如何利用MPI进行并行编程,如`PROGRAMHELLO`示例中的消息传递和输出。

6. **并行计算机结构模型**:深入探讨了SMP架构的特点,如单个内存总线连接多个CPU,以及其扩展性和局限性。同时,介绍了分布式内存架构,如NUMA模式,其中每个节点有自己的局部内存,但全局内存统一编址,这影响了数据访问和一致性策略。

在实际应用中,了解并行技术编程对于软件开发人员来说至关重要,特别是对于处理大规模数据集和复杂计算任务的场景。通过学习MPI和理解不同并行架构,开发者能够更好地设计和优化并行程序,提高整体计算性能和效率。此外,性能分析能力也是必不可少的,因为它可以帮助工程师发现并解决潜在的瓶颈,从而确保并行系统的最佳运行状态。

225 浏览量

2013-04-04 上传

2010-05-03 上传

2018-10-25 上传

2014-06-19 上传

2021-02-10 上传

2022-07-07 上传

2013-03-09 上传

espn1989

- 粉丝: 0

- 资源: 8

最新资源

- Control App for ESI MAYA22 USB:这是ESI MAYA22 USB音频接口的控制应用程序-开源

- phonebook_backend:电话簿的后端React APP

- CHIP8

- learn-mysql

- form-data-helper:替换 FormData 对象的 Javascript 插件。 用例

- 行业分类-设备装置-同步媒体处理.zip

- link-rest-dropwizard:一个简单的项目,演示将LinkRest与Dropwizard一起使用

- MediaPcInstaller:将grub2,Lakka和OpenElec安装到磁盘并设置为启动

- v-date-picker

- flutter-disenos-seccion8:Flutter课程的全新第8节

- 易语言聊天菜单源码-易语言

- Methods-of-collecting-and-processing-data-from-the-Internet

- 行业分类-设备装置-可高效稳定拔除钢结构体钢板桩的水利湖泊防洪堤修建机.zip

- welcome:xyao99的主页!

- request-api:简单的要求

- certifiacte-generator:在线证书生成器