SparkCore与MapReduce对比分析:快速入门与核心优势

需积分: 10 159 浏览量

更新于2024-07-16

收藏 3.94MB PDF 举报

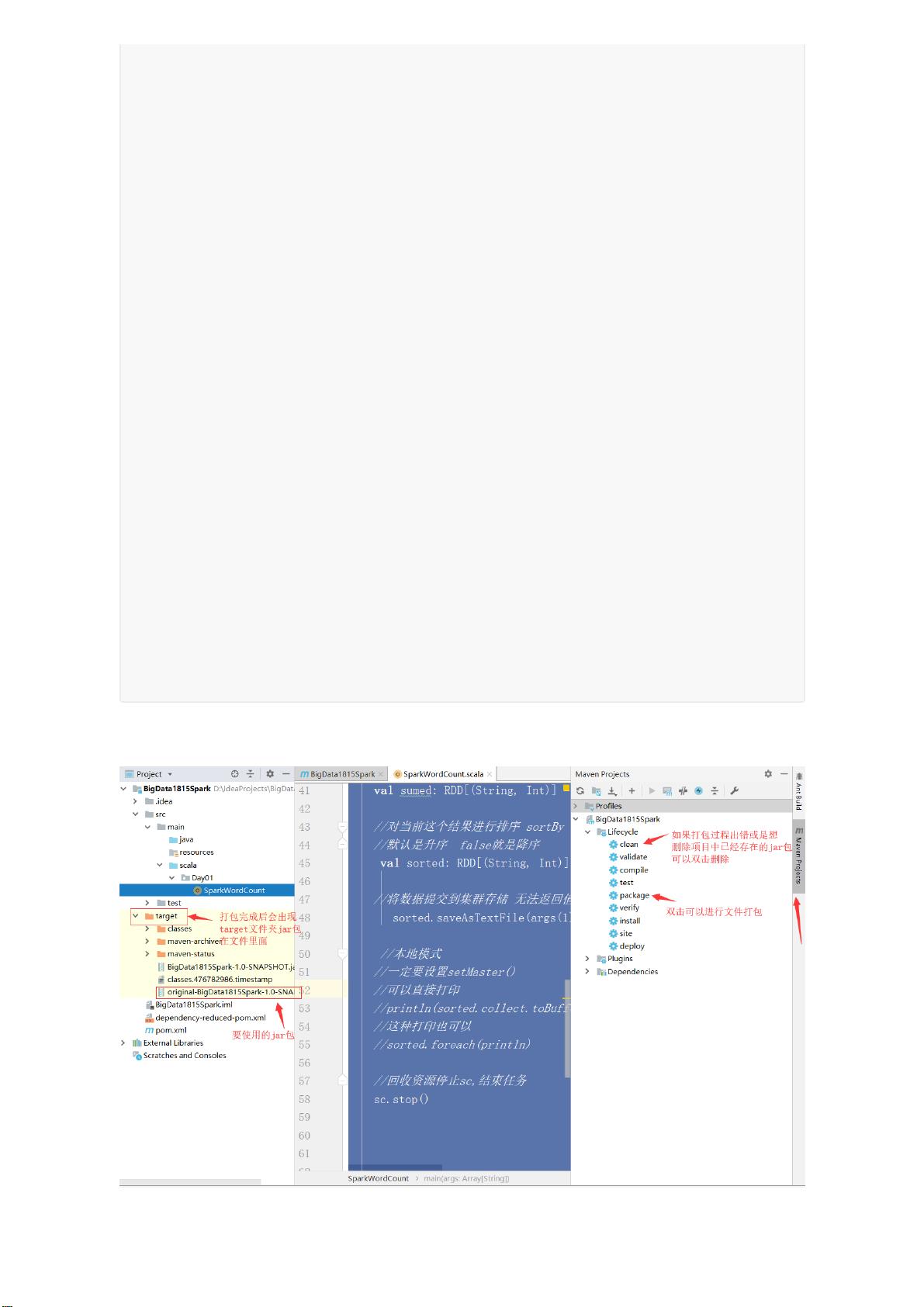

“SparkCore.pdf是关于SparkCore的快速入门指南,涵盖了Spark与Hadoop的对比,特别是强调了Spark在大数据处理中的优势,如内存计算、容错性和通用性。文件中还提到了Spark的生态系统,包括SparkSQL和SparkStreaming。”

在大数据处理领域,SparkCore是Apache Spark的核心组件,它提供了一种高效、易用的数据处理框架。Spark相较于传统的MapReduce模型,具有显著的性能优势。在Hadoop生态系统中,我们通常会使用HDFS作为分布式存储,MapReduce进行批量数据处理,而Hive、HBase、Flume和Sqoop则分别用于数据仓库、NoSQL存储、数据收集和数据导入导出。

Spark的框架体系允许它与Hadoop生态系统无缝集成。例如,可以使用Flume采集数据,接着用MapReduce进行预处理,然后将数据存储到HBase,实质上就是存储到了HDFS。HDFS具有高可靠性和可扩展性,但也有其局限性,如不适用于低延迟访问和处理大量小文件。

Spark与MapReduce的主要区别在于其内存计算机制。Spark将中间结果保留在内存中,从而减少了磁盘I/O,极大地提高了迭代计算的效率。此外,Spark引入了弹性分布式数据集(RDD),这是一种容错的内存数据结构,可以通过数据血缘关系进行恢复,比MapReduce的重计算更高效。Spark提供了丰富的API,包括转换(Transformation)和动作(Action),以及流处理(SparkStreaming)和图计算(GraphX),使其成为更为通用的大数据处理平台。

Spark的复杂性在于其内部机制,如RDD、血缘关系(Lineage)、有向无环图(DAG)和Stage划分,这些都要求用户在特定业务场景下进行优化以获得最佳性能。相比之下,MapReduce的模型相对简单,主要依赖map和reduce两个操作,对于流计算和其他高级功能的支持较为有限。

总结来说,SparkCore是Spark的核心,它通过内存计算和强大的容错机制,提供了比MapReduce更快的数据处理速度和更高的灵活性,同时其丰富的生态支持了多种类型的数据处理需求。了解和掌握SparkCore对于大数据处理的实践至关重要。

2022-08-08 上传

2018-10-08 上传

2018-12-26 上传

2019-10-17 上传

2020-06-08 上传

2020-04-25 上传

2019-04-16 上传

2022-12-14 上传

2022-10-30 上传

luoyunfan6

- 粉丝: 23

- 资源: 2

最新资源

- JHU荣誉单变量微积分课程教案介绍

- Naruto爱好者必备CLI测试应用

- Android应用显示Ignaz-Taschner-Gymnasium取消课程概览

- ASP学生信息档案管理系统毕业设计及完整源码

- Java商城源码解析:酒店管理系统快速开发指南

- 构建可解析文本框:.NET 3.5中实现文本解析与验证

- Java语言打造任天堂红白机模拟器—nes4j解析

- 基于Hadoop和Hive的网络流量分析工具介绍

- Unity实现帝国象棋:从游戏到复刻

- WordPress文档嵌入插件:无需浏览器插件即可上传和显示文档

- Android开源项目精选:优秀项目篇

- 黑色设计商务酷站模板 - 网站构建新选择

- Rollup插件去除JS文件横幅:横扫许可证头

- AngularDart中Hammock服务的使用与REST API集成

- 开源AVR编程器:高效、低成本的微控制器编程解决方案

- Anya Keller 图片组合的开发部署记录