预训练模型详解:NLP新纪元的关键

版权申诉

27 浏览量

更新于2024-08-04

收藏 969KB PDF 举报

"预训练模型关键问题梳理与面试必备高频FAQ.pdf"

预训练模型是当前自然语言处理(NLP)领域的热点,它们通过在大量无标注数据上进行学习,为各种NLP任务提供了强大的基础。预训练的主要目标是克服深度学习模型在训练时对大量标注数据的依赖,同时防止过拟合,提高模型的泛化能力和收敛速度。邱锡鹏老师的综述论文《Pre-trained Models for Natural Language Processing: A Survey》深入探讨了这一主题。

预训练的优势在于:

1. 通用语言表示:预训练模型能在大量无标注文本中学习到语言的一般规律,这些表示适用于多种下游任务,无需针对每个任务重新训练整个模型。

2. 提升初始化参数质量:预训练后的模型参数能更好地适应目标任务,加速模型的收敛过程。

3. 正则化效果:预训练有助于减少模型在小数据集上过拟合的风险,因为初始参数已经经过了大规模数据的洗礼。

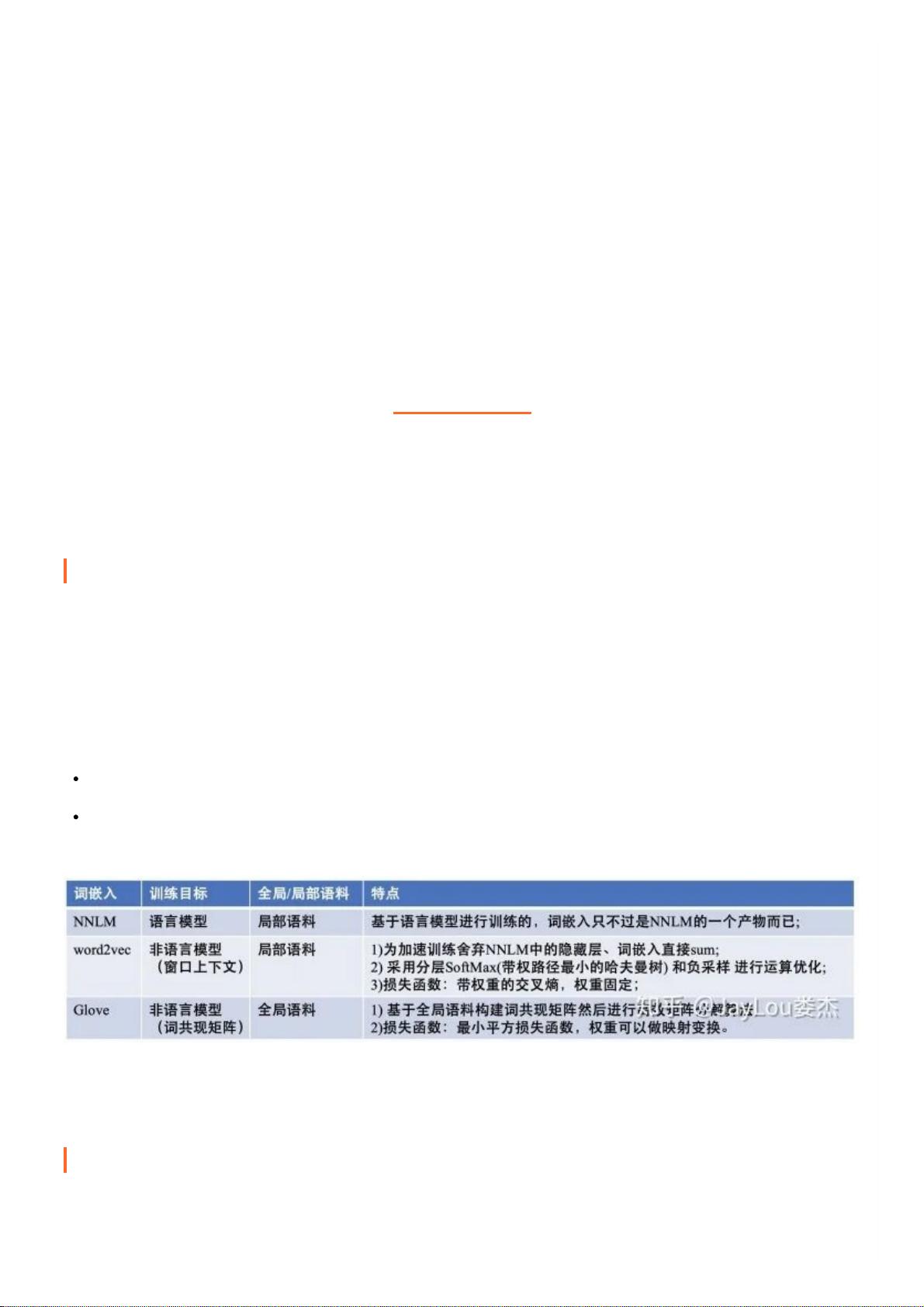

词嵌入和分布式表示是理解预训练模型的基础。词嵌入是将词汇映射到低维连续向量空间的技术,每个词由一个向量表示,这个向量包含了词的语义信息。分布式表示优于传统的独热编码,因为它能捕获词与词之间的语义关系,解决了独热编码的高维度和语义稀疏性问题。词嵌入使得相似的词在向量空间中靠近,不同语义的词相距较远,这为模型理解和处理自然语言提供了强大的工具。

常见的预训练模型如BERT、GPT、RoBERTa、ELECTRA等,它们采用了不同的预训练方法,如掩码语言模型(MLM)和自回归语言模型(ARLM)。BERT通过掩码部分单词并预测其原始内容来训练,而GPT则是基于上下文预测下一个单词。RoBERTa是BERT的优化版本,ELECTRA引入了生成器和判别器的对抗训练机制。

面试中,对于预训练模型的掌握程度是评估候选人能力的重要标准。理解模型的工作原理、预训练任务、微调策略以及如何应用于实际任务是必不可少的。例如,如何选择合适的预训练模型、如何进行下游任务的微调、如何评估模型性能以及如何解决过拟合和欠拟合等问题,这些都是面试中的常见问题。

在准备面试时,除了深入理解模型本身,还要关注最新的研究动态和技术趋势,例如Transformer架构的优化、预训练模型的可解释性、效率提升以及模型的公平性和隐私保护等方面。对于大厂的面试,还应具备良好的技术实践和项目经验,能够阐述自己如何将预训练模型应用于实际项目中,并解决遇到的实际问题。

为了进一步学习和复习,可以参考提供的GitHub链接,获取更多关于预训练模型的总结图和模型解读,持续跟踪相关研究,提升自己的专业技能。同时,参与社区讨论,了解业界观点,也是提升自己面试技巧的有效途径。

2023-10-18 上传

2021-03-23 上传

2020-09-22 上传

2020-09-11 上传

2019-10-30 上传

普通网友

- 粉丝: 1272

- 资源: 5619