深度学习系统优化:提升计算效率的新视角

11 浏览量

更新于2024-08-27

收藏 238KB PDF 举报

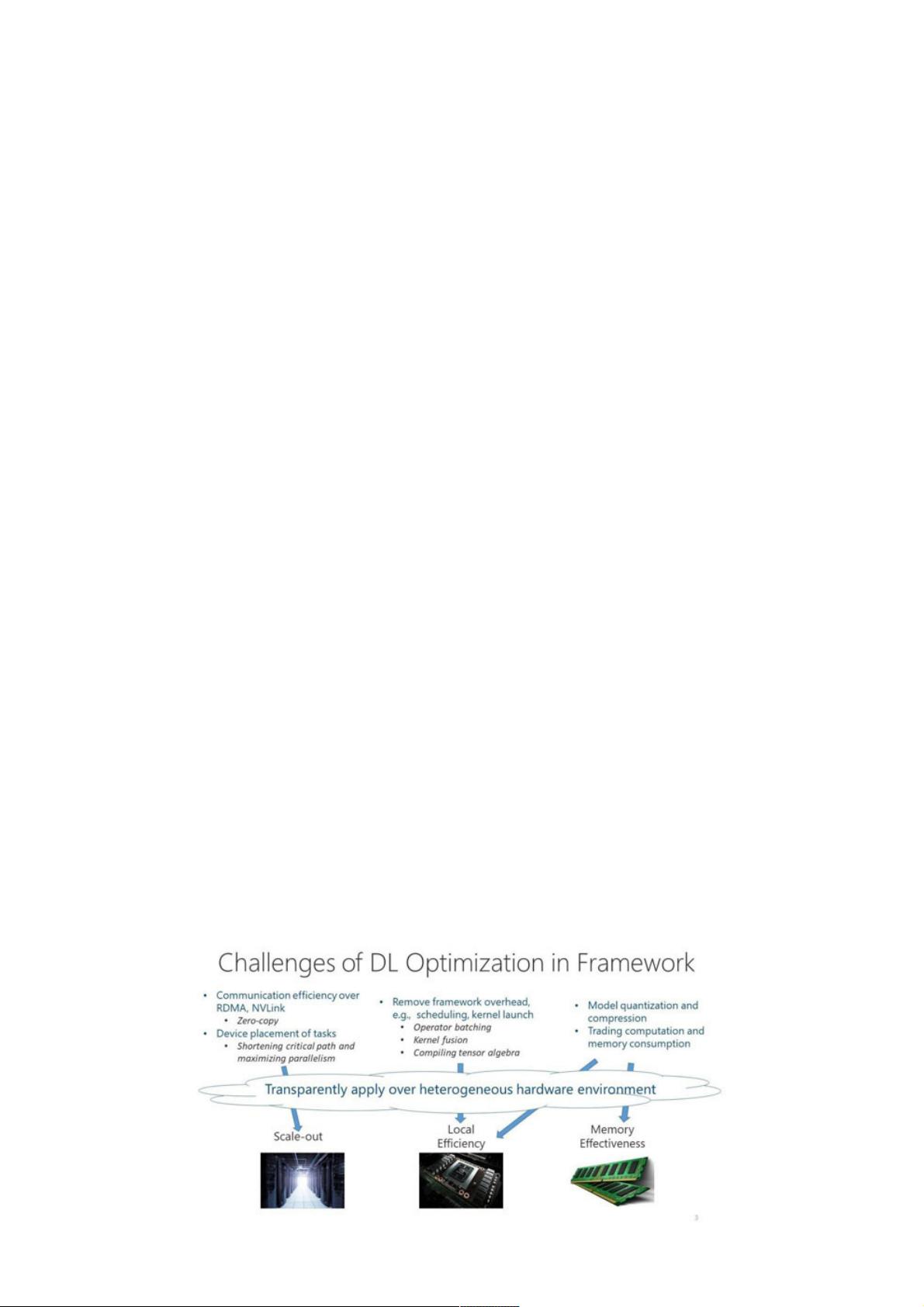

"本文主要探讨了深度学习计算的优化,特别是在系统层面的策略,由微软亚洲研究院资深研究员伍鸣提供观点。文章指出,随着深度学习在各个领域的广泛应用,如自动驾驶、安全、翻译和医疗,计算能力和通信效率的提升是关键。尽管深度学习已经在图像识别、语音识别、自然语言处理等领域取得显著成果,但对计算资源的依赖性依然很高。文章通过对比AlexNet和ResNet的计算需求,揭示了模型复杂度增加带来的计算量增长。同时,模型的快速迭代和线上推理的性能要求也是挑战。"

深度学习计算优化的重要性:

深度学习模型的训练通常需要大量计算资源,包括GPU、TPU等硬件加速器,以及大规模的存储和带宽。随着模型复杂度的提高,计算需求成倍增长,这不仅增加了运营成本,还限制了研究和开发的速度。因此,从系统层面进行优化至关重要,可以有效地提高计算资源的利用率,减少训练时间和成本。

系统层面的优化策略:

1. **硬件选择与调度**:选择适合深度学习任务的硬件,如GPU和TPU,根据任务需求进行合理分配。同时,利用硬件的并行计算能力,通过任务调度策略最大化硬件利用率。

2. **模型压缩**:通过模型剪枝、量化和蒸馏等技术,减小模型大小,降低计算和内存需求,同时尽可能保持模型性能。

3. **分布式训练**:将模型训练任务分解到多个设备上,通过数据并行、模型并行或混合并行的方式加速训练过程。

4. **优化算法与库**:使用高效的优化算法(如Adam、RMSprop等)和库(如TensorFlow、PyTorch等),并针对特定硬件进行优化。

5. **内存管理**:优化数据加载和存储策略,减少不必要的内存复制和缓存,提高内存利用率。

6. **计算图优化**:对深度学习框架的计算图进行分析和优化,减少冗余操作,提高计算效率。

7. **在线推理优化**:对于线上服务,采用模型预热、模型融合、动态调度等方法,确保服务响应速度和SLA要求。

8. **混合精度训练**:使用半精度(FP16)或更低精度的数据类型进行计算,减少内存使用和计算时间,同时需要保证模型精度不受严重影响。

9. **硬件加速器的协同工作**:结合CPU、GPU和其他加速器,进行协同计算,平衡负载,提升整体性能。

10. **持续的系统监控与调整**:定期评估系统性能,根据训练情况调整硬件配置和参数,实现动态优化。

深度学习的未来趋势:

随着硬件技术的进步和新的优化方法的出现,深度学习计算的效率将持续提升。未来的重点可能转向更多元化的硬件支持、自动化的优化工具以及更智能的资源调度策略,以应对日益复杂的模型和更高的性能需求。同时,随着边缘计算的发展,本地设备上的计算优化也将成为一个重要方向。

2022-07-12 上传

2022-07-12 上传

2023-01-07 上传

2018-08-24 上传

点击了解资源详情

2024-03-19 上传

2020-08-02 上传

2023-05-27 上传

2021-01-20 上传

weixin_38693524

- 粉丝: 3

- 资源: 954

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能