深度学习:卷积神经网络结构与经典模型详解

需积分: 0 108 浏览量

更新于2024-06-30

1

收藏 18MB PDF 举报

第7章卷积神经网络I深入探讨了卷积神经网络(Convolutional Neural Networks, CNN)在深度学习中的核心地位,以及它如何解决传统神经网络在处理图像数据时遇到的挑战。章节首先引入了深层神经网络面临的内存和计算效率问题,特别指出全连接层在处理高分辨率图像时参数过多,可能导致内存需求巨大,这在当时的硬件条件下是难以承受的。

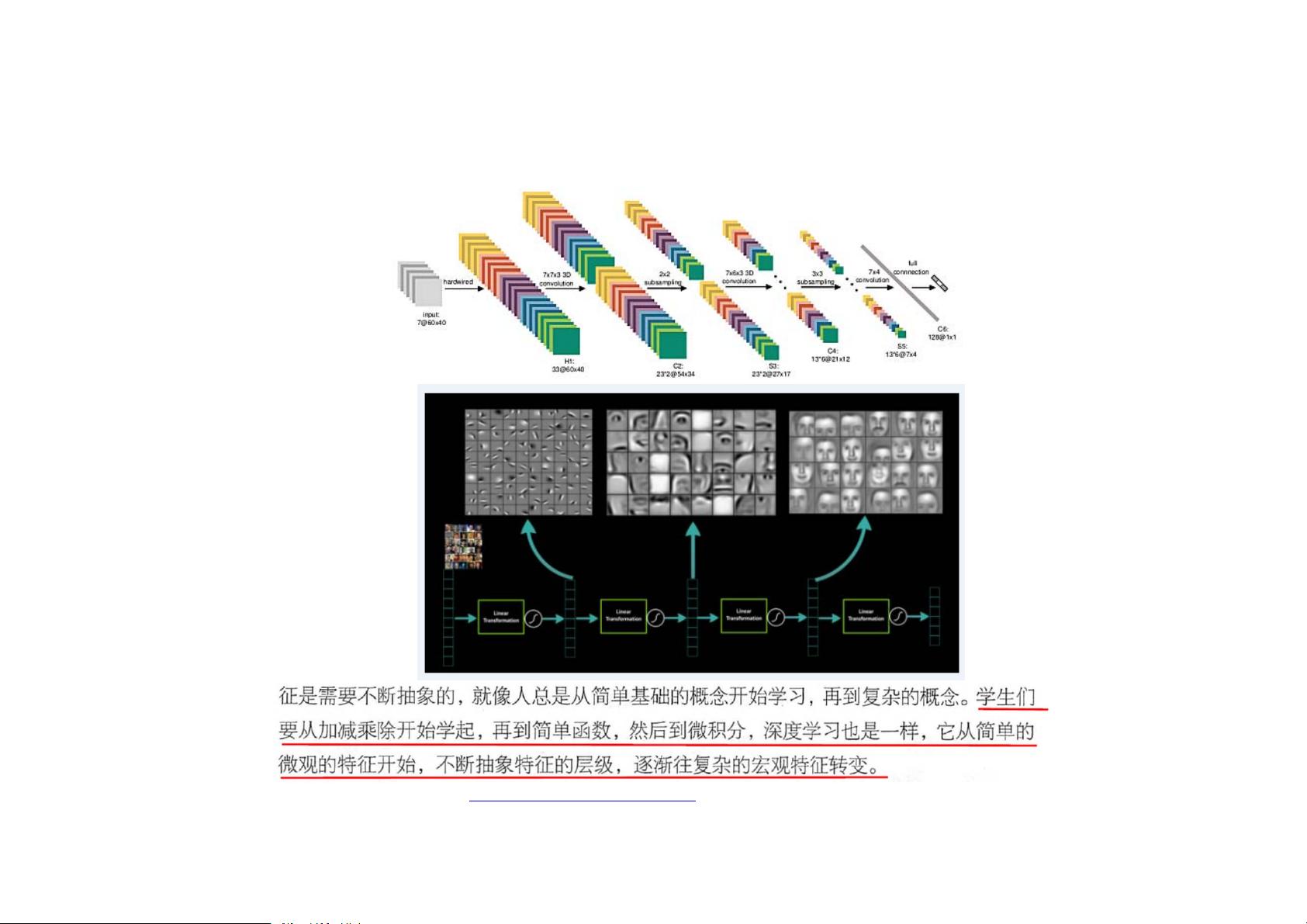

卷积神经网络的概念起源于对一维信号处理(如语音识别)成功网络结构的迁移,但它针对图像数据的特点进行了优化。CNN通过利用图像的局部特征,避免了全连接层中不必要的参数数量,极大地降低了模型复杂度。其基本结构包括输入层、卷积层、激活层、池化层和全连接层。这些组件协同工作,使得模型能够识别和提取图像中的模式,即使这些模式并非均匀分布在整张图片上。

具体来说,卷积层通过固定大小的滤波器(或称为卷积核)在输入图像上滑动并进行内积运算,提取局部特征,这样每个卷积层的参数数量相对于全连接层大大减少。激活函数,如ReLU,被用来引入非线性,增强模型表达能力。池化层则用于减小特征图的尺寸,进一步减少计算量,同时保留关键信息。全连接层用于将前面层的特征映射到最终的分类结果。

经典CNN结构部分介绍了几个里程碑式的模型:AlexNet,它首次在ImageNet竞赛中展示了CNN在大规模图像分类上的潜力;VGGNet,以其深度和简洁的架构著称;GoogLeNet(Inception)和ResNet,分别引入了多尺度特征提取和残差连接,提高了模型性能和训练速度;DenseNet则通过密集连接的方式加强了信息流动,减少了冗余计算。

附录部分详细阐述了CNN的特点,比如它们在参数共享和空间不变性方面的优势,以及不同激活函数的优缺点。此外,还提及了其他相关研究资料,如斯坦福大学的cs231n_2018_lecture09,供读者进一步探索。

第7章卷积神经网络I不仅介绍了这一领域的基础概念,还深入剖析了如何通过卷积神经网络解决图像处理任务中的内存瓶颈问题,以及如何通过精心设计的网络结构来实现高效、准确的图像特征提取和分类。

2022-08-04 上传

2022-08-03 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-12-27 上传

2024-12-27 上传