GraphSAGE:大规模图学习的归纳方法

需积分: 0 146 浏览量

更新于2024-08-05

1

收藏 942KB PDF 举报

"本文主要分析了GraphSAGE算法的基本原理,它是针对GCN在大规模图学习中的局限性提出的一种inductive learning解决方案。GraphSAGE不直接学习所有节点的embedding,而是学习一种聚合邻居节点特征的方法,能快速适应新节点的表示。文章中提到,GCN在transductive learning中的问题在于节点表示相互依赖且参数与邻接矩阵紧密关联,这限制了其在新节点或子图上的泛化能力。"

在图神经网络领域,GraphSAGE是一个重要的突破,由Hamilton等人在2017年提出。它解决了Graph Convolutional Networks (GCN) 在大规模图数据上难以进行inductive learning的问题。GCN虽然在节点分类、链接预测等任务中表现出色,但由于其transductive nature,无法泛化到训练集中未出现的新节点。

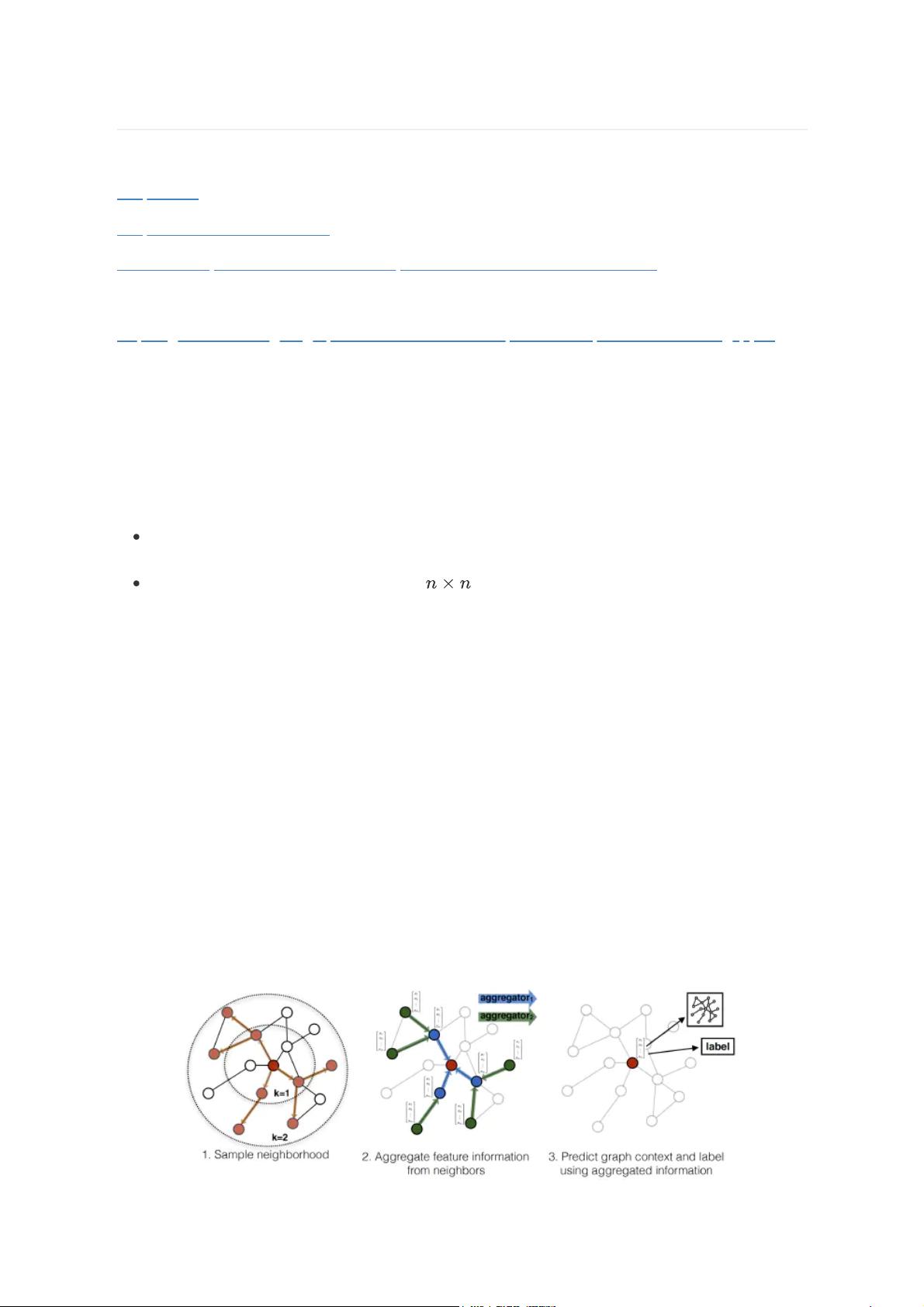

GraphSAGE的核心思想是采样和聚合策略。它并不尝试为图中的每一个节点单独训练一个embedding向量,而是学习一组aggregator functions,这些函数负责从节点的局部邻居中聚合特征信息。这个过程可以按层次进行,每个层次代表不同的“跳”或“搜索深度”,使得节点能够获取更远邻居的信息。采样机制则用于控制计算复杂性,因为直接考虑所有邻居对于大规模图是不可行的。

在训练过程中,GraphSAGE首先对每个节点的邻居进行采样,然后应用聚合函数将这些邻居的特征信息整合到当前节点的特征表示中。这一过程在多层中重复,使得节点的表示不仅包含自身的特征,还包含了多级邻居的信息。在测试阶段,对于未在训练集中出现的新节点,可以直接利用学习到的聚合函数生成其embedding,无需重新训练模型。

GraphSAGE提供了不同类型的聚合函数,如Mean Aggregator,LSTM Aggregator和Pooling Aggregator,它们分别对应于平均池化、循环神经网络处理邻居特征和最大池化的聚合方式。这些不同类型的聚合器为模型提供了灵活性,可以根据任务需求选择合适的方法。

总结来说,GraphSAGE通过采样和聚合策略克服了GCN的局限性,实现了对大规模图的inductive learning,能够在不重新训练的情况下对新节点进行有效的表示学习。这一方法在图数据的实时更新和扩展场景中具有显著优势,为图神经网络的应用开辟了新的可能性。

647 浏览量

112 浏览量

212 浏览量

874 浏览量

2013-08-28 上传

112 浏览量

仙夜子

- 粉丝: 45

最新资源

- 易酷免费影视系统:开源网站代码与简易后台管理

- Coursera美国人口普查数据集及使用指南解析

- 德加拉6800卡监控:性能评测与使用指南

- 深度解析OFDM关键技术及其在通信中的应用

- 适用于Windows7 64位和CAD2008的truetable工具

- WM9714声卡与DW9000网卡数据手册解析

- Sqoop 1.99.3版本Hadoop 2.0.0环境配置指南

- 《Super Spicy Gun Game》游戏开发资料库:Unity 2019.4.18f1

- 精易会员浏览器:小尺寸多功能抓包工具

- MySQL安装与故障排除及代码编写全攻略

- C#与SQL2000实现的银行储蓄管理系统开发教程

- 解决Windows下Pthread.dll缺失问题的方法

- I386文件深度解析与oki5530驱动应用

- PCB涂覆OSP工艺应用技术资源下载

- 三菱PLC自动调试台程序实例解析

- 解决OpenCV 3.1编译难题:配置必要的库文件