实战教程:人脸合成与表情建模深度解析

版权申诉

119 浏览量

更新于2024-06-26

收藏 3MB PDF 举报

本章节深入探讨了机器智能项目开发实战中的一个重要主题——人脸合成,特别是在编程案例解析中提供了三个具体实例:基于视频的人脸表情合成、三维虚拟人脸模型以及虚拟人脸部年龄仿真。这些实例展示了如何结合现代技术手段实现人脸合成的复杂过程。

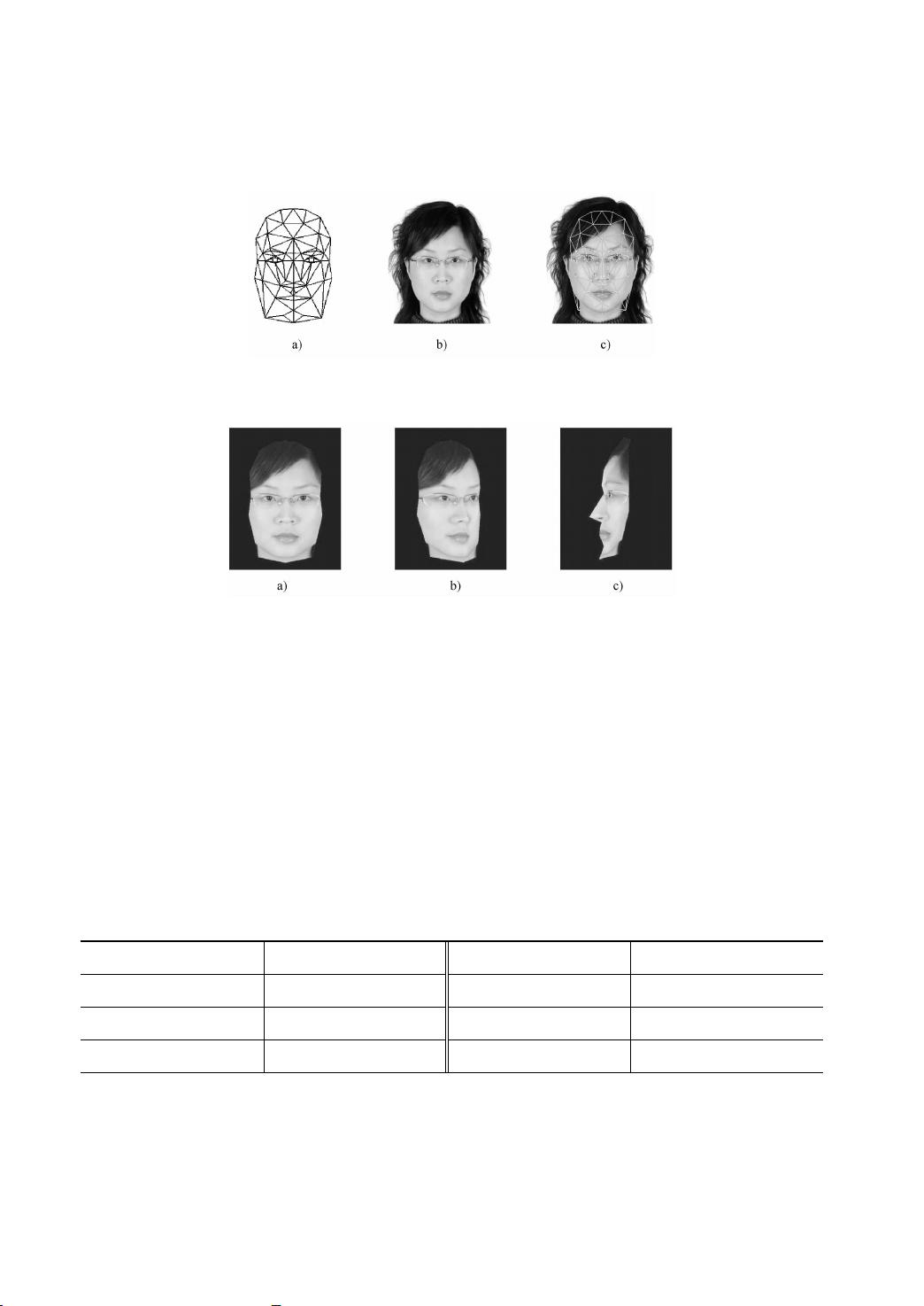

首先,以Candide模型为基础,该模型由Mikael Rydfalk于1987年创建,它是一个非特定人脸的网格模型,包含113个关键点和168个三角面片。Candide模型的关键在于其控制参数,包括静态人脸定义参数(FDP)和动态人脸动画参数(FAP)。静态参数用于表示不同人脸间的差异,而动态参数则负责驱动脸部表情的变化。在VisualC++环境下,借助OpenGL技术,通过线积分卷积法处理纹理向量场映射,控制AU(动作单位)对应的FAP,实现表情的实时合成,从而创建出具有皮肤纹理和可变表情的个性化人脸模型。

在这个基础上,作者将人脸表情建模模块与表情识别模块集成,构建了一个实时表情信息获取与重构平台。这个平台不仅能够精确识别三种基本表情(高兴、平静、惊讶),还能实时重现这些表情,使得基于视频的人脸表情建模成为可能。这一应用有助于在网络视频传输中有效压缩图像数据,提高带宽利用率。

进一步,章节引入了3DSMAX模型,结合特征点与网格模型的概念,创造出了具有高度真实感的三维虚拟人脸。通过调整脸部特征和模拟表情变化,该模型在计算机图形学领域中展示了人脸生成与表情合成的深度结合。

11.1.1的Candide模型在人脸合成中扮演了核心角色,它的设计原则和灵活性使得它成为表情合成领域的经典之作。通过Candide模型,我们可以看到不同学科如图像处理、计算机视觉和计算机图形学的交叉融合,这些技术共同推动了人脸合成技术的发展。

总结来说,本章节详细讲解了如何运用Candide模型和多学科知识来实现人脸合成,涉及从基础模型构建到表情识别、再到三维虚拟人脸的真实感增强,以及如何在实际应用中优化视频传输效率。这不仅展示了机器智能和人工智能在人脸合成方面的进展,也为物联网中的人脸交互和实时通信提供了技术支持。

538 浏览量

106 浏览量

207 浏览量

728 浏览量

641 浏览量

244 浏览量

489 浏览量

326 浏览量

好知识传播者

- 粉丝: 1684

- 资源: 4133

最新资源

- 模糊pid_大疆_模糊pid_电机_steering_stm32f105模糊pid_

- browserify-string-to-js:使用require(...)读取CSS文件,HTML文件等

- Kotlin-PWA-starter-kit:使用100%Kotlin创建渐进式Web应用程序

- 常用jar包.zip

- firt_react_project

- mern-task-manager

- module-extract-version:(Perl)这是模块的作用

- Rabbit MQ整体搭建以及demo.rar

- NI采集卡6009数据记录软件_ni6009_波形监控_

- Windows系统网络映射工具

- walkofclaim:手机游戏的开源版本

- aleusai.github.io

- 统计资料

- CanFestival-transplanted2stm32-master.zip

- webpack-1-demo

- alkyl:基于ElixirCowboy的Etherpad后端