数据降维利器:PCA原理、应用与局限

需积分: 45 91 浏览量

更新于2024-09-08

收藏 1.05MB PDF 举报

理解主成分分析法

主成分分析法(PCA)是统计学和机器学习领域中的一种重要技术,主要用于数据分析和预处理,特别适用于处理具有高度线性相关性的多变量数据。其核心思想是通过对原始数据进行正交变换,将其转换到一个新的坐标系,使得新坐标系下的维度之间相互独立,从而实现数据降维并保持信息的可解释性。

在实际应用中,PCA的首要目标是消除数据集中的冗余信息,通过找出各维度之间的最大线性相关性,将数据投影到这些主要的方向上。这样做的好处在于:

1. **减少冗余**:当数据存在强线性相关性时,PCA可以帮助我们找到那些提供相似信息但并不独立的维度,通过剔除方差较小的维度,降低数据维度,简化模型。

2. **简化模型**:对于高维数据,PCA能有效降低计算复杂性,加快模型训练和预测速度,同时保持对数据主要特征的捕捉。

3. **提高可视化**:处理后的数据更容易理解和展示,使得样本之间的关系更为直观。

4. **噪声过滤**:通过保留方差较大的主成分,PCA有助于剔除噪声,提升数据质量。

**PCA的计算流程**:

- **数据准备**:原始数据被视作一个m维的行向量矩阵,每个样本对应一行。

- **协方差矩阵计算**:首先计算原始数据的协方差矩阵,反映各维度间的关联程度。

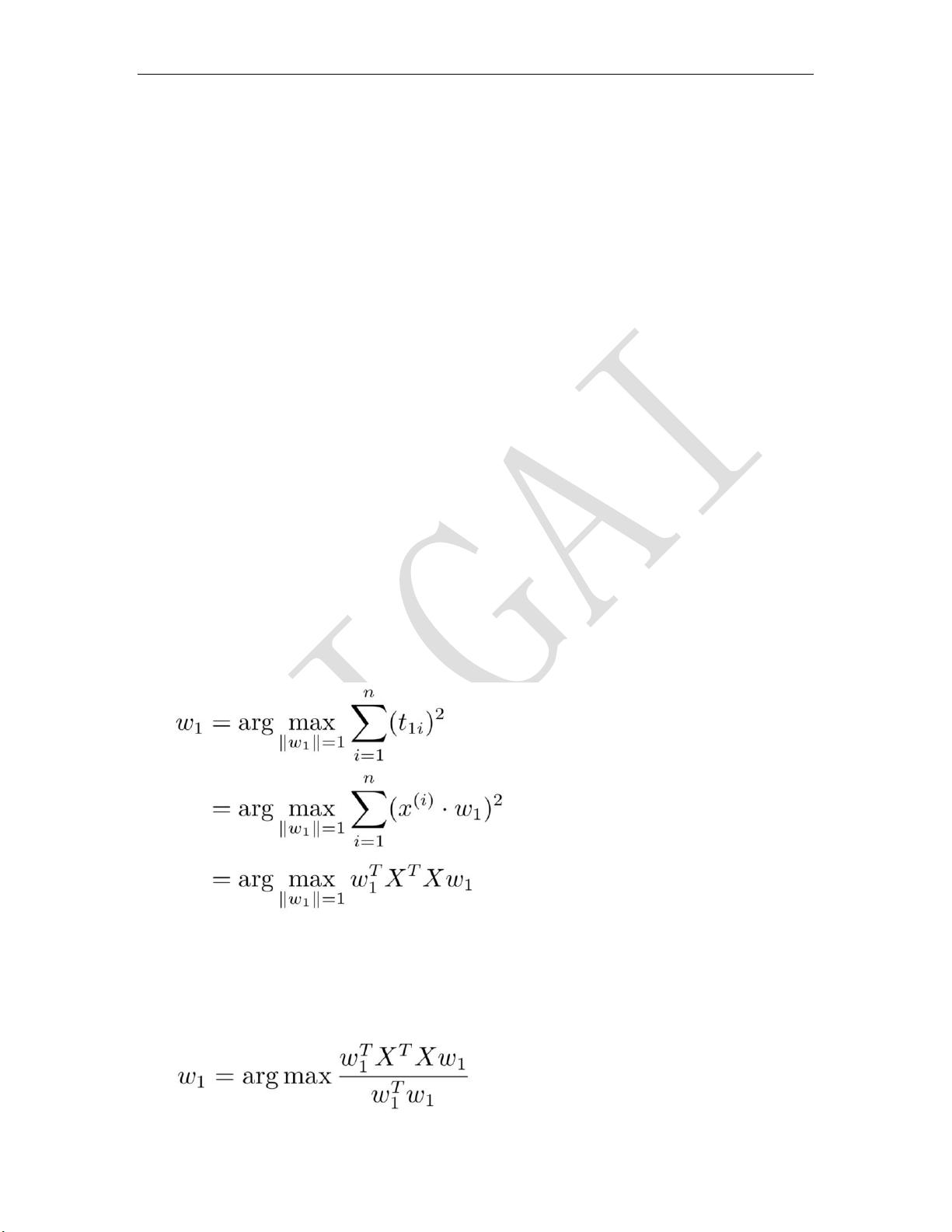

- **特征值和特征向量**:求解协方差矩阵的特征值和特征向量,其中最大的特征值对应于第一个主成分,依次类推。

- **正交旋转**:将原始数据投影到这些特征向量上,即进行正交变换,生成新的坐标系。

- **选择主成分**:根据方差大小,选择前k个主成分进行保留,其余的作为噪声或无关维度舍弃。

然而,PCA也有其局限性:

- **非监督方法**:PCA是无监督学习,不能直接用于分类任务,因为它基于变量之间的统计特性,而忽视了潜在的类别信息。

- **信息丢失**:在降维过程中,可能会丢失部分非线性关系或局部结构,这在某些情况下可能影响模型的准确性。

- **对异常值敏感**:如果数据集中存在极端值或异常点,PCA可能会被这些点主导,影响结果。

主成分分析法是一种强大的数据处理工具,适用于降维、数据可视化和预处理,但需要根据具体应用场景权衡其优点和局限性。在实际应用中,结合其他方法如聚类、回归或深度学习,可以更好地发挥PCA的作用。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-07-15 上传

2021-10-01 上传

2011-03-03 上传

2010-08-03 上传

2009-06-27 上传

2022-11-25 上传

SIGAI_csdn

- 粉丝: 2352

- 资源: 45

最新资源

- Raspberry Pi OpenCL驱动程序安装与QEMU仿真指南

- Apache RocketMQ Go客户端:全面支持与消息处理功能

- WStage平台:无线传感器网络阶段数据交互技术

- 基于Java SpringBoot和微信小程序的ssm智能仓储系统开发

- CorrectMe项目:自动更正与建议API的开发与应用

- IdeaBiz请求处理程序JAVA:自动化API调用与令牌管理

- 墨西哥面包店研讨会:介绍关键业绩指标(KPI)与评估标准

- 2014年Android音乐播放器源码学习分享

- CleverRecyclerView扩展库:滑动效果与特性增强

- 利用Python和SURF特征识别斑点猫图像

- Wurpr开源PHP MySQL包装器:安全易用且高效

- Scratch少儿编程:Kanon妹系闹钟音效素材包

- 食品分享社交应用的开发教程与功能介绍

- Cookies by lfj.io: 浏览数据智能管理与同步工具

- 掌握SSH框架与SpringMVC Hibernate集成教程

- C语言实现FFT算法及互相关性能优化指南