"奇异值分解SVD原理与应用全面解析,助你高效运用SVD算法"

需积分: 0 54 浏览量

更新于2024-01-03

收藏 3.85MB PPTX 举报

奇异值分解(Singular Value Decomposition,以下简称SVD)是一种在机器学习领域广泛应用的算法。它不仅可以用于降维算法中的特征分解,还可以用于推荐系统和自然语言处理等领域。实际上,SVD是许多机器学习算法的基石。

SVD定义了一个矩阵A的分解形式,这个矩阵可以是任意大小的。SVD的定义包括三个关键部分:矩阵A的奇异值、U矩阵的左奇异向量和V矩阵的右奇异向量。U矩阵和V矩阵都是正交矩阵,也就是说它们的转置矩阵与自身的乘积结果是单位矩阵。

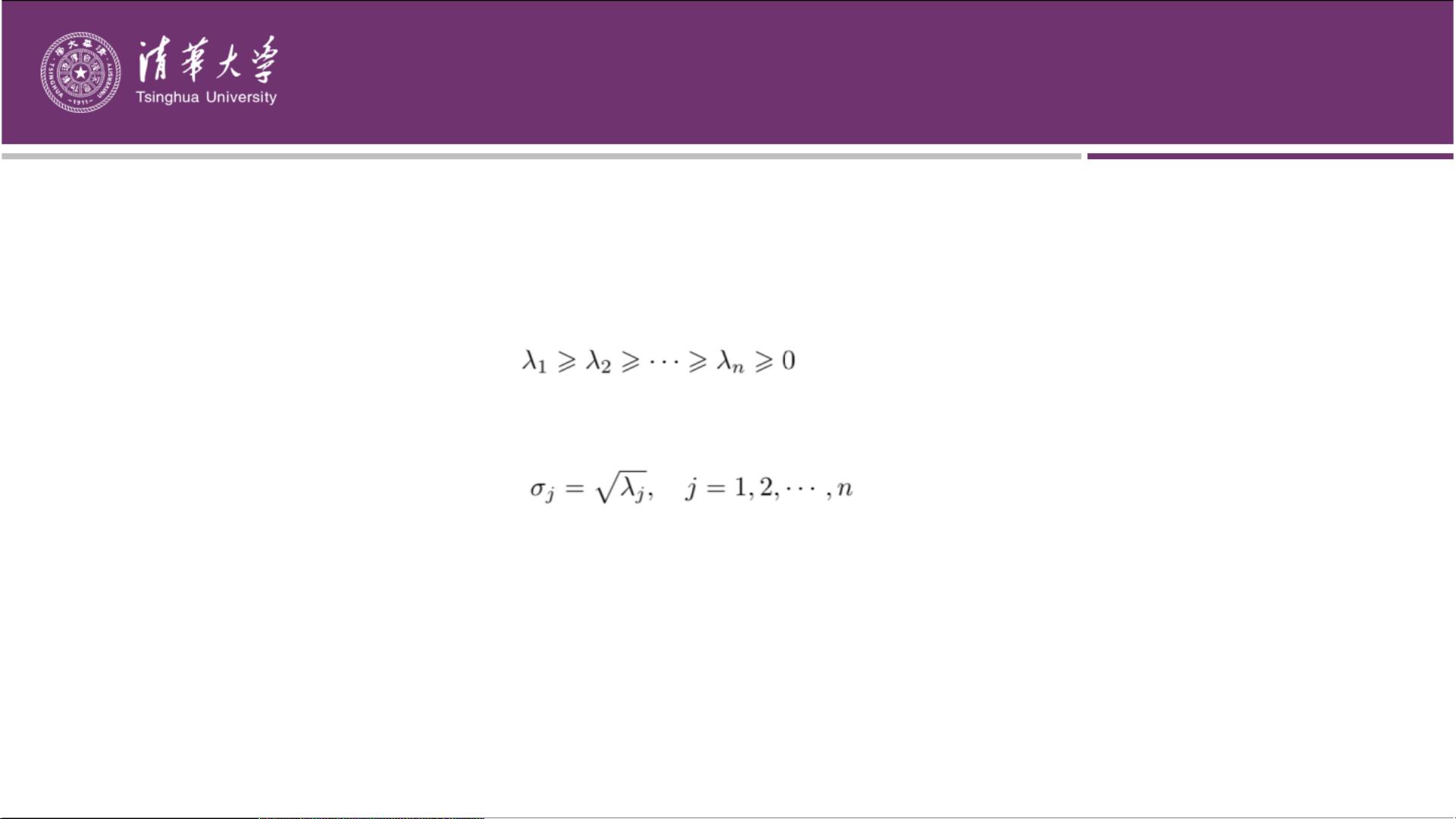

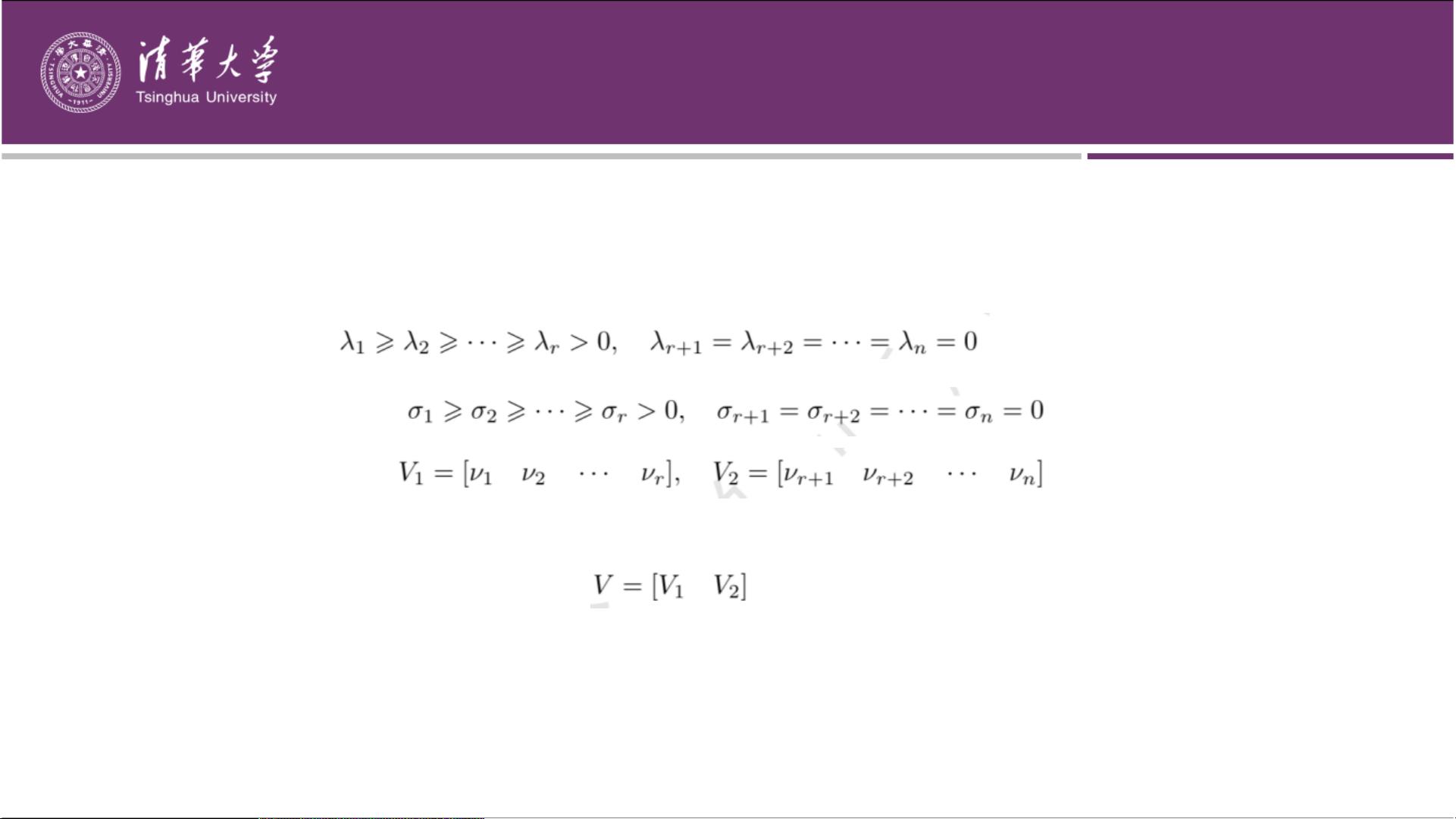

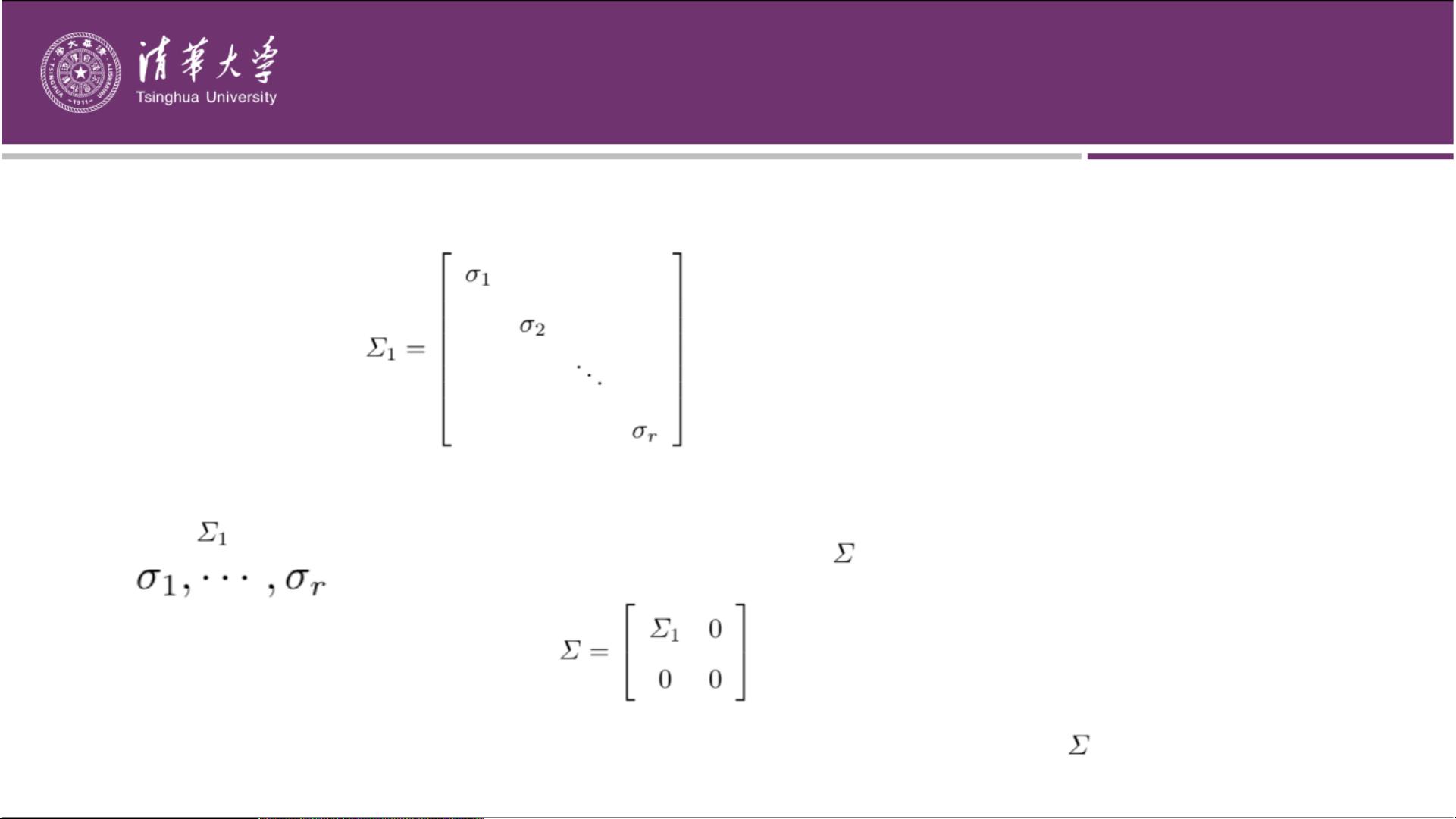

奇异值是矩阵A的重要特征,它们体现了矩阵A的特定属性。矩阵A的奇异值分解可以看作是方阵的对角化的推广。具体来说,给定一个m行n列的矩阵A,其奇异值分解可以表示为三个矩阵的乘积:A = UΣV^T。其中Σ是对角矩阵,对角线上的元素为矩阵A的奇异值,按降序排列。

奇异值分解具有重要的数学性质。例如,矩阵A的秩等于其非零奇异值的个数。此外,奇异值分解还可以用于求解线性方程组、矩阵的伪逆以及矩阵的正规化等问题。

SVD的主要应用领域之一是降维算法。通过选择较小数量的奇异值,可以将高维数据降低到低维空间,同时保留原始数据的主要特征。这对于处理大规模数据和提高计算效率非常有用。

除了降维算法,SVD还被广泛应用于推荐系统。推荐系统是通过分析用户历史数据和物品特征来推荐用户可能感兴趣的物品。使用SVD可以将用户和物品之间的关系表示为低维的矩阵,从而提高推荐的准确性和效率。

在自然语言处理领域,SVD也有着重要的应用。例如,可以使用SVD将大量的文本数据表示为低维的向量空间模型,从而实现文本的语义分析和相似度计算。此外,SVD还可以用于解决词嵌入、语言模型和语音识别等问题。

总之,奇异值分解(SVD)是一种在机器学习领域广泛应用的算法。它可以用于降维算法、推荐系统和自然语言处理等领域。SVD的原理是对矩阵进行分解,得到矩阵的奇异值、左奇异向量和右奇异向量。通过选择较小数量的奇异值,可以实现数据降维和特征提取。SVD具有数学性质和广泛的实际应用,是机器学习算法的基石之一。

点击了解资源详情

点击了解资源详情

2024-11-21 上传

学习,学习,再学习

- 粉丝: 0

- 资源: 5

最新资源

- 全国江河水系图层shp文件包下载

- 点云二值化测试数据集的详细解读

- JDiskCat:跨平台开源磁盘目录工具

- 加密FS模块:实现动态文件加密的Node.js包

- 宠物小精灵记忆配对游戏:强化你的命名记忆

- React入门教程:创建React应用与脚本使用指南

- Linux和Unix文件标记解决方案:贝岭的matlab代码

- Unity射击游戏UI套件:支持C#与多种屏幕布局

- MapboxGL Draw自定义模式:高效切割多边形方法

- C语言课程设计:计算机程序编辑语言的应用与优势

- 吴恩达课程手写实现Python优化器和网络模型

- PFT_2019项目:ft_printf测试器的新版测试规范

- MySQL数据库备份Shell脚本使用指南

- Ohbug扩展实现屏幕录像功能

- Ember CLI 插件:ember-cli-i18n-lazy-lookup 实现高效国际化

- Wireshark网络调试工具:中文支持的网口发包与分析