林轩田机器学习技法:连接Soft-Margin SVM与Kernel Logistic Regression

需积分: 0 141 浏览量

更新于2024-08-05

收藏 1.37MB PDF 举报

在林轩田的《机器学习技法》课程笔记中,第五节着重探讨了Kernel Logistic Regression与Soft-Margin Support Vector Machines (SVM)的关系。在第一节课中,已经提及了Hard-Margin SVM与正则化模型之间的关联,正则化的目的是最小化目标函数,同时保持分类决策的简单性。

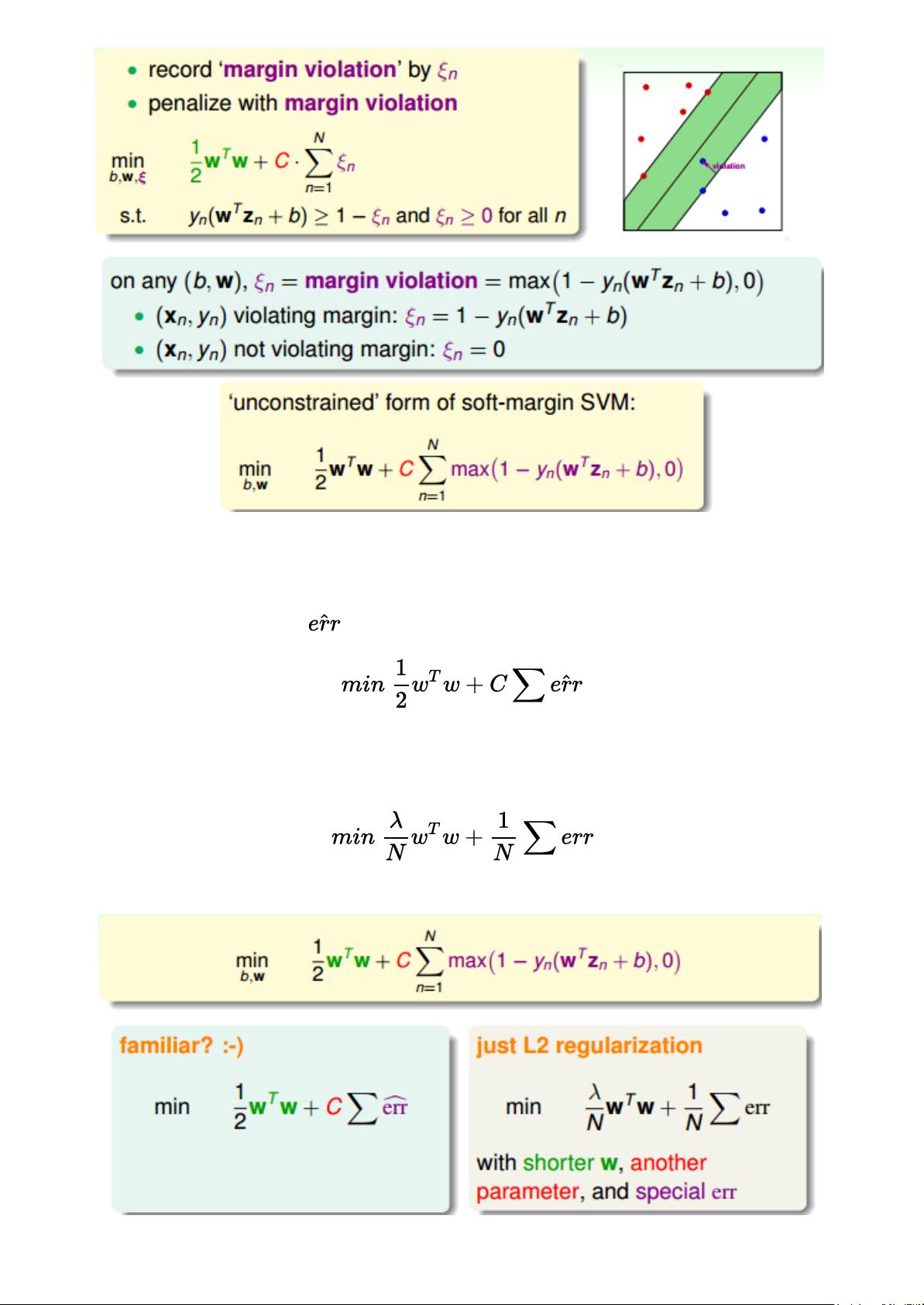

Soft-Margin SVM是Hard-Margin SVM的扩展,它允许存在少量分类错误,通过引入惩罚因子C来平衡分类精度和决策边界的宽度。在原始的Hard-Margin SVM中,决策边界是硬性的,而在Soft-Margin SVM中,通过增加容错能力,使得模型能够适应噪声数据和复杂的数据分布。Soft-Margin SVM的普拉姆形式和对偶形式都引入了C参数,对偶形式因其灵活性和易于参数调整,在实际应用中更为常见,如在Libsvm和Liblinear这两个广泛使用的工具包中。

在本节课程中,林轩田教授将Soft-Margin SVM与逻辑回归模型相结合,利用核技巧(Kernel Trick)来解决更多样化的机器学习问题。核技巧允许我们将数据映射到高维空间,从而处理非线性和非特征可分的问题,即使在原始特征空间中线性不可分的情况下,也能在新的特征空间中找到有效的分类边界。

回顾Soft-Margin SVM的核心概念,它是通过计算margin violation(违反间隔的大小)来衡量分类错误的程度。当数据点不满足分类条件时,margin violation为正值,对应的误分类误差可以表示为某个函数。而对于那些满足分类条件的点(not violating margin),它们位于决策边界之外,此时margin为零。通过将原问题转化为对偶形式,利用Quadratic Programming (QP)求解方法,能找到最优的模型参数,从而达到最大化分类边界,同时控制错误率的目的。

林轩田的课程深入浅出地讲解了如何通过Kernel Logistic Regression进一步扩展Soft-Margin SVM的概念,以及如何利用核技巧在实际问题中提升模型性能。这对于理解和支持向量机和逻辑回归在复杂数据处理中的应用具有重要意义。

2022-08-03 上传

2017-12-21 上传

2022-08-03 上传

2018-05-25 上传

2024-10-19 上传

2024-10-19 上传

2024-02-21 上传

点击了解资源详情

点击了解资源详情

艾斯·歪

- 粉丝: 42

- 资源: 342

最新资源

- 俄罗斯RTSD数据集实现交通标志实时检测

- 易语言开发的文件批量改名工具使用Ex_Dui美化界面

- 爱心援助动态网页教程:前端开发实战指南

- 复旦微电子数字电路课件4章同步时序电路详解

- Dylan Manley的编程投资组合登录页面设计介绍

- Python实现H3K4me3与H3K27ac表观遗传标记域长度分析

- 易语言开源播放器项目:简易界面与强大的音频支持

- 介绍rxtx2.2全系统环境下的Java版本使用

- ZStack-CC2530 半开源协议栈使用与安装指南

- 易语言实现的八斗平台与淘宝评论采集软件开发

- Christiano响应式网站项目设计与技术特点

- QT图形框架中QGraphicRectItem的插入与缩放技术

- 组合逻辑电路深入解析与习题教程

- Vue+ECharts实现中国地图3D展示与交互功能

- MiSTer_MAME_SCRIPTS:自动下载MAME与HBMAME脚本指南

- 前端技术精髓:构建响应式盆栽展示网站

已收录资源合集

已收录资源合集