神经网络训练入门:激活函数与解决策略

需积分: 0 173 浏览量

更新于2024-08-05

收藏 1.23MB PDF 举报

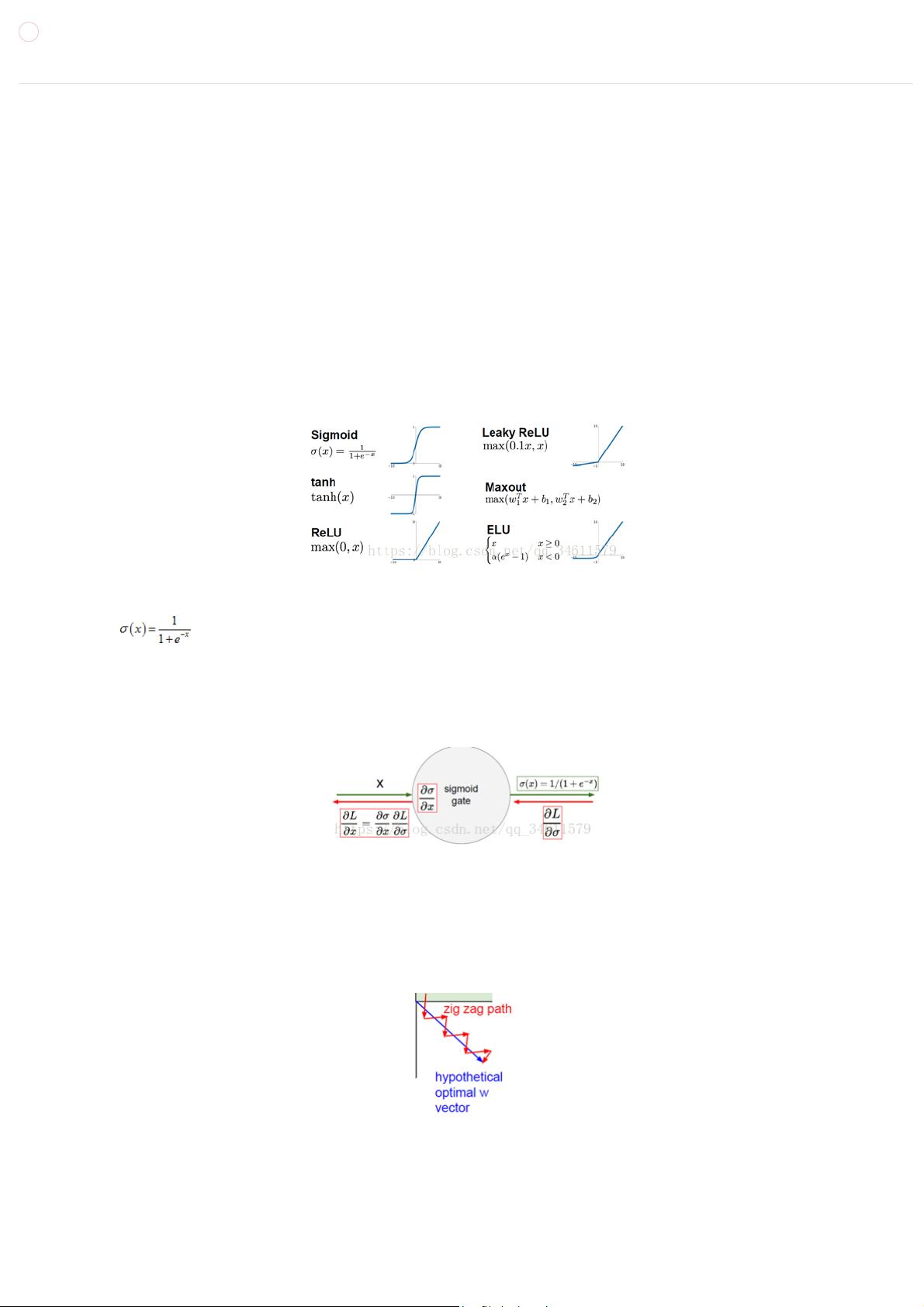

本篇内容主要讲解了第六章《训练神经网络(上)》的第一课时,重点讨论了激活函数在神经网络中的关键作用。神经网络由多个线性层构成,非线性函数如激活函数(sigmoid、tanh和ReLU)在层间连接中起着至关重要的作用,它们决定了网络的非线性表示能力。

首先,激活函数的选择至关重要,因为它们决定网络的输出范围和动态特性。sigmoid函数将输入压缩到[0,1]区间,但存在梯度消失问题,特别是在输入值极端时。其非零中心性质导致梯度更新效率低下。tanh函数类似sigmoid,但范围扩展到[-1,1],解决了sigmoid的第二个问题,但也同样面临梯度消失。ReLU函数(Rectified Linear Unit)避免了这些问题,当输入为正时保持不变,为0时输出为0,具有很好的非饱和特性,计算成本低,且梯度更新更有效。

课程还涉及其他训练神经网络的关键环节,例如:

1. **神经网络建立**:介绍如何设计和构建网络结构,包括全连接层和卷积层的配置。

2. **数据预处理**:包括数据清洗、归一化等步骤,以提升模型性能。

3. **权重初始化**:恰当的权重初始化有助于网络更快收敛和避免梯度消失/爆炸。

4. **正则化**:防止过拟合,如L1、L2正则化,以及Dropout技术。

5. **梯度检查**:确保优化过程中的梯度计算准确无误。

6. **动态变化和训练监控**:理解训练过程中模型参数的变化趋势,如学习率调整、验证集监测等。

7. **超参数优化**:通过网格搜索、随机搜索等方法调整模型参数以优化性能。

8. **模型评估**:使用指标如准确率、损失函数等来衡量模型的性能。

9. **模型集成**:通过集成多个模型来提高预测的稳定性和准确性。

整体来看,本节内容深入浅出地阐述了神经网络训练中的核心概念和技术细节,对于理解和实践神经网络的训练至关重要。

419 浏览量

2020-02-07 上传

2024-07-11 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

禁忌的爱

- 粉丝: 21

- 资源: 334

最新资源

- Theme-project

- 预算跟踪工具PWA

- ElementaryCellularAutomata:演示Wolfram基本元胞自动机的交互式GUI

- lotus:结合 CSS4 和 JavaScript 模板以获得乐趣和荒谬

- 毕业设计&课设--毕业设计之SpringCloud-B2C电子商务平台服务端.zip

- Excel模板暑假学生计划表.zip

- wechatDatDecode:微信dat文件解码,Windows系统下载exe文件可直接使用

- 马拉松屏幕更新程序:BabyNodeCG

- Delete-files-older-than-and-empty-directories:准备将简单脚本复制粘贴到任务计划程序中

- physiotherapy:它是适用于mvvm架构的移动应用程序草案,专家可以在其中跟踪物理治疗患者

- folksy:教育游戏的框架

- Excel模板00数量金额式明细帐.zip

- node-ec-pem:使用`crypto.createECDH`生成的密钥启用`crypto.sign`和`crypto.verify`

- Dart-Cms-Manage:这是Dart-Cms后台管理系统页面项目,使用vue全家桶

- 同策-2018-2019年房企融资白皮书-2019.1-61页.rar

- DGM-Competency-Browser:该项目允许学生、教师和雇主看到课程和特定能力之间的联系