理解分类任务评价指标:Accuracy、Precision与Recall

6 浏览量

更新于2024-08-31

收藏 533KB PDF 举报

"本文主要介绍了分类任务中的模型评估指标,包括混淆矩阵、准确率、精度和召回率。通过实例解析True/Positive等概念,并探讨了这些指标在实际应用中的意义和相互关系。"

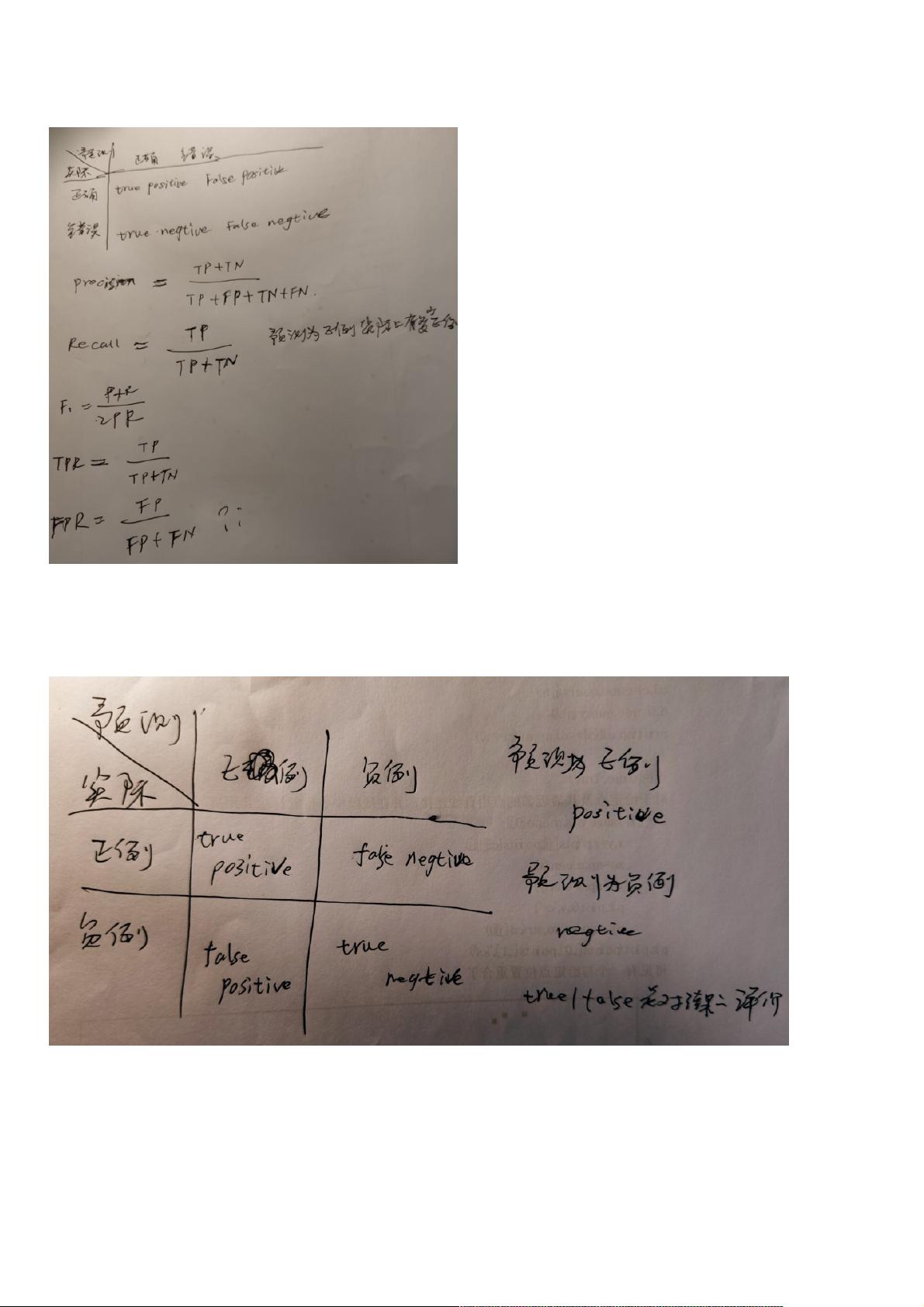

在分类任务中,模型评估是至关重要的,它能帮助我们判断模型的性能和适用性。首先,我们要理解混淆矩阵的基本概念。混淆矩阵由True Positive (TP),True Negative (TN),False Positive (FP) 和 False Negative (FN) 四个元素构成,它们分别代表预测正确且为正例、预测正确且为负例、预测错误为正例但实际上为负例以及预测错误为负例但实际上为正例的情况。

True/False 是用来衡量预测结果是否正确,而Positive/Negative则关注实际的分类标签。例如,在医学检测中,Positive通常指阳性结果,Negative则表示阴性。正确理解这些概念有助于我们正确解读混淆矩阵。

接下来,我们来看几个关键的评估指标:

1. 准确率(Accuracy): 它是最直观的评估标准,表示模型预测正确的样本比例。Accuracy = (TP + TN) / (TP + FP + FN + TN)。虽然简单易懂,但在类别不平衡的情况下可能会误导,因为模型可能过于倾向于多数类。

2. 精确率(Precision): 表示被模型预测为正例的样本中,真正为正例的比例。Precision = TP / (TP + FP)。它强调了预测为正例的样本的准确性,适用于误报成本较高的场景。

3. 召回率(Recall, Sensitivity): 表示实际为正例的样本中,被模型成功识别为正例的比例。Recall = TP / (TP + FN)。召回率关注的是模型捕捉到所有正例的能力,尤其在漏报代价高的情况下非常重要。

精确率和召回率通常存在权衡关系,提高一个可能导致另一个下降。为了同时考虑两者,我们可以引入F1分数,它是精确率和召回率的调和平均值,F1 = 2 * Precision * Recall / (Precision + Recall)。

在实际应用中,根据业务需求选择合适的评估指标至关重要。例如,如果我们的目标是找出尽可能多的阳性病例,即使会有一定的假阳性,召回率可能是更重要的考量;而如果更关心避免假阳性的出现,那么精确率将是优先考虑的指标。

此外,AUC(Area Under the Curve)是另一个常用的评价指标,特别是在二分类问题中,它衡量了模型区分正负样本的能力。高AUC值意味着模型在不同阈值下的表现都较好。

理解并选择合适的评估指标是优化模型性能的关键步骤。通过对模型的准确率、精确率、召回率等多维度的评估,我们可以全面了解模型的优劣,并据此进行调整和优化。

164 浏览量

2324 浏览量

点击了解资源详情

148 浏览量

点击了解资源详情

2025-01-27 上传

2025-02-03 上传

2025-02-15 上传

2025-03-13 上传

weixin_38652196

- 粉丝: 2

最新资源

- ASP.NET集成支付宝即时到账支付流程详解

- C++递推法在解决三道经典算法问题中的应用

- Qt_MARCHING_CUBES算法在面绘制中的应用

- 传感器原理与应用课程习题解答指南

- 乐高FLL2017-2018任务挑战解析:饮水思源

- Jquery Ui婚礼祝福特效:经典30款小型设计

- 紧急定位伴侣:蓝光文字的位置追踪功能

- MATLAB神经网络实用案例分析大全

- Masm611: 安全高效的汇编语言调试工具

- 3DCurator:彩色木雕CT数据的3D可视化解决方案

- 聊天留言网站开发项目全套资源下载

- 触摸屏适用的左右循环拖动展示技术

- 新型不连续导电模式V_2控制Buck变换器研究分析

- 用户自定义JavaScript脚本集合分享

- 易语言实现非主流方式获取网关IP源码教程

- 微信跳一跳小程序前端源码解析