LDA与pLSA:主题模型的深度解析与比较

145 浏览量

更新于2024-08-28

收藏 816KB PDF 举报

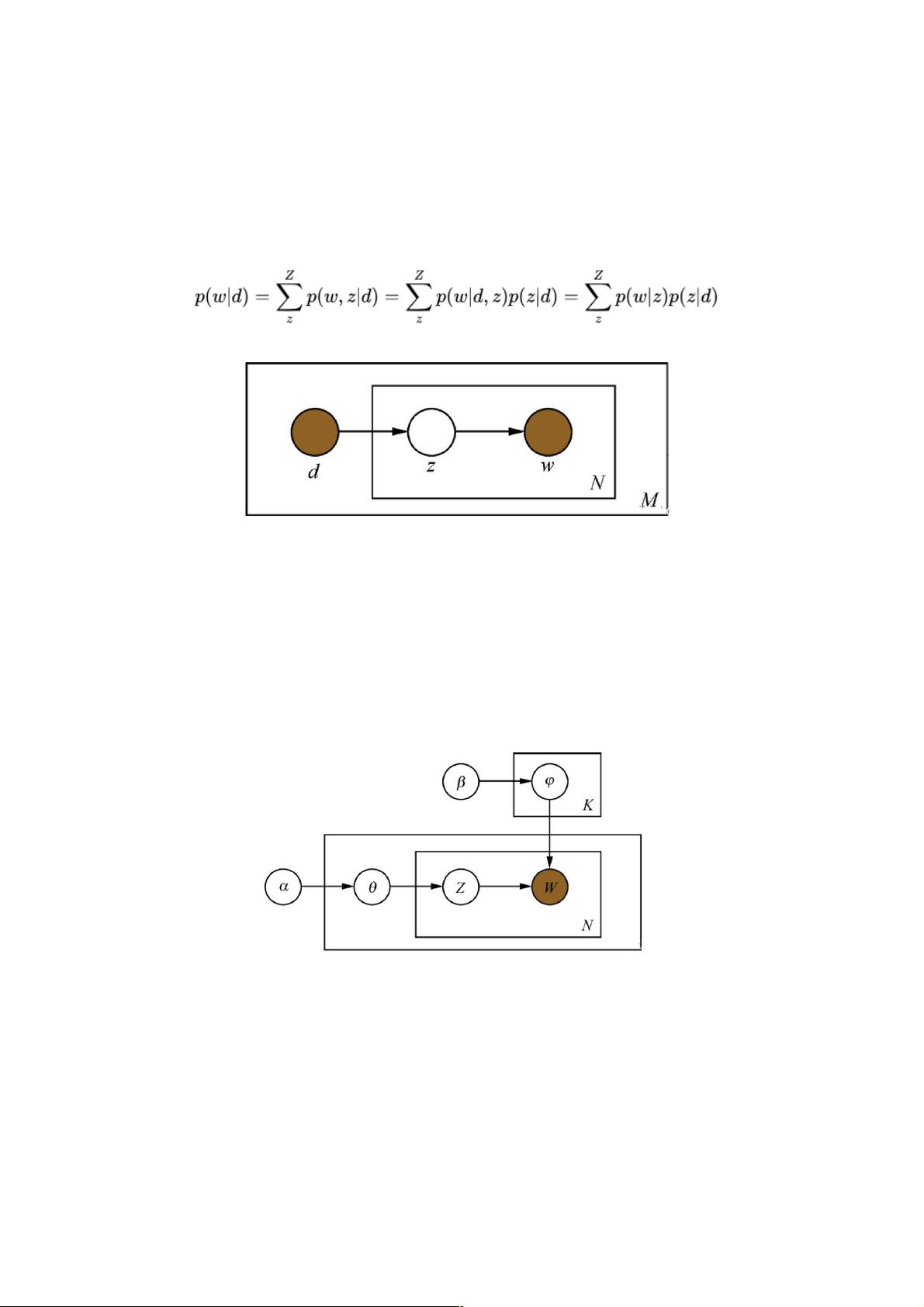

在自然语言处理(NLP)中,主题模型是一种用于发现文档集合中潜在主题的技术,其中最知名的两种是pLSA (Probabilistic Latent Semantic Analysis) 和 LDA (Latent Dirichlet Allocation)。pLSA是一个生成模型,它假设文章由K个主题构成,每个主题关联着一组词的概率分布。在pLSA中,文章中的每个词生成过程分为两个步骤:首先随机选择一个主题,然后根据该主题生成具体词汇。pLSA的模型参数,如主题分布和词分布,被视为确定性常数,通过EM算法求解。

然而,LDA作为pLSA的贝叶斯版本,引入了狄利克雷分布作为先验概率分布,使得主题分布和词分布不再是固定的,而是随机变量。这种贝叶斯框架允许我们考虑先验知识,如主题出现的概率,从而增强了模型的灵活性。狄利克雷分布的选择基于其与多项式分布的共轭性,便于后验概率的计算。

LDA的概率图模型中,超参数α和β控制着狄利克雷分布的浓度,通常由用户手动设定。相较于pLSA,LDA的一个关键优势是可以处理非训练数据,因为它考虑了主题概率的先验信息。例如,体育主题的出现概率通常高于哲学主题,这种常识性的先验知识在LDA中得到了体现。

在数学基础上,LDA涉及到的概率概念包括二项分布和多项分布,这些是统计学中的基本工具。例如,二项分布用于计数成功次数,多项分布则是二项分布的推广,适用于多个独立事件的组合。此外,Gamma函数在概率论中有重要作用,它是阶乘函数的扩展,具有重要的积分性质。LDA中的Dirichlet分布是Beta分布的一维推广,用于表示多维概率分布,它的应用在计算主题和词的混合系数时尤为显著。

总结来说,LDA和pLSA是NLP主题模型的两个核心代表,它们通过不同的概率模型和先验假设,提供了文本主题发现的强大工具。理解和掌握这些模型不仅有助于文本分析,也对信息检索、推荐系统等领域有着深远的影响。

2023-10-11 上传

2024-01-03 上传

2023-03-23 上传

2021-02-03 上传

点击了解资源详情

2017-08-22 上传

2022-04-26 上传

2009-08-08 上传

2023-08-12 上传

weixin_38600696

- 粉丝: 6

- 资源: 967

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载