Python爬虫基础:Requests库详解与实战

需积分: 50 114 浏览量

更新于2024-07-19

1

收藏 2.26MB PDF 举报

"Python网络爬虫与信息提取课程,由嵩天老师主讲,重点介绍Requests库的使用。"

在Python编程领域,网络爬虫是一种重要的技术,用于自动化地抓取互联网上的信息。Requests库是Python中广泛使用的HTTP客户端库,它使得发送HTTP请求变得简单而直观。本课程由嵩天老师指导,旨在教授如何使用Requests库进行定向网络数据爬取和网页解析,提升开发者处理网络数据的能力。

首先,让我们详细了解Requests库的一些主要功能和方法:

1. **requests.request()**: 这是所有请求方法的基础,可以根据需要构建各种HTTP请求。

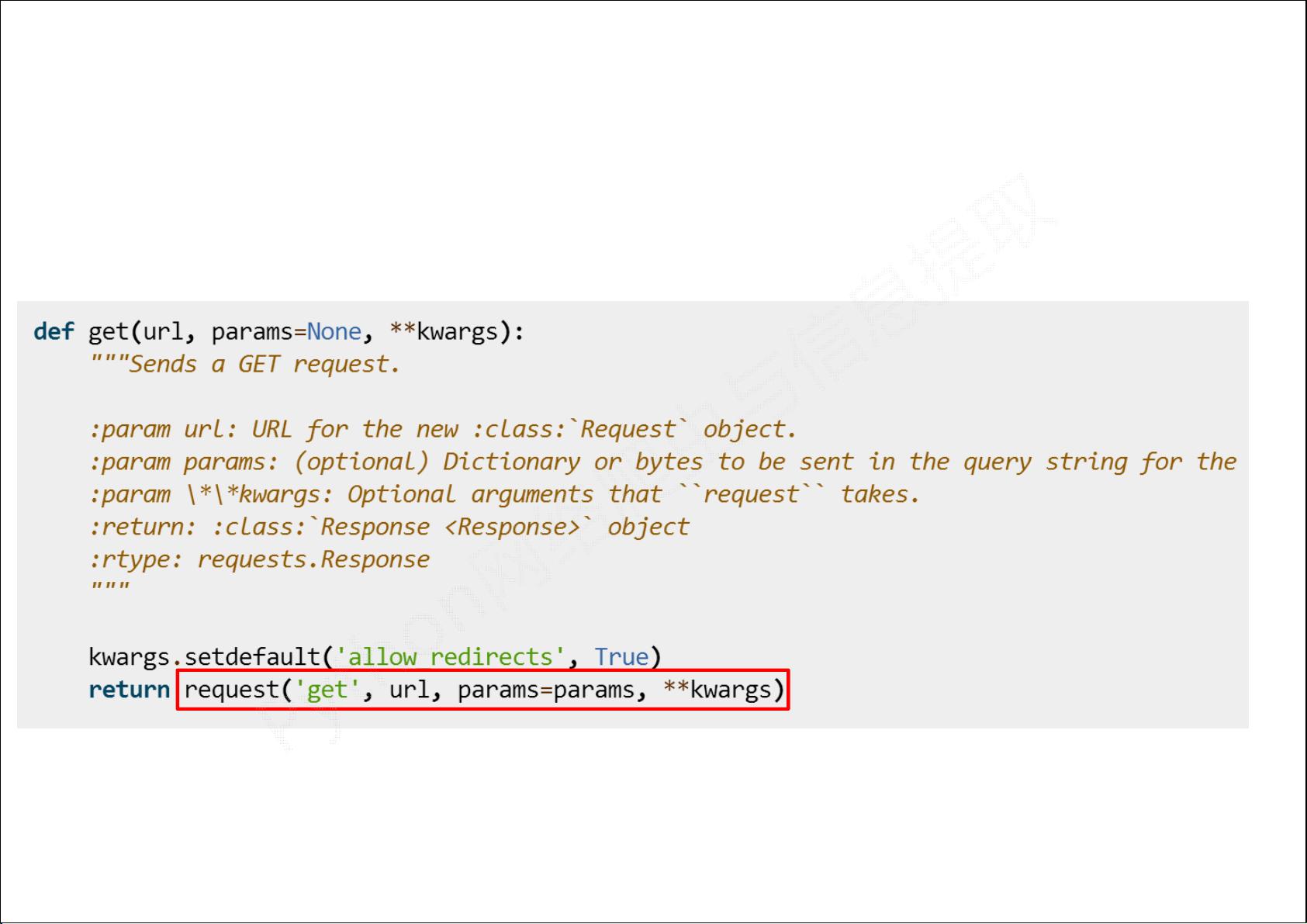

2. **requests.get()**: 最常用的方法,用于获取网页的HTML内容,对应HTTP的GET方法。例如:`r = requests.get(url)`,返回一个包含服务器响应的Response对象。

3. **requests.head()**: 获取HTML页面的头部信息,不获取整个页面内容,对应HTTP的HEAD方法。

4. **requests.post()**: 用于向服务器提交POST请求,常用于表单提交或数据上传,对应HTTP的POST方法。

5. **requests.put()**: 提交PUT请求,用于更新已有资源,对应HTTP的PUT方法。

6. **requests.patch()**: 提交局部修改请求,对应HTTP的PATCH方法,用于部分更新资源。

7. **requests.delete()**: 发送DELETE请求,用于删除资源,对应HTTP的DELETE方法。

在使用Requests库时,通常会涉及到以下操作:

- **安装Requests**: 在Windows上,可以以管理员身份运行cmd,然后执行`pip install requests`来安装。

- **请求参数**: `requests.get(url, params=None, **kwargs)`,其中`url`是目标URL,`params`用于添加URL参数,`**kwargs`可以包括其他控制访问的参数,如`headers`、`cookies`等。

- **Response对象**: 请求后会返回一个Response对象,包含了服务器的响应信息。

- `r.status_code`: 反映HTTP请求的返回状态,如200表示成功,404表示未找到。

- `r.text`: HTTP响应内容的文本形式,即网页的HTML内容。

- `r.encoding`: 自动从HTTP头部猜测的响应内容编码方式,可用于正确解码文本。

通过学习和实践这些基础知识,开发者能够构建自己的网络爬虫,实现自动化获取和处理网络上的信息。掌握Requests库不仅有助于数据抓取,还能在API接口调用、自动化测试等多个场景中发挥作用。在Python网络爬虫的旅程中,Requests库是不可或缺的工具之一。

2018-12-01 上传

2019-04-24 上传

2021-11-13 上传

2023-03-30 上传

2020-12-22 上传

2021-11-13 上传

2022-08-03 上传

2024-12-02 上传

我要七龙ru

- 粉丝: 23

- 资源: 2

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用