NLP中的注意力机制解析

版权申诉

19 浏览量

更新于2024-07-19

收藏 3.95MB PPTX 举报

"NLP中的注意力机制.pptx 深入探讨了自然语言处理(NLP)中的注意力机制,这是深度学习在处理序列到序列任务时的一个关键概念。该资源指出,注意力机制允许模型根据输入序列的不同部分对输出序列的重要性进行加权,从而提升预测效果。"

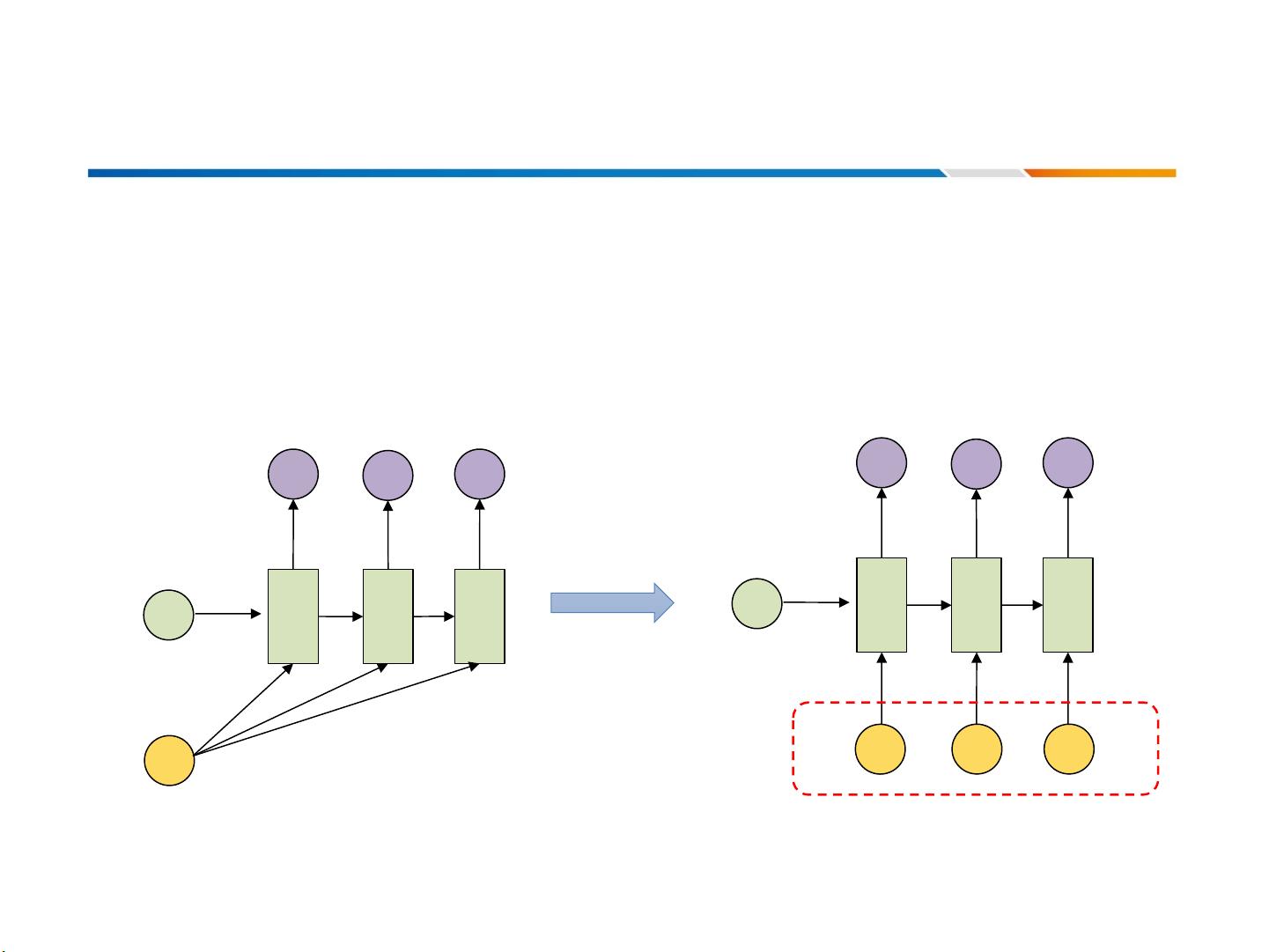

在NLP中,注意力机制(Attention Mechanism)是一种模仿人类注意力的计算模型,它解决了传统SequencetoSequence Model(Seq2Seq模型)中固定长度的中间向量(c)限制模型性能的问题。Seq2Seq模型通常由一个编码器和一个解码器组成,编码器将输入序列转化为固定长度的上下文向量,然后解码器根据这个向量生成输出序列。然而,当输入序列过长时,单个向量可能无法捕获所有重要信息。

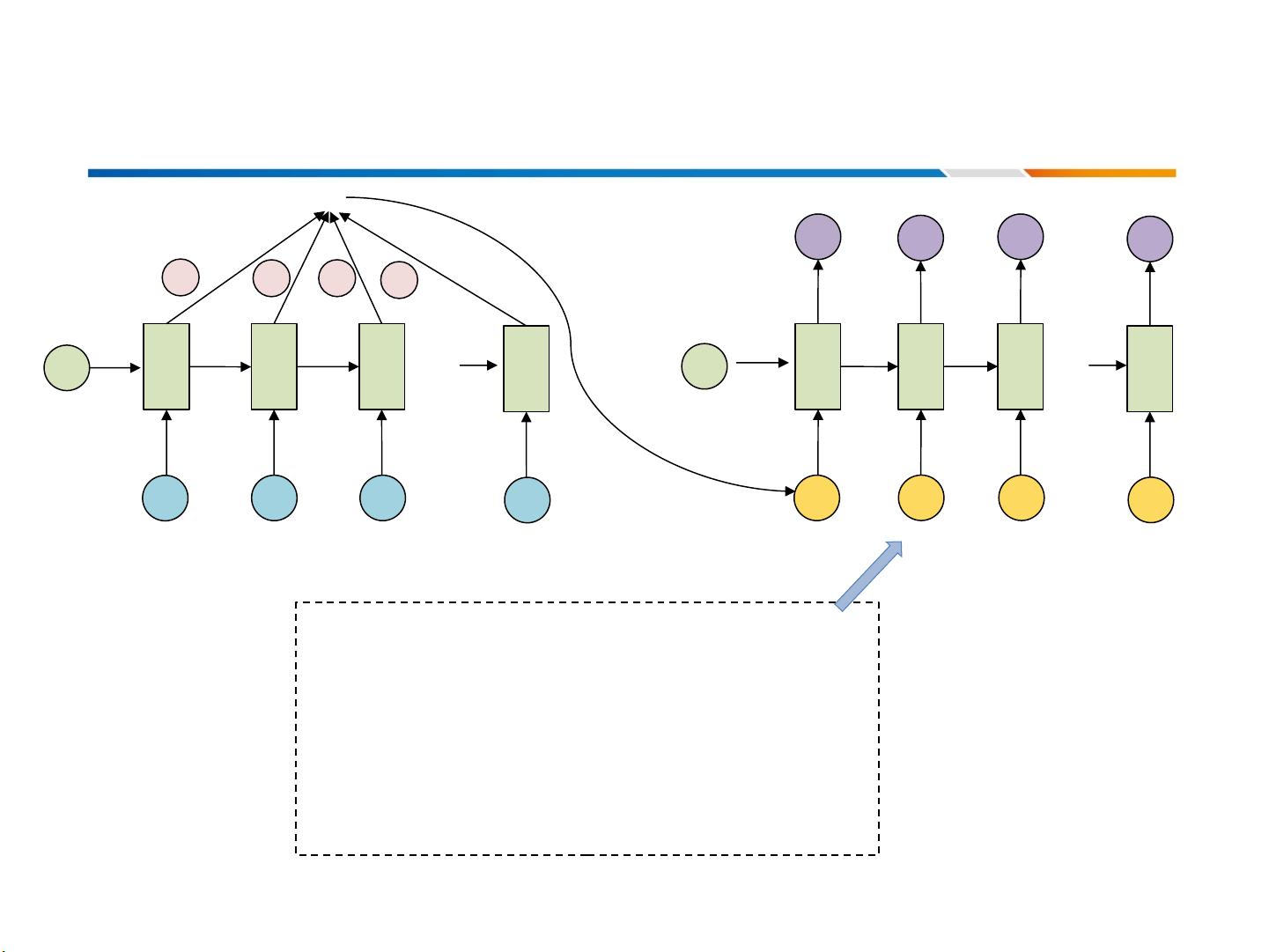

注意力机制的引入解决了这一问题,它允许模型在生成每个输出单元时“聚焦”或分配不同的权重给输入序列的不同部分。这种机制通过计算输入序列中各个位置的注意力得分,形成一个注意力分布,该分布反映了输入序列中不同部分对当前输出的重要性。注意力得分通常是通过对编码器的隐藏状态和解码器的当前状态进行计算得到的。

具体来说,注意力机制可以分为几个步骤:

1. 计算注意力得分:使用一个称为注意力函数的加权函数,如点积注意力、卷积注意力或Transformer中的多头注意力,来计算输入序列中每个位置与解码器当前状态的相似度。

2. 形成注意力分布:将注意力得分通过softmax函数归一化,得到一个概率分布,表示每个输入位置的重要性。

3. 生成加权上下文向量:根据注意力分布,对编码器的所有隐藏状态进行加权求和,得到一个加权上下文向量,它包含了输入序列的关键信息。

4. 结合上下文向量:将这个加权上下文向量与解码器的当前状态相结合,用于生成下一个输出单位。

在文本生成、机器翻译、问答系统等NLP任务中,注意力机制显著提高了模型的性能和可解释性。例如,在机器翻译中,模型可以根据源语言句子的不同部分调整其焦点,更准确地生成目标语言的对应翻译。此外,通过可视化注意力分布,我们可以理解模型在处理任务时关注的输入区域,这对于模型的调试和解释非常有用。

总结来说,注意力机制是NLP中的一种强大工具,它增强了Seq2Seq模型处理长序列和复杂依赖关系的能力,使模型能够更灵活地关注输入序列中的关键信息。通过这种方式,注意力机制推动了NLP领域的发展,尤其是在深度学习模型的设计和优化上。

2023-10-12 上传

2023-04-23 上传

2023-04-23 上传

2023-04-23 上传

2021-04-08 上传

2023-04-23 上传

2023-04-23 上传

2024-06-02 上传

2020-12-15 上传

AI算法攻城狮

- 粉丝: 1w+

- 资源: 39