大数据基础与Hadoop核心解析

版权申诉

4 浏览量

更新于2024-07-02

收藏 1019KB PDF 举报

"该资源是一份关于大数据课程的复习题,涵盖了大数据的定义、特点、Hadoop的相关知识以及Hadoop生态系统的部分组件。"

大数据,作为近年来信息技术领域的重要概念,是指那些传统数据处理工具难以应对的海量、多样、高速的数据信息。它的三大特点即3Vs:Volume(大量)、Variety(多样)、Velocity(高速)。Volume强调数据的规模,从TB到PB级别的增长;Variety则关注数据类型的多样性,包括非结构化(如文本、图像、音频)、半结构化(如日志数据)和结构化数据(如行列整齐的数据库表单);Velocity意味着数据的时效性,很多数据在短时间内就有很高的价值,需要快速处理。

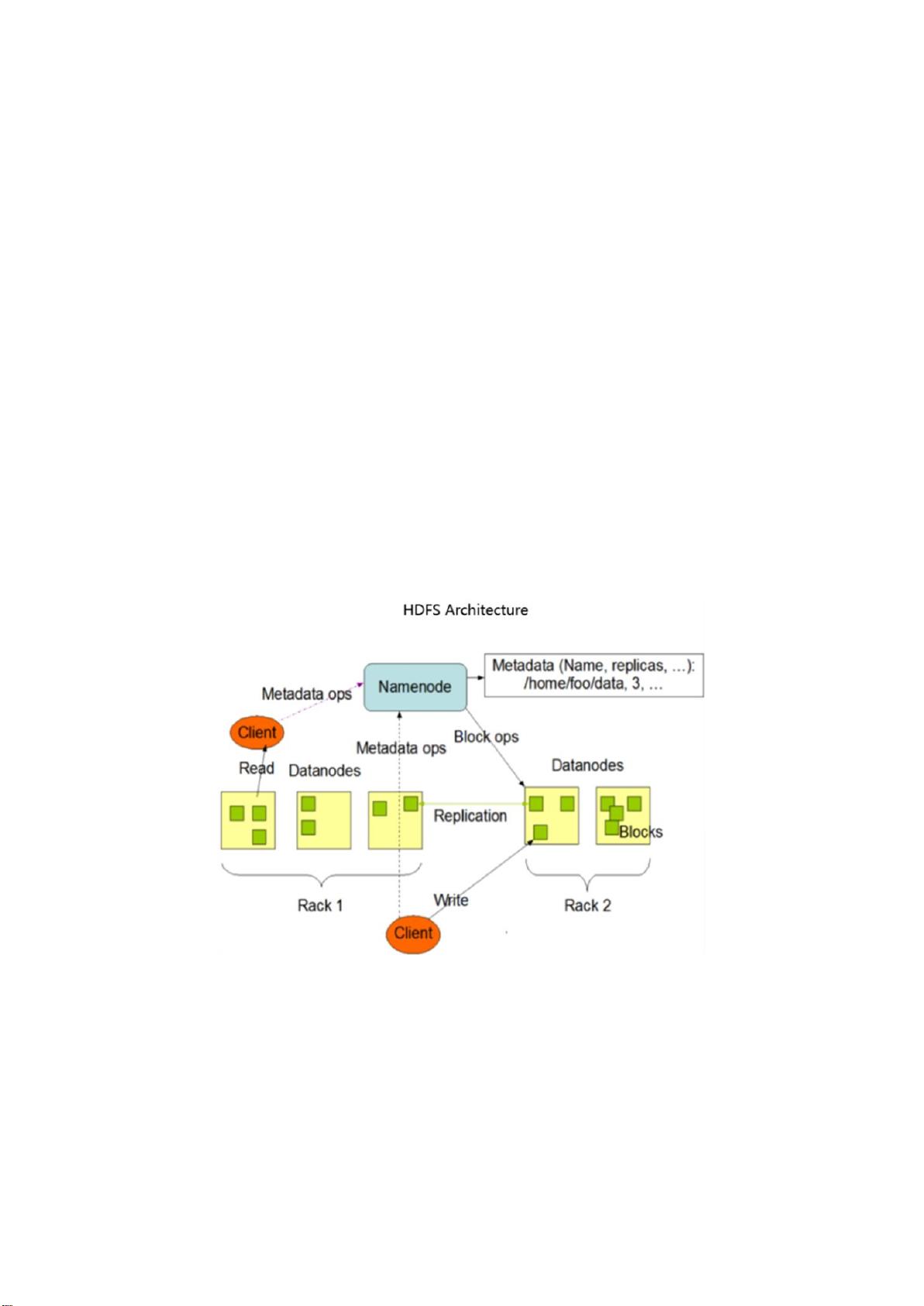

Hadoop作为一个开源的框架,自2002年由Doug Cutting发起,主要由两个核心组件组成:分布式文件系统HDFS和分布式数据处理架构MapReduce。HDFS将大数据分片存储在大量节点上,保证了数据的高可用性;MapReduce则通过在数据节点上执行计算,降低了I/O成本,并且其灵活性使得开发人员可以轻松创建各种应用。

Hadoop具有多个显著优点:高可靠性,通过数据冗余确保数据安全;高扩展性,能轻易扩展到数千节点;高效性,通过数据本地化处理提升速度;高容错性,能够自动恢复失败任务;以及低成本,开源特性降低了软件投入。此外,Hadoop生态系统包括了一系列工具,如Ambari用于集群管理和监控,Flume负责日志收集,HBase是面向列的分布式数据库,HCatalog管理Hadoop数据的表存储,Hive提供类似SQL的查询接口,Hue提供图形用户界面,Pig则支持大数据分析等。

这份复习题不仅涉及大数据的基础概念,还深入探讨了Hadoop及其生态,对学习者理解大数据处理和分析有极大的帮助。通过学习这些知识点,学生可以更好地掌握大数据技术的核心原理和实际应用。

2021-05-29 上传

2021-09-30 上传

2021-12-21 上传

2021-09-27 上传

2021-08-15 上传

2019-07-15 上传

是空空呀

- 粉丝: 192

- 资源: 3万+

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率