斯坦福深度学习课程:NLP讲座3 - Skip-gram模型与词向量优化

需积分: 9 9 浏览量

更新于2024-07-21

收藏 2.39MB PDF 举报

在斯坦福大学的深度学习课程中,Richard Socher教授深入讲解了自然语言处理(NLP)中的一个重要概念——Word2Vec模型。这门讲座是第三讲,主要回顾了简单版的word2vec模型,其核心在于理解词向量的表示和预测上下文单词的概率。

在word2vec模型中,成本函数J的主要目标是寻找一个词在句子或文档中的语义相关词汇,特别是通过skip-gram模型来实现这一点。skip-gram模型的基本形式定义了条件概率p(wt+j|wt),即给定中心词(target word)wt预测周围词(context word)wt+j的概率。这个概率计算公式是:

p(wt+j|wt) = (v'_{w_t+j})^T v_{w_t} / Z

其中,v_{w_t}和v'_{w_t+j}分别代表中心词和上下文词的向量表示,Z是对所有可能的词对进行归一化的常数。公式表明,词向量的相似度决定了上下文词出现的可能性。

在实际应用中,计算这个概率时,需要处理非常大的矩阵W,其中包含词汇表中所有词的向量。由于矩阵W的大小通常在10^5到10^7之间,这就可能导致计算时间和内存消耗较大。因此,优化方法是仅计算与当前上下文词相关的部分梯度,而不是整个矩阵。

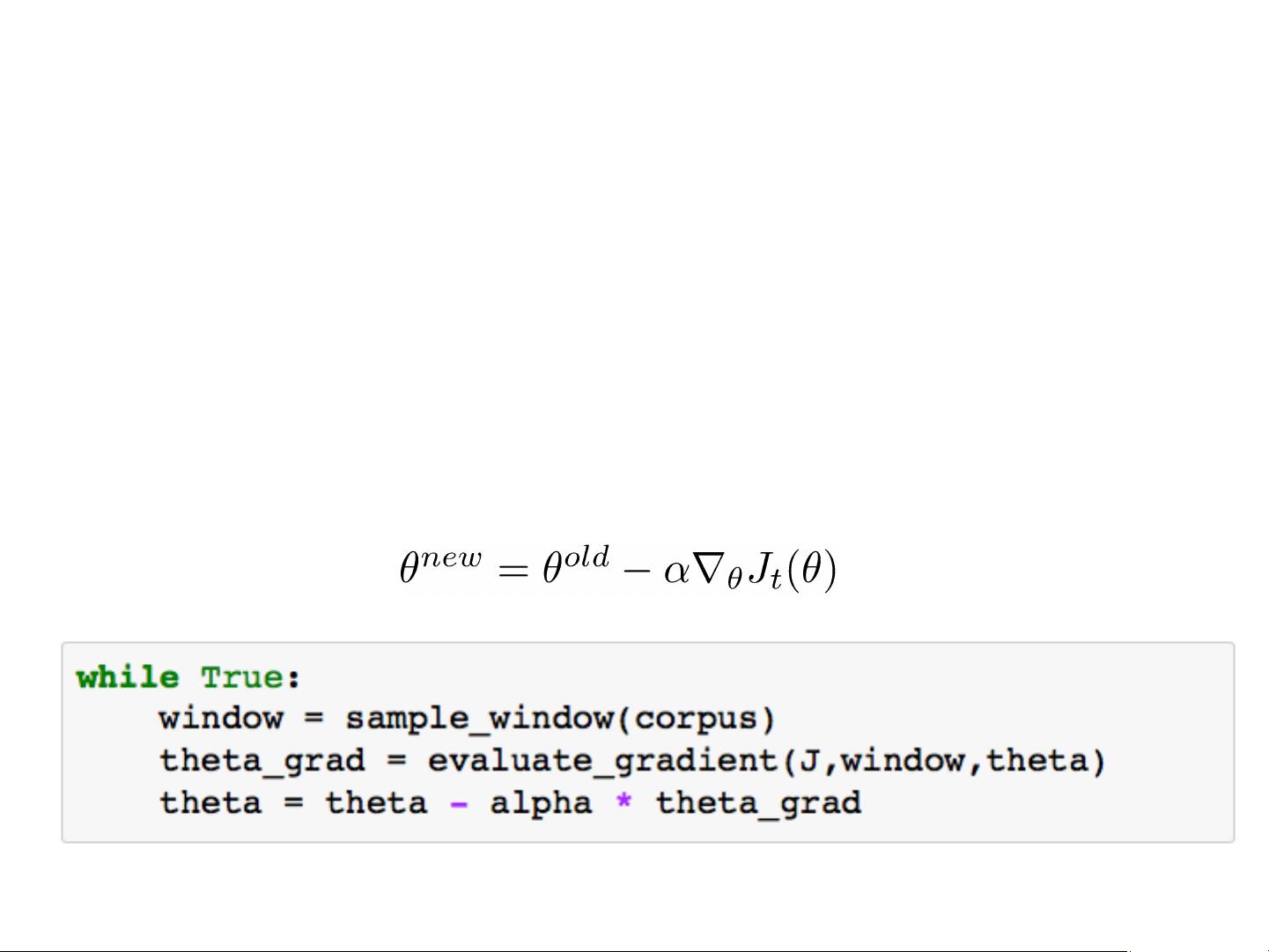

计算梯度的过程涉及到每个中心词向量v的梯度更新。这部分涉及到了softmax函数和负采样技术,它们可以有效地降低计算复杂性,使得训练过程在可接受的时间内完成。通过对每个中心词向量v的梯度进行计算,模型能够调整词向量,使得词与词之间的关系更加准确,从而提升在诸如文本分类、情感分析等NLP任务中的表现。

这一节的内容重点在于理解word2vec模型的工作原理,包括梯度计算的优化策略以及如何利用深度学习方法来增强词向量的表示能力,以便更好地捕捉词语之间的语义和语法关系。这对于理解和应用深度学习在NLP领域的实际应用具有重要意义。

2015-09-30 上传

2015-09-30 上传

2018-08-15 上传

2017-12-22 上传

2021-10-02 上传

2018-08-01 上传

2017-11-17 上传

2019-12-15 上传

2017-08-15 上传

Nicoder

- 粉丝: 70

- 资源: 6

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜