Windows下Spark环境搭建教程:步骤详解

版权申诉

本篇文章主要介绍了在Windows环境下搭建Spark开发环境的详细步骤,涉及到几个关键组件的安装和配置。以下是主要内容概要:

1. **环境需求**:

- JDK:推荐使用Java Development Kit (JDK) 1.8版本,因为Spark支持的JDK版本通常与之兼容。

- Scala:推荐使用Scala 2.12版本,这是Spark的一个重要依赖。

- Hadoop:选择Hadoop 2.7.3版本,尤其是对于Windows用户,由于特定版本的兼容性问题,需要特别注意。

- Spark:建议使用Spark 2.3.3版本,因为2.4.0版本在Windows上存在已知问题。

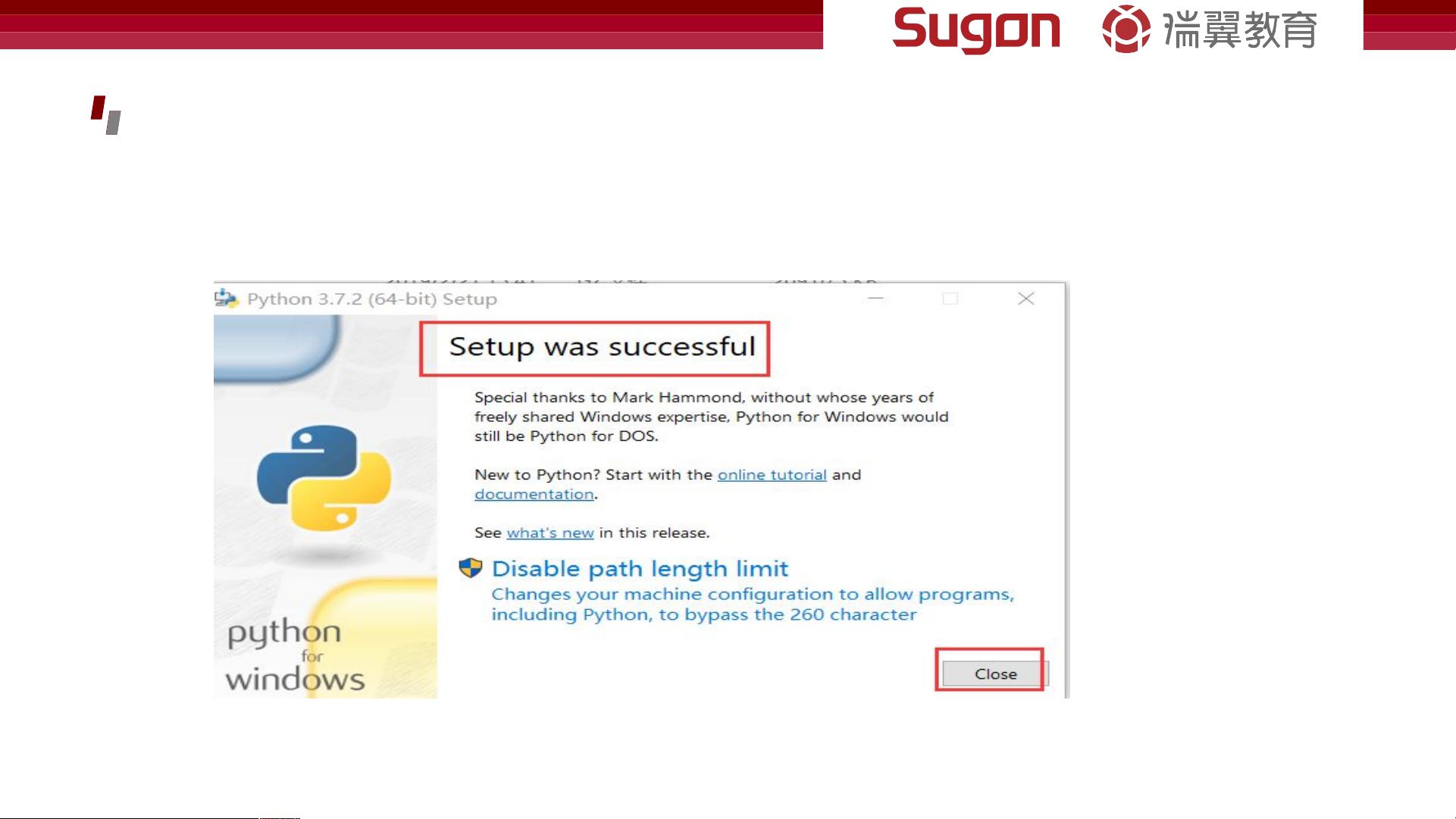

2. **Python安装**:

- 安装Python 3.7.2,提供两种安装选项:默认路径或自定义路径,选择后者以灵活设置路径,同时勾选"Add Python3.7 to Path"来自动配置环境变量。

- 验证安装:通过命令行输入`python`和`piplist`检查Python和pip是否配置正确。

3. **JDK安装**:

- 下载JDK安装包,选择安装路径时避免使用包含空格的路径,以免导致错误。

- 创建专门的目录如"jdk8",然后进行安装,并配置环境变量JAVA_HOME指向安装目录的bin。

4. **JRE安装**:

- JDK安装后,需要安装JRE(Java Runtime Environment),创建一个名为"jre8"的子目录,并配置CLASSPATH环境变量。

5. **环境配置**:

- 完成所有组件的安装后,确保环境变量设置正确,包括Python、JDK和JRE的路径。可以通过打开命令行并执行相关命令来验证配置是否生效。

这些步骤是针对Windows环境搭建Spark所需的基本配置,实际操作时可能需要根据个人系统情况和特定需求进行调整。通过遵循本文提供的步骤,用户可以为Spark开发环境打下坚实的基础。

2018-06-12 上传

2019-01-09 上传

2018-08-31 上传

2021-03-27 上传

2018-06-22 上传

2018-01-22 上传

2020-09-04 上传

2021-01-07 上传

2019-03-26 上传

王小王-123

- 粉丝: 7w+

- 资源: 106

最新资源

- 火炬连体网络在MNIST的2D嵌入实现示例

- Angular插件增强Application Insights JavaScript SDK功能

- 实时三维重建:InfiniTAM的ros驱动应用

- Spring与Mybatis整合的配置与实践

- Vozy前端技术测试深入体验与模板参考

- React应用实现语音转文字功能介绍

- PHPMailer-6.6.4: PHP邮件收发类库的详细介绍

- Felineboard:为猫主人设计的交互式仪表板

- PGRFileManager:功能强大的开源Ajax文件管理器

- Pytest-Html定制测试报告与源代码封装教程

- Angular开发与部署指南:从创建到测试

- BASIC-BINARY-IPC系统:进程间通信的非阻塞接口

- LTK3D: Common Lisp中的基础3D图形实现

- Timer-Counter-Lister:官方源代码及更新发布

- Galaxia REST API:面向地球问题的解决方案

- Node.js模块:随机动物实例教程与源码解析