Hadoop源码深度解析:分布式文件系统与MapReduce

需积分: 9 151 浏览量

更新于2024-07-24

收藏 5.91MB DOC 举报

"对Hadoop源码的分析,包括HDFS和MapReduce的依赖关系与功能解析。"

在深入探讨Hadoop源码之前,先要理解Hadoop的起源和其在分布式计算领域的地位。Hadoop源自Google提出的五篇核心技术论文,包括GoogleCluster、Chubby、GFS、BigTable和MapReduce。Apache社区基于这些理念开发了开源项目,如ZooKeeper对应Chubby,HDFS对应GFS,HBase对应BigTable,以及Hadoop对应MapReduce。这些项目构建了一个强大的分布式计算框架,为大规模数据处理提供了基础。

Hadoop主要由两个核心组件构成:HDFS(Hadoop Distributed File System)和MapReduce。HDFS是一个高容错性的分布式文件系统,设计用于跨大量廉价硬件节点存储和处理大量数据。MapReduce则是处理这些数据的编程模型,通过将计算任务分解为映射(map)和化简(reduce)阶段,实现并行计算。

HDFS的设计允许数据在集群内部复制,确保容错性和高可用性。当文件被写入HDFS时,会被分割成块并分布在不同的节点上,每个块通常有多个副本。这种设计使得即使部分节点失效,数据仍可被访问,同时也支持并行处理。

MapReduce的工作流程分为三个主要步骤:split、map和reduce。首先,数据被split成适合处理的小块,然后map函数在各个节点上并行执行,处理数据块生成中间结果。最后,reduce函数收集和合并这些中间结果,产出最终结果。这种架构使得Hadoop能够高效地处理海量数据。

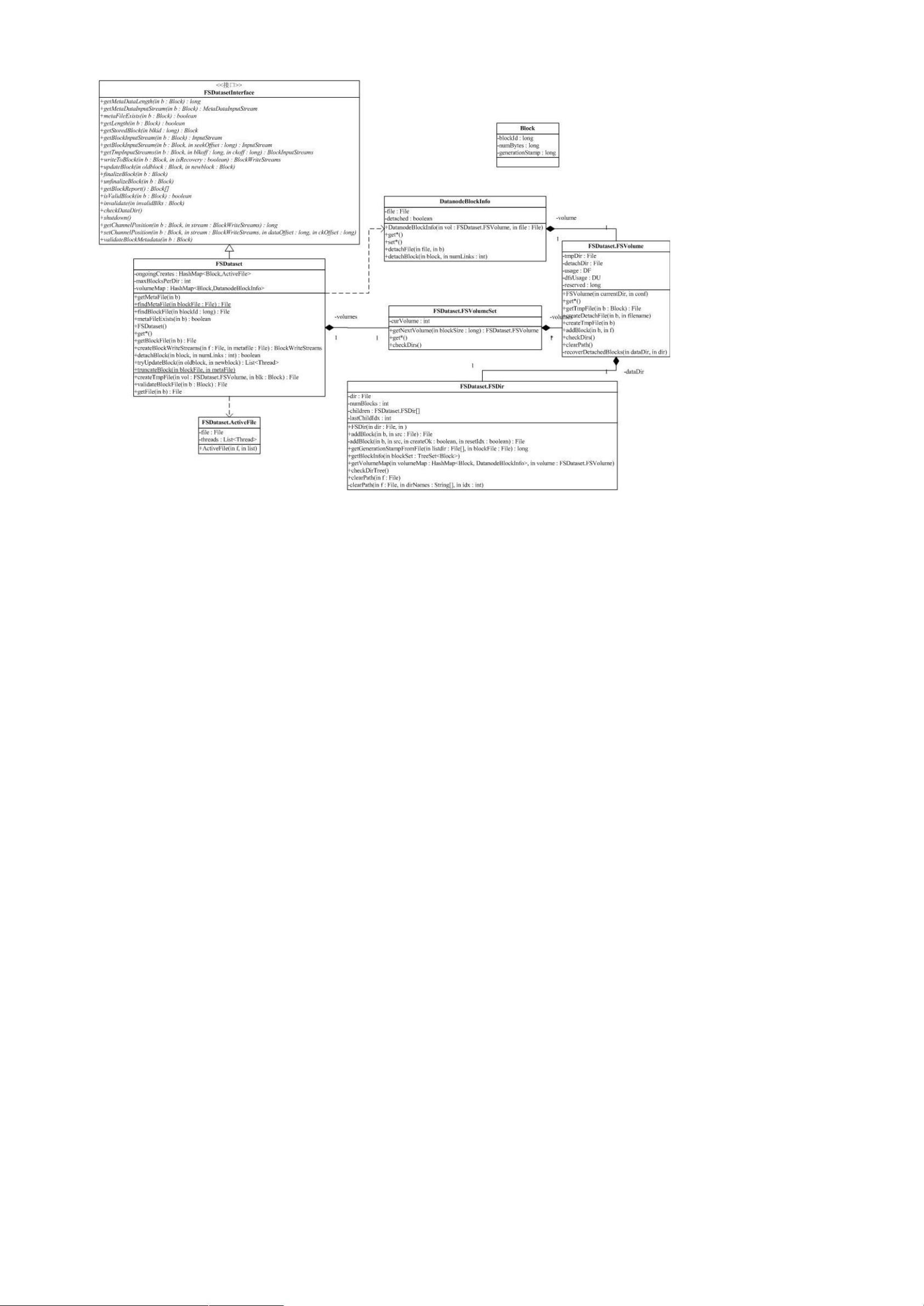

在源码层面,Hadoop的包间依赖关系复杂,如conf包依赖于fs包来读取系统配置。Hadoop的复杂性来源于其需要兼容多种文件系统,包括本地文件系统和云存储服务如Amazon S3。这种灵活性使得Hadoop能在各种环境中运行,但同时也增加了理解和调试的难度。

为了更好地分析Hadoop,我们需要关注其关键组件,如蓝色部分所示,包括HDFS的实现、MapReduce的作业调度、数据分发和错误恢复机制等。包的功能分析可以帮助我们理解各个组件如何协同工作,例如,`org.apache.hadoop.mapred`包包含了MapReduce作业的生命周期管理,而`org.apache.hadoop.fs`则封装了文件系统操作。

通过对Hadoop源码的深入分析,开发者可以理解其内部工作机制,优化性能,解决故障,甚至为Hadoop生态系统贡献新的功能或改进。对于大数据处理和分布式计算的研究者和实践者来说,掌握Hadoop源码是至关重要的一步。

1069 浏览量

143 浏览量

3503 浏览量

125 浏览量

2010-05-20 上传

111 浏览量

2012-06-19 上传

113 浏览量

2012-04-10 上传

shizhongwen

- 粉丝: 2

最新资源

- SQL Server系统数据库sysaltfiles与syscharsets详解

- Oracle EBS应用开发与客户化指南

- 自定义Flash FLV播放器教程:从基础到实践

- 使用C++连接Oracle OCI数据库示例

- Velocity模板语言中文教程:使用与指南

- ActionScript 3.0实战宝典:构建富互联网应用与XML处理

- Spring入门指南:IoC与DI详解

- JavaFX.Script:RIA开发的动态Java脚本技术

- C#实战:DataView深度探索与应用技巧

- C#入门基础与实战练习

- iBATIS-SqlMaps开发与优化指南

- Microsoft Speech SDK 5.1 TTS入门实例与语言设置

- GIS软件中的图层控制与地图浏览操作

- C# ASP.NET密技:结合客户端脚本实现交互功能

- VC++组件与ActiveX技术详解

- MFC应用框架:文档视图与序列化技术解析