CUDA C++编程指南(12.3版):GPU并行计算详解

需积分: 5 166 浏览量

更新于2024-06-17

收藏 4.3MB PDF 举报

《CUDA+C++ Programming Guide - 已翻译》是一本详细的教程,介绍了NVIDIA CUDA 12.3版本下的CUDA C++编程指南。CUDA是NVIDIA提供的一种通用并行计算平台和编程模型,旨在利用GPU(图形处理器)的强大并行处理能力进行高性能计算。本书分为多个章节,详细阐述了以下几个核心知识点:

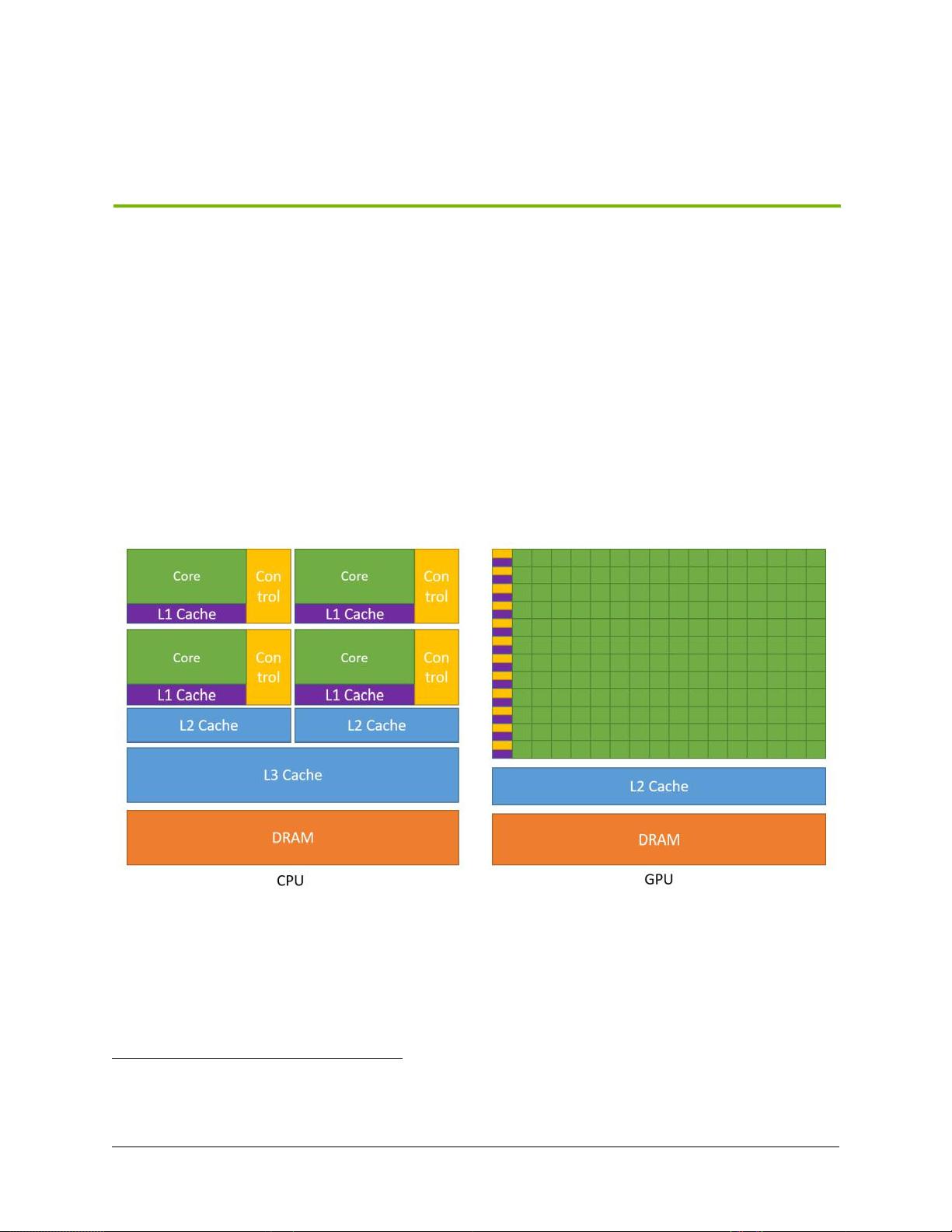

1. **GPU的优势**:CUDA编程强调了GPU在大规模并行任务中的优势,如图像处理、科学计算和机器学习等,其并行计算能力可以大幅提高计算效率。

2. **CUDA概述**:CUDA是一个平台,它提供了API(应用程序编程接口)让开发者编写能在GPU上运行的程序。CUDA编程模型基于数据并行性和流多处理器(Stream Multiprocessors)的概念。

3. **编程模型**:

- **内核**:CUDA程序的核心部分,由程序员编写的独立函数,可在多个线程中并行执行。

- **线程层次结构**:包括线程块(Thread Blocks)和网格(Grids),组织线程以实现高效的并行计算。

- **内存层次结构**:包括全局内存、局部存储(L1/L2缓存)、共享内存和缓存管理策略。

- **异构编程**:允许CPU和GPU协同工作,提高整体性能。

- **异步SIMT编程**:Single Instruction Multiple Threads(单指令多线程)模型,支持同时执行多个指令。

4. **编程接口**:

- **NVCC编译器**:用于将C++代码编译成可以在GPU上运行的CUDA可执行文件。

- **二进制兼容性**:确保不同CUDA版本间的代码互操作性。

- **CUDA运行时**:包含初始化设备、内存管理(如L2缓存和共享内存)、同步机制(如内存同步域、事件和图形)等功能。

5. **多设备支持**:针对多GPU系统,书中介绍了如何设备枚举、选择合适的设备以及处理数据流和事件行为,包括点对点内存访问。

这本书对于想要利用CUDA进行高性能计算的C++开发者来说,提供了全面且深入的指导,覆盖了从入门到高级技术的方方面面。通过阅读和实践,开发者能够充分利用GPU的计算能力,提升应用程序的性能。

2011-09-14 上传

254 浏览量

174 浏览量

1142 浏览量

270 浏览量

141 浏览量

104 浏览量

111 浏览量

扶摇2006

- 粉丝: 1

最新资源

- 实现类似百度的邮箱自动提示功能

- C++基础教程源码剖析与下载指南

- Matlab实现Franck-Condon因子振动重叠积分计算

- MapGIS操作手册:坐标系与地图制作指南

- SpringMVC+MyBatis实现bootstrap风格OA系统源码分享

- Web工程错误页面配置与404页面设计模板详解

- BPMN可视化示例库:展示多种功能使用方法

- 使用JXLS库轻松导出Java对象集合为Excel文件示例教程

- C8051F020单片机编程:全面控制与显示技术应用

- FSCapture 7.0:高效网页截图与编辑工具

- 获取SQL Server 2000 JDBC驱动免分数Jar包

- EZ-USB通用驱动程序源代码学习参考

- Xilinx FPGA与CPLD配置:Verilog源代码教程

- C#使用Spierxls.dll库打印Excel表格技巧

- HDDM:C++库构建与高效数据I/O解决方案

- Android Diary应用开发:使用共享首选项和ViewPager