CUDA:异构计算开启GPU编程革命与NVIDIA Turing架构解析

133 浏览量

更新于2024-08-28

收藏 842KB PDF 举报

异构计算是一种计算机系统设计策略,它利用不同类型和架构的处理器协同工作,以提升整体性能。在CUDA(Compute Unified Device Architecture)的背景下,这种概念尤为突出。CUDA是由NVIDIA公司开发的一种并行计算平台,最初是为了利用图形处理单元(GPU)的强大并行处理能力扩展传统CPU的应用领域。

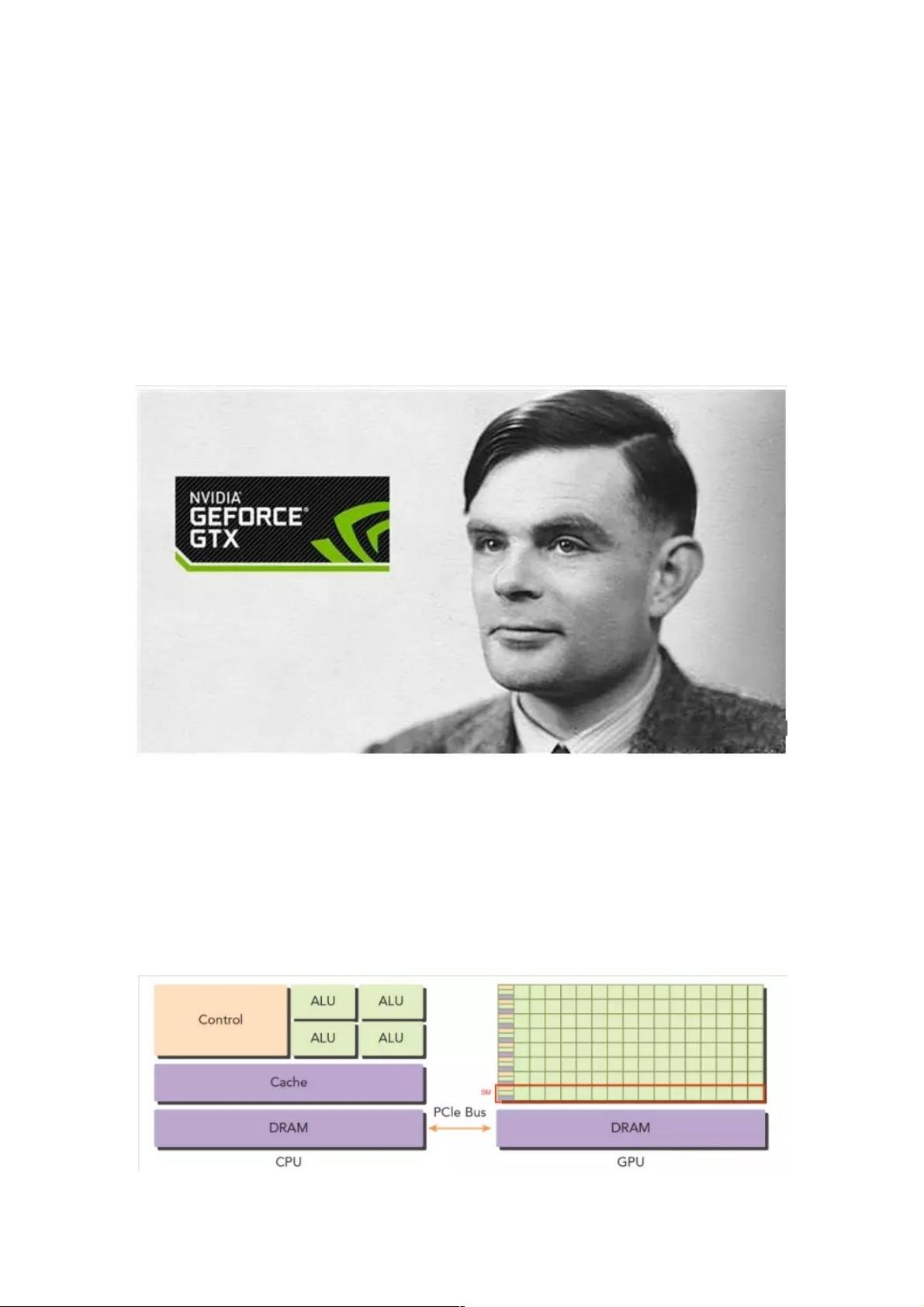

异构计算的关键在于理解不同硬件间的差异。例如,传统的CPU基于x86架构,拥有复杂的指令集,负责执行顺序控制和逻辑运算,同时拥有较小的L1、L2和L3缓存以及内存访问能力。而GPU原本设计用于图形渲染,拥有众多并行计算核心(Stream Multiprocessors, SM),适合处理高并行性的任务,如图像处理和科学计算。

在CUDA中,CPU扮演"主机"或"控制者"的角色,负责任务调度和数据管理,GPU则作为"设备"执行大量的并行计算。通过PCIe接口连接,CPU将计算任务分派给GPU,GPU执行完毕后再将结果返回给CPU进行整合。这样的异构架构使得GPU可以高效地处理大规模的数据并行任务,如深度学习中的矩阵运算和神经网络训练。

然而,异构计算也带来了复杂性,因为涉及CPU和GPU之间的通信协调,以及可能存在的数据传输延迟。这需要开发者编写专门的并行代码,并利用CUDA编程模型,如CUDA C++或Python的cupy库,来利用GPU的特性。同时,硬件的升级和优化,如NVIDIA的Turing架构,不断推动着异构计算技术的发展,使其在高性能计算、科学计算和人工智能等领域发挥越来越重要的作用。

CUDA之异构计算是现代高性能计算的重要组成部分,它不仅提升了计算效率,还推动了计算机硬件与软件的创新,为未来的科技发展奠定了基础。

2021-08-24 上传

2022-08-03 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38545117

- 粉丝: 9

- 资源: 917

最新资源

- DemoCardio:演示了VitalSigns SDK用于血压测量的用法

- Getting-and-Cleaning-Data-Project

- React-Mongo-Recipe-App:使用ReactJS和MongoDB构建的食谱应用程序

- 在线音频流Audio播放功能

- swiper.js手机触屏滑动选项卡标签切换特效代码

- beautifulsoup4-4.6.2.tar.gz

- coursera_getting_and_cleaning_data-

- fbgen:Markov生成的Facebook聊天

- Laravel

- toh:解释河内难题之塔的程序,同时递归和迭代地解决它

- Java学生信息管理系统源码包

- 翻转改变图片的动画Animation

- learning-laravel-framework-spring-2020-2021

- docopt-0.3.0.tar.gz

- GettingandCleaningDataCourseProject

- 用 MATLAB 制作的从视频中提取帧的算法_代码_下载