深度学习神经网络架构与LSTM原理详解

需积分: 0 185 浏览量

更新于2024-08-04

收藏 1.19MB DOCX 举报

王立昊周报1201708021

本周报中,王立昊教授对神经网络和深度学习进行了详细的介绍和讨论。下面是从本周报中提炼出的知识点:

一、神经网络的基本概念

* 架构一个深度学习网络大致分为三步:建立神经元、设定学习目标、开始学习。

* 一个神经元在做的事情是通过单个神经元链接起来进行多次运算,最终得到一个值。

* 由于我们不可能最初就能获得偏差值为0的结果,需要通过计算的修正不断学习。

二、机器学习的本质

* 机器学习并不是机器能做到全览性的认知,而是通过算法对目标较优化地进行猜测,得出最大概率的情况。

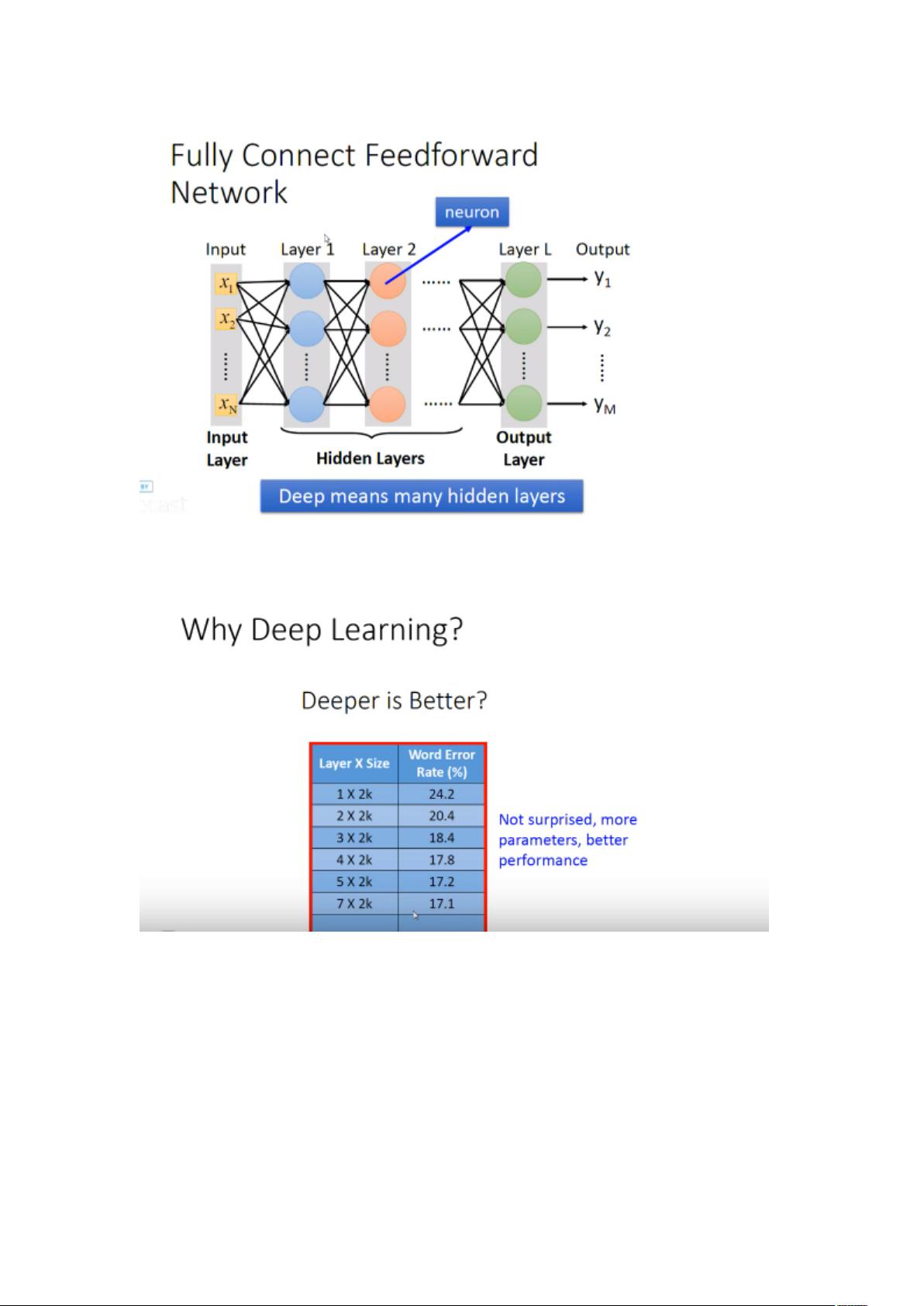

三、深度学习的必要性

* 越深错误率越低,层数越深参数越多,准确率越高。

* 为什么不直接选择层数极限来进行计算?考虑到部分Sample数量较少,通过分步能够将这个情况绕过,避免出现某个参数的Sample数量较少。

四、深度学习的挑战

* Overfitting:由于机器训练时接收的同类型的数据过多,但是测试时数据与训练时有略微差别,那么有可能会出现无法识别或者是误差过大的情况。

* 解决Overfitting的方法:EarlyStopping、WeightDecay、Dropout等。

五、LSTM(Long-Short Term Memory)

* LSTM解决了RNN中的The Vanishing Gradient Problem,引入了Cell元素来记忆信息。

* LSTM是一个魔改组件,能够将RNN中的小圆圈换成LSTM的block。

六、Mini-batch

* 将数据进行分组来进行,能获得较好的准确度和稳定性,但是容易产生单一性。

七、学习效率

* 设置一个合适的学习效率是非常重要的,能帮助机器能够快速获得准确率高的结果。

八、神经网络的实践

* 跑了一个神经网络的小程序,大致了解了基本过程。

本周报中王立昊教授对神经网络和深度学习进行了详细的介绍和讨论,涵盖了神经网络的基本概念、机器学习的本质、深度学习的必要性、深度学习的挑战、LSTM、Mini-batch、学习效率等内容。

2022-08-08 上传

2022-08-08 上传

2021-09-29 上传

245 浏览量

2008-11-03 上传

实在想不出来了

- 粉丝: 36

- 资源: 318

最新资源

- 构建基于Django和Stripe的SaaS应用教程

- Symfony2框架打造的RESTful问答系统icare-server

- 蓝桥杯Python试题解析与答案题库

- Go语言实现NWA到WAV文件格式转换工具

- 基于Django的医患管理系统应用

- Jenkins工作流插件开发指南:支持Workflow Python模块

- Java红酒网站项目源码解析与系统开源介绍

- Underworld Exporter资产定义文件详解

- Java版Crash Bandicoot资源库:逆向工程与源码分享

- Spring Boot Starter 自动IP计数功能实现指南

- 我的世界牛顿物理学模组深入解析

- STM32单片机工程创建详解与模板应用

- GDG堪萨斯城代码实验室:离子与火力基地示例应用

- Android Capstone项目:实现Potlatch服务器与OAuth2.0认证

- Cbit类:简化计算封装与异步任务处理

- Java8兼容的FullContact API Java客户端库介绍