大数据时代:HDFS与分布式计算应对挑战

版权申诉

17 浏览量

更新于2024-07-02

收藏 4.2MB PPTX 举报

"大数据与分布式计算是现代IT领域中的关键概念,主要关注如何处理和管理海量数据以提高存储效率、数据安全性和计算性能。该PPT文档深入探讨了这一主题,共有64页内容。

首先,PPT从1990年数据存储和传输速度的对比引入,强调了随着数据量的增长,传统的单机存储方式已无法满足需求。那时的硬盘驱动器容量虽大,但数据传输速度缓慢,使得读取全盘所需时间增长,引发了对存储和数据处理效率的思考。

接着,文档介绍了常用的RAID(廉价冗余磁盘阵列)技术,包括RAID0、RAID1、RAID10、RAID5和RAID6,这些技术通过不同的数据分布和冗余策略,平衡了访问速度、数据可靠性以及磁盘利用率。例如,RAID0追求速度但牺牲了可靠性,而RAID10兼顾了速度和可靠性,但磁盘利用率较低。

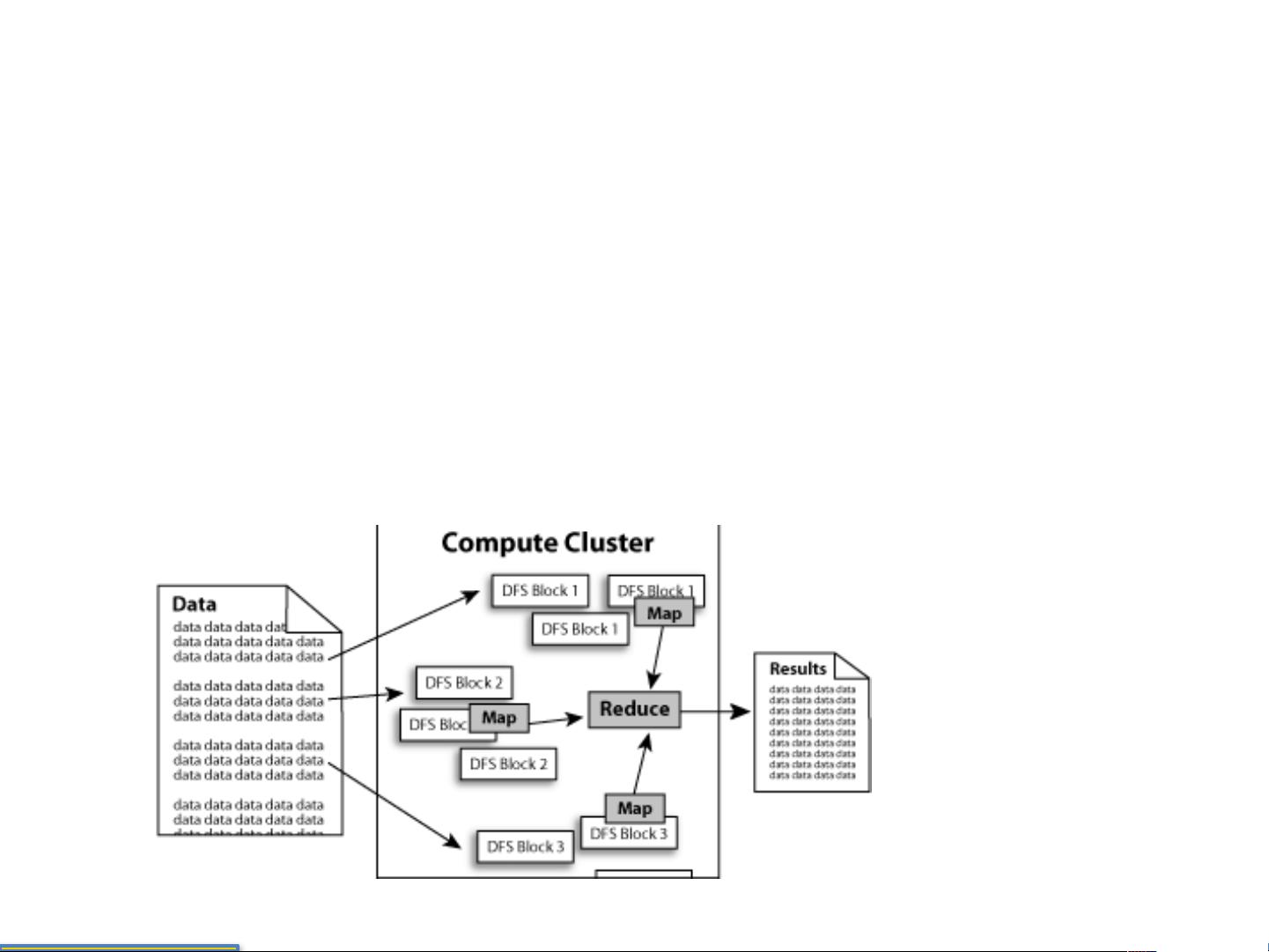

HDFS(Hadoop分布式文件系统)是大数据处理的核心组件,它是Hadoop生态系统的主要存储解决方案。HDFS设计目标是支持大规模、一次性写入、多次读取的流式数据访问,适用于商业硬件集群环境。它的优势在于能够创建数据块副本并分布在多个节点上,提供高可用性和容错性,同时支持MapReduce这样的分布式计算模型进行处理。

然而,HDFS并不适合对低延迟、大量小文件或需要频繁写入修改的场景,因为它的设计重点在于处理大文件和批量操作。当数据访问需求超出NameNode的能力范围或者涉及多用户并发写入时,HDFS的局限性就会显现。

总结来说,大数据与分布式计算的研究旨在解决海量数据存储和处理的挑战,通过如HDFS这样的分布式系统,将数据分散到多台机器上,不仅提高了数据处理速度,还增强了系统的稳定性和容错能力。随着技术的发展,这种处理模式将继续推动IT行业的进步,帮助企业更好地应对大数据时代的复杂需求。"

2021-09-22 上传

2023-10-05 上传

2024-05-20 上传

2021-09-24 上传

2021-10-14 上传

2021-12-03 上传

2021-10-14 上传

2021-11-27 上传

2021-09-21 上传

是空空呀

- 粉丝: 189

- 资源: 3万+

最新资源

- 磁性吸附笔筒设计创新,行业文档精选

- Java Swing实现的俄罗斯方块游戏代码分享

- 骨折生长的二维与三维模型比较分析

- 水彩花卉与羽毛无缝背景矢量素材

- 设计一种高效的袋料分离装置

- 探索4.20图包.zip的奥秘

- RabbitMQ 3.7.x延时消息交换插件安装与操作指南

- 解决NLTK下载停用词失败的问题

- 多系统平台的并行处理技术研究

- Jekyll项目实战:网页设计作业的入门练习

- discord.js v13按钮分页包实现教程与应用

- SpringBoot与Uniapp结合开发短视频APP实战教程

- Tensorflow学习笔记深度解析:人工智能实践指南

- 无服务器部署管理器:防止错误部署AWS帐户

- 医疗图标矢量素材合集:扁平风格16图标(PNG/EPS/PSD)

- 人工智能基础课程汇报PPT模板下载