快速掌握SparkSQL:原理、DataFrame与高效计算

需积分: 25 27 浏览量

更新于2024-09-10

收藏 356KB DOCX 举报

SparkSQL文档深入解析

SparkSQL是Apache Spark生态系统中的重要组件,专为处理结构化数据设计,它将SQL查询与Spark的核心数据处理能力相结合,提供了DataFrame数据结构作为主要的工作单元。本课程旨在帮助你掌握SparkSQL的核心原理和实践应用。

首先,课程的目标包括:

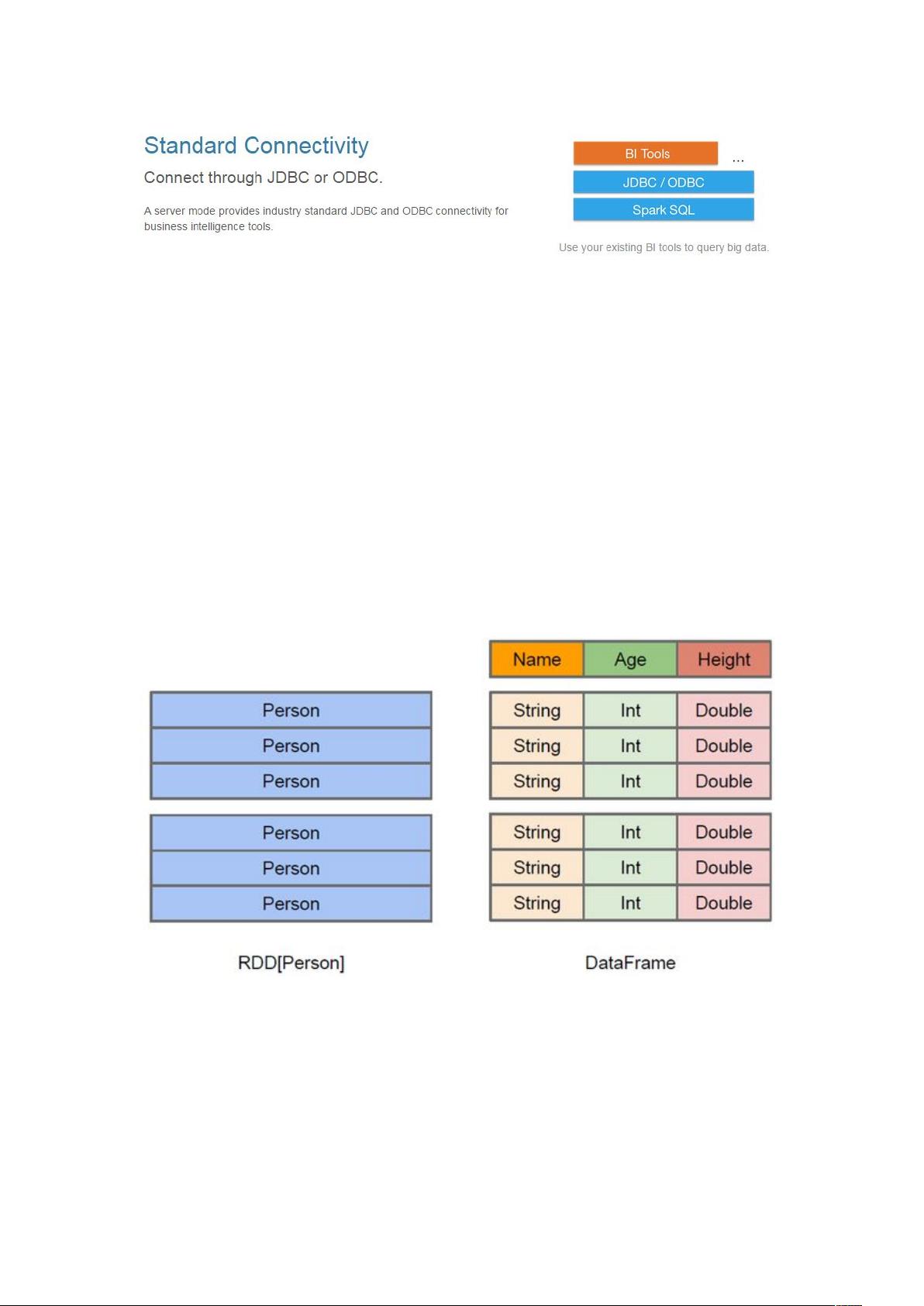

1. **理解SparkSQL原理**:SparkSQL构建在Spark的基础上,它通过将SQL语句转化为底层的Resilient Distributed Datasets (RDD)进行高效执行,相比传统的MapReduce模型,SparkSQL的性能显著提升。

2. **掌握DataFrame数据结构**:DataFrame是SparkSQL的核心数据结构,类似于数据库中的表格,它包含了数据本身以及元数据,如列名、数据类型等,使得数据操作更为直观且具有良好的性能。

3. **实战应用**:学习如何使用SparkSQL进行复杂的计算任务,包括数据导入、清洗、转换和分析等步骤。

**SparkSQL概述**:

- SparkSQL作为Spark的一部分,提供了统一的数据访问接口,使得开发者可以利用标准的SQL查询语法操作分布式数据。

- 它兼容Hive,允许用户无缝切换到SparkSQL,同时避免了HiveSQL与MapReduce之间转换的复杂性。

- SparkSQL的设计目的是提升性能,通过RDD的底层优化,减少了数据的复制和转换,从而提高数据处理速度。

**DataFrames详解**:

- DataFrame是SparkSQL中的核心数据载体,它不仅存储数据,还记录了数据结构信息(schema),这使得DataFrame在处理结构化数据时更为方便。

- DataFrame API 提供了一套易于理解和使用的高层关系操作,相较于RDD的函数式API,其学习曲线更平缓,对新手更友好。

- DataFrame的创建通常通过SQLContext实现,例如,可以读取HDFS上的文本文件,分割每一行,然后定义自定义的case class(类似于表结构)来映射数据。

在实际操作中,你可能会遇到以下步骤:

1. 将本地文件上传至HDFS,并使用textFile函数读取数据。

2. 使用map函数将每行数据按照指定分隔符(如空格)分割成RDD。

3. 定义case class(如`case class Person(id: Int, name: String, age: Int)`)来定义DataFrame的结构,然后将RDD与case class关联,从而创建DataFrame对象。

SparkSQL是Spark在大数据处理领域的重要工具,通过学习和掌握它,你可以更有效地处理和分析结构化数据,提升大数据分析的效率和可维护性。无论是理论学习还是实际项目中,SparkSQL都是值得深入研究的技能点。

751 浏览量

243 浏览量

219 浏览量

2024-09-07 上传

271 浏览量

2024-12-26 上传

2024-04-05 上传

1974 浏览量

dengddddw

- 粉丝: 1

最新资源

- Windows CE开发与嵌入式Linux资料概览

- Borland PME模型:属性、方法和事件

- Oracle全文检索技术深度解析

- 使用PHP接口实现与Google搜索引擎交互

- .Net框架中的Socket编程基础

- C#编程进阶指南:对象思考与核心技术

- Visual C# 中的MDI编程实践

- C语言数值计算:经典教程与源码解析

- TCP/IP协议下的Socket基础与进程通信解决策略

- Java学习经验分享:动态加载与类查找原理探索

- Oracle 1z0-031 认证考试试题与学习指南

- EJB3基础教程:元数据批注与EntityBean解析

- 深入理解Hibernate 3.x过滤器:参数化与灵活性提升

- Eclipse+MyEclipse集成:Struts+Spring+Hibernate开发用户信息查询示例

- Visual C#数据库编程基础:浏览、修改、删除与插入

- 基于小波变换的图像边缘检测Matlab代码实现