支持向量机:最大化分类边界

需积分: 9 9 浏览量

更新于2024-07-16

收藏 1.86MB PPTX 举报

"清华大学【数据挖掘:支持向量机】Support_Vector_Machines.pptx"

支持向量机(Support Vector Machines, SVM)是一种强大的监督学习算法,尤其在分类和回归任务中表现出色。该技术由Vladimir Vapnik等人在20世纪90年代提出,基于结构风险最小化原理,旨在找到具有最大边界的分类超平面。

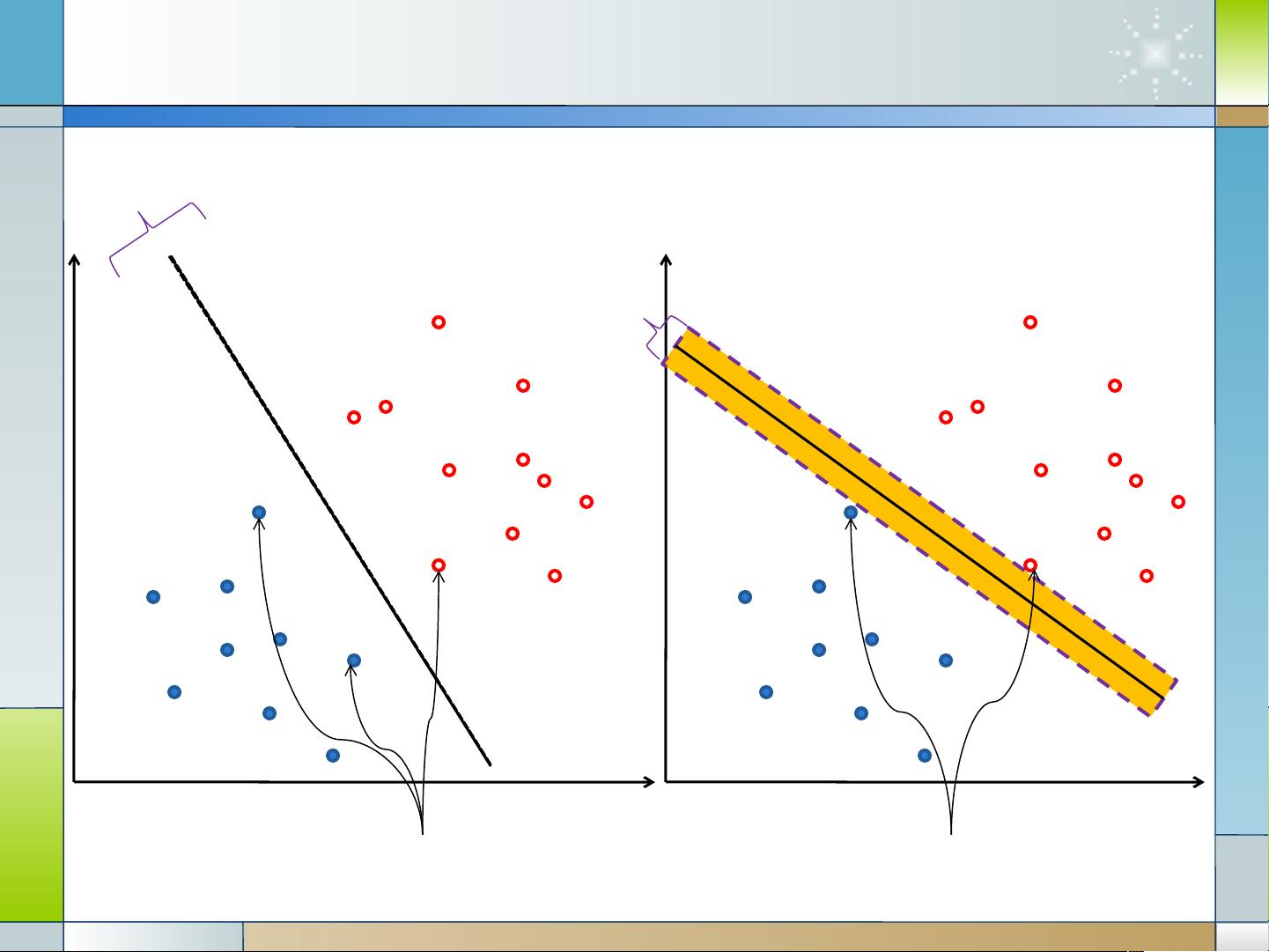

**1. 边界与安全系数**

线性分类器的边界(margin)是指分类超平面与最近的数据点之间的距离。较大的边界意味着模型有更大的容错空间,因为数据点更不容易误分类。这种被称为“宽边距”的特性使得支持向量机在处理噪声和异常值时更具鲁棒性。

**2. 支持向量**

支持向量是决定超平面的关键数据点,位于边界最边缘。它们距离超平面最近,直接影响分类器的决策边界。其它非支持向量的数据点尽管对分类器的构建也有贡献,但并不直接影响超平面的位置,因此在优化过程中可以被忽略。

**3. 最大边界原则**

选择具有最大边距的分类器是SVM的核心思想。这是因为最大边界能提供更好的泛化能力,即在未见过的数据上表现良好。这与过拟合的概念相对,过拟合是指模型过于复杂,过度适应训练数据,导致对新数据的预测能力下降。

**4. 线性支持向量机(LSVM)**

线性SVM寻找的是一个线性超平面,通过最大化训练数据集中的间隔来实现。在二维空间中,这个超平面将不同类别的数据点分开,且距离最近的数据点最远。

**5. 定义边界形式化**

为了正式地定义边界,我们需要一个目标函数,它既要确保所有训练样本被正确分类,又要最大化间隔。这通常通过构造一个二次优化问题来实现。

**6. 优化问题**

SVM的目标是找到一组权重向量`w`和偏置`b`,使它们形成的超平面最大化间隔,同时满足所有训练样本的分类条件。这导致了一个凸优化问题,通常使用拉格朗日乘子法转换成对偶问题来解决。

**7. 拉格朗日乘子与对偶问题**

引入拉格朗日乘子`λ`后,原问题转化为对偶问题,这是一个二次规划问题,可以直接求解出权重向量`w`和偏置`b`。在对偶问题中,支持向量扮演了主要角色,因为它们决定了最终的分类决策。

**8. 内积与核函数**

内积在SVM中起到关键作用,特别是在非线性分类中。通过引入核函数,可以将原始特征空间映射到高维特征空间,在那里线性分类可能成为可能,同时保持了最大边距的性质。

总结,支持向量机是一种通过最大化分类间隔来寻求最佳决策边界的机器学习方法。它依赖于支持向量来定义超平面,并通过拉格朗日乘子和对偶问题的解决来实现优化。SVM的这些特性使其在处理复杂数据和实现高泛化能力时表现出色。

2018-01-28 上传

2023-07-13 上传

2023-02-26 上传

2023-06-02 上传

2023-03-08 上传

2023-09-21 上传

2023-05-26 上传

2023-07-22 上传

资源存储库

- 粉丝: 9802

- 资源: 393

最新资源

- C语言快速排序算法的实现与应用

- KityFormula 编辑器压缩包功能解析

- 离线搭建Kubernetes 1.17.0集群教程与资源包分享

- Java毕业设计教学平台完整教程与源码

- 综合数据集汇总:浏览记录与市场研究分析

- STM32智能家居控制系统:创新设计与无线通讯

- 深入浅出C++20标准:四大新特性解析

- Real-ESRGAN: 开源项目提升图像超分辨率技术

- 植物大战僵尸杂交版v2.0.88:新元素新挑战

- 掌握数据分析核心模型,预测未来不是梦

- Android平台蓝牙HC-06/08模块数据交互技巧

- Python源码分享:计算100至200之间的所有素数

- 免费视频修复利器:Digital Video Repair

- Chrome浏览器新版本Adblock Plus插件发布

- GifSplitter:Linux下GIF转BMP的核心工具

- Vue.js开发教程:全面学习资源指南