外网Linux集群部署大数据环境:Hadoop与Spark配置详解

需积分: 19 118 浏览量

更新于2024-07-17

收藏 1.38MB DOCX 举报

本文档详细介绍了在大数据集群环境中进行部署的具体步骤,主要围绕Hadoop和Spark两个核心组件展开。首先,从操作系统层面,着重于在Linux集群的外网环境下进行部署,包括安装Java Development Kit (JDK)。由于系统可能已经自带JDK,需要先检查并如有必要,删除自带版本,然后下载并解压指定版本的JDK到"/opt"目录。

配置JDK环境变量是部署过程中必不可少的环节。用户需要编辑"/etc/profile"文件,设置JAVA_HOME、JRE_HOME、CLASSPATH和PATH,以确保Java命令行工具能够被系统识别。配置完成后,通过运行"source /etc/profile"命令使更改生效,并通过测试"java –version"和"javac"命令验证JDK安装是否成功。

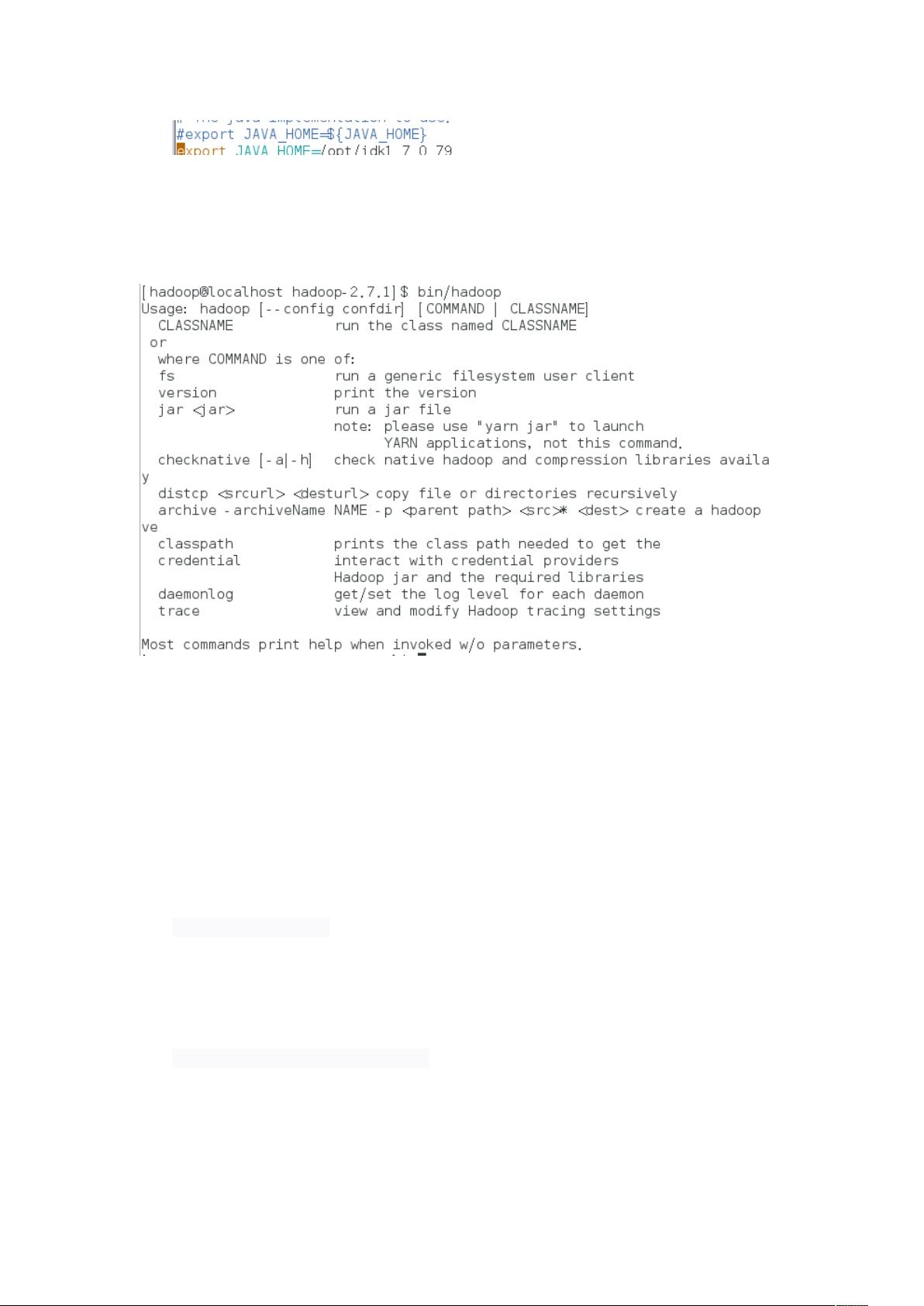

接着,文档指导读者如何安装Hadoop。同样地,先解压Hadoop包到"/opt"目录下,确保与JDK保持一致的安装位置。然后,修改"/etc/profile"以添加HADOOP_HOME路径,并将Hadoop bin目录添加到PATH环境变量中,以使Hadoop命令可以在终端中无痛调用。

安装Hadoop之后,本文还涉及了Spark的安装和配置。虽然这部分内容没有提供详细的步骤,但可以推测在Hadoop基础上,用户会安装Spark并将其与Hadoop集成,可能涉及到Spark的依赖管理和配置文件的修改,以便与Hadoop集群协同工作。

此外,文中提到的"eclipse配置(HDFS文件上传)"可能涉及Eclipse IDE的配置,即如何在Eclipse中设置连接到Hadoop的HDFS文件系统,以便开发人员可以方便地上传和处理大数据。

最后,文档提到了"外网环境向内网迁移",这通常意味着将部署环境从公开的互联网环境转移到内部私有网络,这涉及到网络安全策略、防火墙设置以及可能的IP映射或NAT配置,以确保内外部系统的通信安全和效率。

调试程序是整个部署过程中的重要环节,用户需要对Hadoop和Spark服务进行监控和故障排查,确保大数据处理流程的稳定性和性能。

这篇文档提供了大数据集群环境部署的详尽指南,涵盖了从基础的JDK和Hadoop安装,到高级的Spark集成,以及网络环境的调整,为构建高效的大数据处理平台提供了实用的参考。

209 浏览量

173 浏览量

426 浏览量

212 浏览量

248 浏览量

2024-12-29 上传

2022-10-31 上传

2022-10-31 上传

点击了解资源详情

轮回xc

- 粉丝: 0

最新资源

- 新冠疫情数据可视化分析展示

- 网页文字闪烁效果实现与Java实战项目源码下载

- Swift开发中用于监控文件变化的微型框架

- 深入理解MiniShell开发与C语言编程实践

- 品牌占据消费者心智的快速方法

- MATLAB相机标定与参数导出实用程序

- 掌握机器学习分类模型,使用scikit-learn实践教程

- 3D图形编程中的Weiler-Atherton算法实现详解

- Discuz插件实现论坛高效管理与互动

- Java实战:JQuery浮动窗口与阿里云服务器上运行Java源码

- Swift中FMDB的基本操作教程:增删改查详解

- 企业文化核心价值与塑造策略解析

- 构建本地API的Android JSON Server实践指南

- Java开发者的Git工具包——java-commons-git-utils

- 粉色商务型企业虚拟网站CSS网页模板下载

- 探索DS实验:深入理解数据结构实践