深度学习优化算法详解:从SGD到Adam

需积分: 0 57 浏览量

更新于2024-07-01

收藏 2.75MB PDF 举报

"该串讲主要讲解了优化算法在深度学习中的应用,涵盖了从基本的随机梯度下降(SGD)到更高级的优化算法,如动量法(Momentum),牛顿法(NAG),Adagrad,RMSProp/AdaDelta,Adam以及Nadam等。这些算法都是为了更有效地寻找损失函数的最小值,从而改进模型的训练过程。"

在深度学习中,优化算法是训练神经网络的关键步骤,它们负责调整模型参数以最小化损失函数。以下是各种优化算法的详解:

1. **SGD (随机梯度下降)**:是最基础的优化方法,它每次仅使用一个样本来计算梯度并更新参数。这使得SGD在大数据集上速度快,但可能因为样本的随机性导致训练不稳定,收敛速度较慢。

更新公式:θ_t+1 = θ_t - η * g_t,其中g_t是当前批次的梯度,η是学习率。

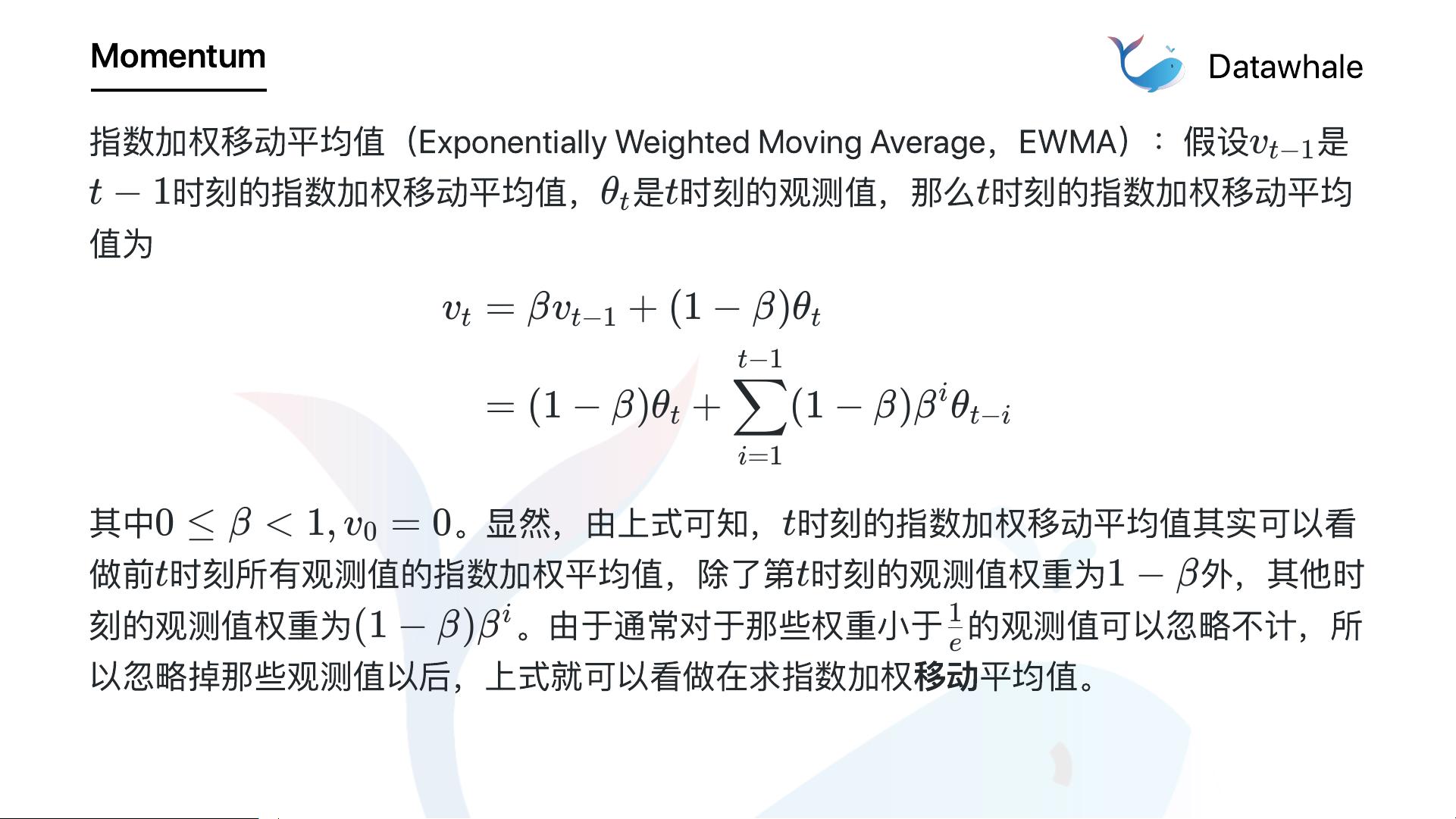

2. **Momentum**:为了解决SGD的震荡问题,引入了一阶动量m,它是一个历史梯度的加权平均,可以加速学习过程并平滑更新。

更新公式:m_t = ϕ(g_t, g_{t-1}, ..., g_{t-n}),V_t = ψ(g_t, g_{t-1}, ..., g_{t-n}),Δθ_t = -η * V_t / m_t,θ_t+1 = θ_t + Δθ_t。

3. **NAG (牛顿法带动量)**:在Momentum的基础上,提前一步应用动量,使得参数更新更加平滑,有助于更快地逃离局部最小值。

更新公式:Δθ_t = -η * (1 + γ) * g_t - η * γ * V_{t-1},其中γ是动量项。

4. **AdaGrad**:根据每个参数的历史梯度平方和自适应调整学习率,适合稀疏数据。

更新公式:θ_t+1 = θ_t - η / √(E[g^2]_t) * g_t。

5. **RMSProp/AdaDelta**:对AdaGrad的改进,通过指数移动平均来解决AdaGrad学习率过快衰减的问题。

更新公式:R_t = ρ * R_{t-1} + (1 - ρ) * g_t^2,θ_t+1 = θ_t - η * √(E[g^2]_t / R_t) * g_t。

6. **Adam**:结合了Momentum和RMSProp,同时引入了偏置校正,适用于非平稳目标和大规模数据集。

更新公式:m_t = β1 * m_{t-1} + (1 - β1) * g_t,v_t = β2 * v_{t-1} + (1 - β2) * g_t^2,m_t^* = m_t / (1 - β1^t),v_t^* = v_t / (1 - β2^t),θ_t+1 = θ_t - η * m_t^* / (√v_t^* + ε)。

7. **Nadam**:是Adam的变种,引入了NAG的思想,使得Adam的动量项也具有适应性。

更新公式:同Adam,但在动量项m_t上应用了NAG的提前一步更新。

优化算法的选择取决于具体任务的需求,包括数据特性、模型结构以及计算资源等因素。正确选择和调参优化算法能显著提升模型的训练效率和最终性能。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-01-13 上传

2021-03-19 上传

2010-03-08 上传

2010-03-30 上传

2023-06-16 上传

2021-06-21 上传

张匡龙

- 粉丝: 25

- 资源: 279

最新资源

- loopstudios:响应式网页旨在训练HTML,CSS和少量JavaScript

- ga_blog

- 每周:每周

- Contour plot based on Delaunay with linear interpolation:Contour plot based on Delaunay triangulation with linear interpolation between triangles-matlab开发

- Lotide

- study:我的最佳实践总结

- chrispearce.co:个人网站

- groups群的复合参数化:使用复合参数化生成unit矩阵和特殊unit矩阵。-matlab开发

- rodrigoSilva23

- CeoClick项目

- elive-开源

- TowerDefence:根据教程学习塔防游戏

- Laurel-genes

- lumberjack:伐木工人是Go的日志滚动包

- pmap - 参数空间稳定性映射套件:在连续时间系统的参数空间中查找 Hurwitz 稳定性区域。-matlab开发

- OPPOR9mh原厂维修图纸.zip