"深度解析尚硅谷大数据技术之Spark内核V3.0:核心组件与任务调度机制"

需积分: 0 22 浏览量

更新于2024-03-22

收藏 1.12MB DOCX 举报

本文介绍了尚硅谷大数据技术之Spark内核版本V3.0的内容,主要包括了Spark内核的概述,其中涉及了Spark的核心运行机制,包括核心组件的运行机制、任务调度机制、内存管理机制以及核心功能的运行原理等内容。熟练掌握Spark内核原理可以帮助我们更好地设计Spark代码,并能够准确地解决项目运行过程中出现的问题。

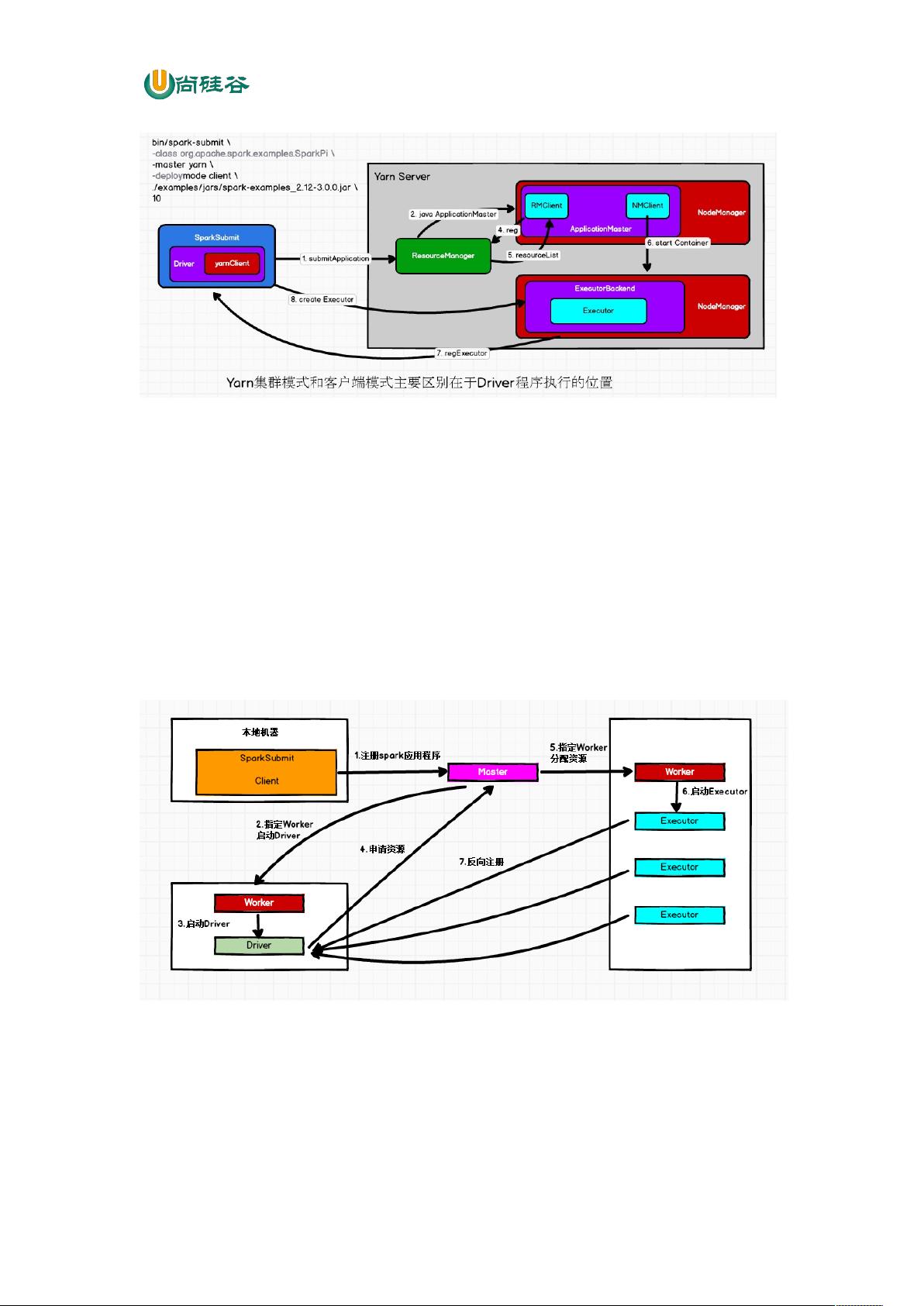

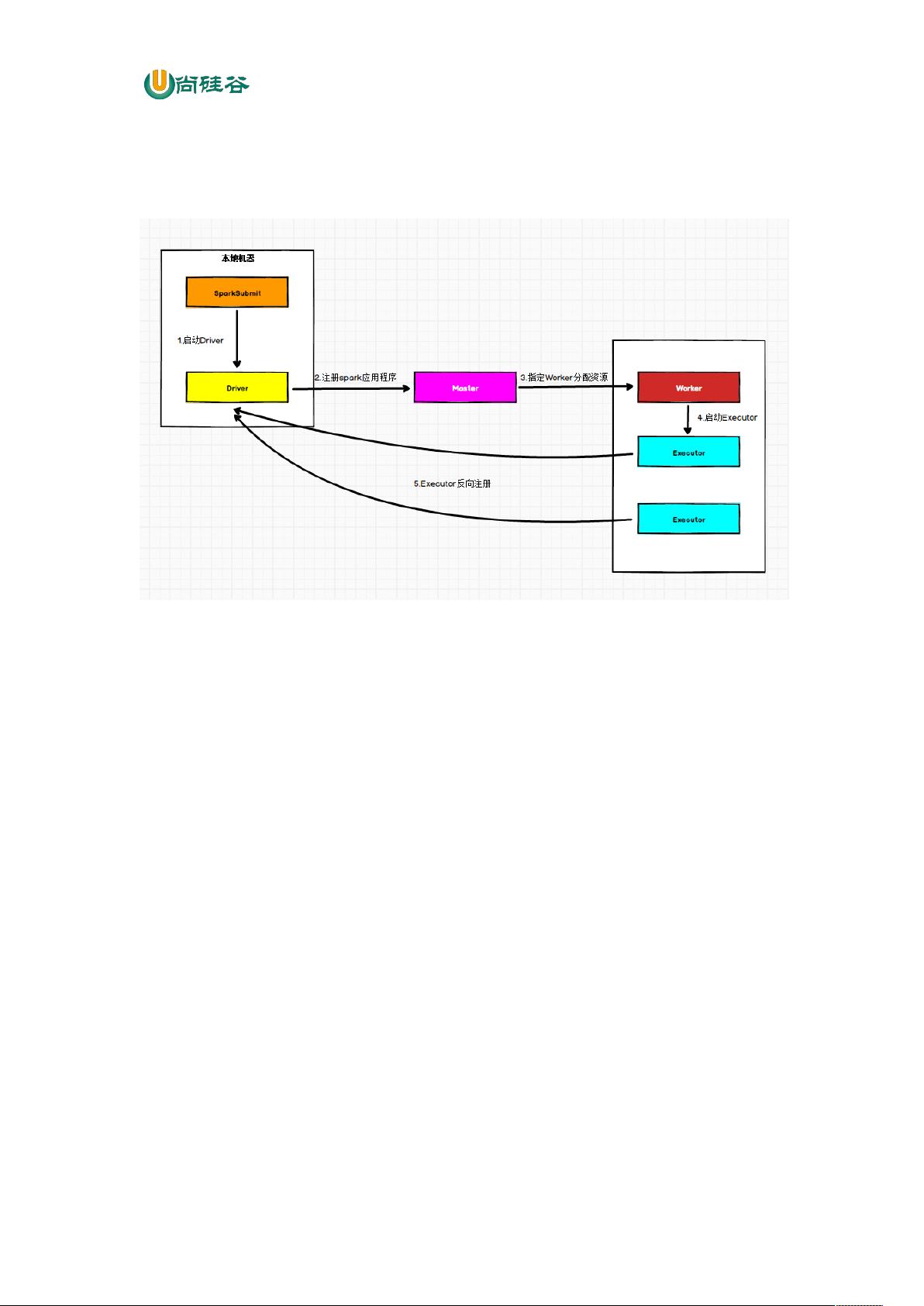

在Spark内核概述中,我们首先回顾了Spark的核心组件,其中包括了Driver和Executor。Driver节点是执行Spark任务中的main方法的节点,负责实际的代码执行工作。在Spark作业执行过程中,Driver主要负责将用户程序转换为作业执行图,并且负责维护整个作业的执行状态。另一方面,Executor节点是在Worker节点上执行任务的容器,负责执行具体的任务并向Driver报告任务执行的状态。Executor节点的数量可以根据集群的资源情况进行动态调整,以实现更好的性能。

另外,本文还介绍了Spark的任务调度机制。Spark的任务调度是基于DAG调度模型的,在调度过程中会将用户程序转换为有向无环图(DAG),并根据依赖关系来执行任务。这种调度模型可以有效减少任务之间的依赖关系,提高作业的并行度,从而提高作业的执行效率。

此外,本文还介绍了Spark的内存管理机制。Spark内存管理主要是指Spark如何管理内存资源,包括内存的分配、释放、回收等操作。Spark的内存管理采用了堆内存和堆外内存相结合的方式,通过使用内存管理器来管理内存资源,以提高作业的执行效率。

最后,本文还介绍了Spark核心功能的运行原理。Spark提供了丰富的API和功能,例如RDD、DataFrame、DataSet等,这些功能都是基于Spark内核的运行机制实现的。了解这些核心功能的运行原理可以帮助我们更好地使用Spark进行数据处理和分析,提高代码的效率和性能。

综上所述,熟练掌握Spark内核的原理和运行机制可以帮助我们更好地设计和优化Spark代码,提高作业的执行效率和性能,从而更好地应用Spark进行大数据处理和分析。感谢尚硅谷大数据研发部为我们提供如此精彩的Spark内核学习内容。

2022-08-03 上传

2022-08-08 上传

2023-03-15 上传

2018-04-10 上传

2018-10-12 上传

点击了解资源详情

2019-05-28 上传

2020-06-30 上传

点击了解资源详情

顾露

- 粉丝: 19

- 资源: 313