深度学习驱动的自然语言处理进展:词嵌入与Transformer模型详解

需积分: 49 133 浏览量

更新于2024-07-15

2

收藏 5.04MB PDF 举报

深度学习自然语言处理概述(116页PPT)深入探讨了近年来自然语言处理领域的重大进展与挑战。随着深度学习在NLP领域的广泛应用,演讲者首先定义了什么是深度学习,并强调了其在处理复杂语言任务中的关键作用。核心知识点包括:

1. **深度学习基础**:深度学习是一种模仿人脑神经网络结构的机器学习方法,它通过多层非线性变换来解决传统算法难以处理的问题。

2. **递归神经网络 (Recurrent Neural Networks, RNN)**:在NLP中,RNN特别适用于序列数据,如词嵌入(如word2vec)。例如,演讲者提到的word2vec展示了如何通过词向量捕捉词汇之间的语义关系,如“king”与“queen”的关系和政治人物关联(如“Donald-Trump + Putin”)。

3. **词嵌入 (Word Embeddings)**:词嵌入技术,如word2vec(skip-gram模型),是将文本中的单词转换为密集向量表示,以便捕捉它们在上下文中的意义,这有助于词义理解和语言模型的构建。

4. **语言模型 (Language Models)**:语言模型是评估一句话或序列概率的重要工具,不仅用于拼写检查和语音识别,还用于生成文本,如AI生成的诗歌。演讲中提到了递归神经网络模型和Transformer模型在语言模型上的应用。

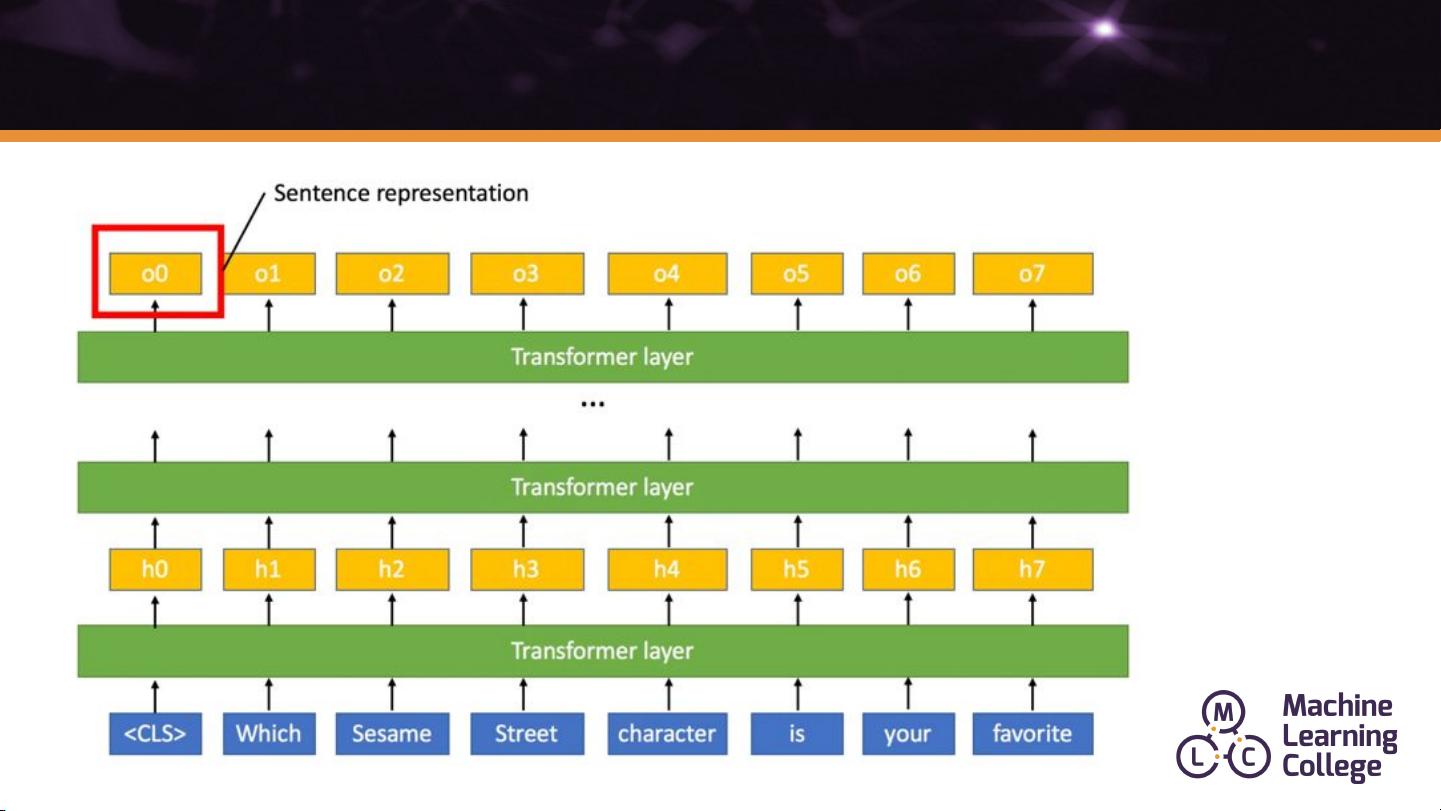

5. **Transformer模型**:自2017年Transformer模型的提出以来,它成为机器翻译和语言模型的基石。Transformer摒弃了RNN的循环结构,采用自注意力机制,显著提高了处理长距离依赖的能力。演讲者以GPT-2为例,展示了一个基于Transformer的大型语言模型,它能够生成逼真的文本,甚至模拟特定人物(如特朗普)的口吻。

6. **实际应用与演示**:演讲提供了几个示例,如与Transformer交互的网站(<https://talktotransformer.com/>),展示了深度学习语言模型如何进行实时的对话生成,以及在新闻报道生成等场景中的应用。

这篇116页的PPT深入剖析了深度学习在自然语言处理中的核心技术和最新进展,从词嵌入到Transformer模型,展示了深度学习如何推动NLP领域的创新和发展。通过理解这些概念和技术,研究者和开发者可以更好地设计和实现高效的自然语言处理系统。

2923 浏览量

1872 浏览量

2022-11-21 上传

106 浏览量

170 浏览量

670 浏览量

2024-07-14 上传

syp_net

- 粉丝: 158

最新资源

- Zoo_Planning项目:KRR技术在动物园规划中的应用

- MAC算法实现参考指南与代码解析

- 深入解析CAN总线英文版规范要点

- 精选7款仿IReader界面及PDF阅读器源码

- 复古风潮:Ajax网页DIV拖动与自动排列特效代码

- 春云全家桶演示:探索cloud2021的技术创新

- 51单片机项目:PCF8591与1602液晶显示集成Proteus仿真教程

- 无需代码的flash水波特效制作工具介绍

- FASTCOPY源代码分析:提升硬盘复制速度的工程

- 经典电脑知识宝典:一生受用不尽

- Hibernate3版本发布下载指南

- Java窗体界面美化:JLabel调用Windows字体教程

- UofA Bootcamp Module-1挑战1:重构入门实践

- 图形界面数字水印实现方法(VC版)

- 51单片机生成锯齿波的PCF8591应用实例

- 探索矢量量化技术在图像压缩中的高效应用