大数据挖掘:信息增益与分类决策详解

版权申诉

126 浏览量

更新于2024-07-07

收藏 1.22MB DOC 举报

本资源是一份针对大数据挖掘的复习题和问题详解文档,主要涵盖了计算机和互联网领域的知识,特别是决策树、特征选择、信息增益、Gini指数和贝叶斯分类等核心概念。文档中包含了一系列练习题和解答,旨在帮助学习者巩固和理解大数据挖掘中的关键算法和技术。

1. 题目涉及二元分类问题的熵计算:给出了一个训练样本集,其中类属性的比例分别为正例4/9和负例5/9。熵的计算表明,整个样本集的不确定性为0.9911,这是衡量数据随机性的指标。

- 信息增益是评估特征对数据分类效果的一种方法,通过计算每个特征划分后子集的熵与原始数据集熵的差值。在这个问题中,属性a1产生的信息增益最大,因此它被认为是最佳划分属性。

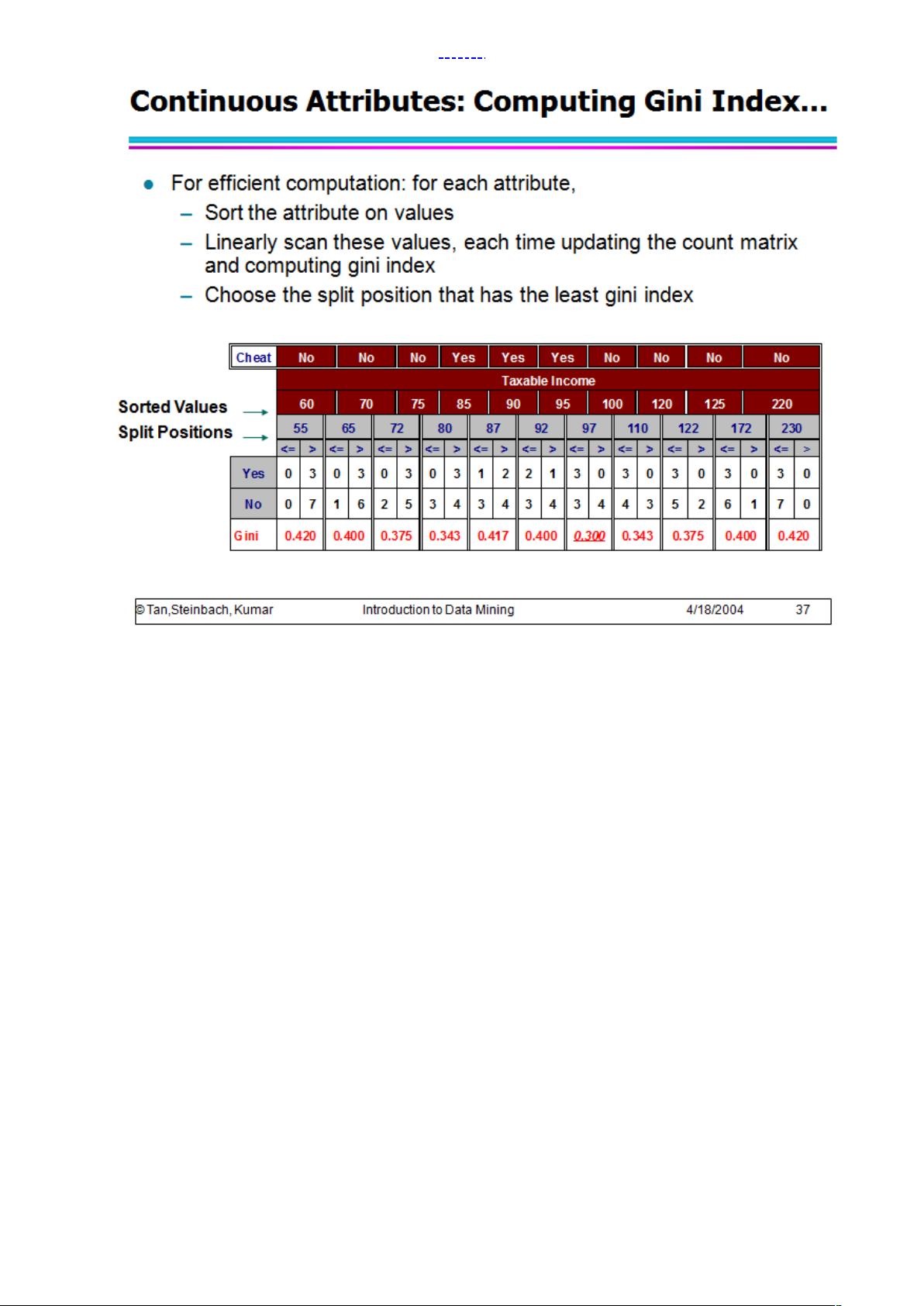

- Gini指数也是一个用于评估特征纯度的指标,Gini系数越低,表示分类越纯。在另一个实例中,尽管Gini指标与信息增益类似,但它们的尺度不同,信息增益的增益(Δ)并不总是按照相同的模式变化,这表明两者可能支持不同的属性选择。

2. 决策树算法的选择依据了信息增益或Gini指数。在给出的数据集中,需要计算属性a和b的信息增益,以及a和bgini指标,以此来决定决策树归纳算法会选择哪个属性。具体数值计算未提供,但原则是选择导致最大信息增益或最小Gini指数的属性。

3. 关于贝叶斯分类,文档展示了两种类别(+ 和 -)下的先验概率和条件概率。贝叶斯分类器基于这些概率计算后验概率,从而对新样本进行分类。例如,对于类别-,P(A=1|−) = 0.4,表明在负样本中A为1的概率较低,这对分类决策有重要影响。

总结,这份文档提供了丰富的数据挖掘和机器学习实践题目,涵盖了决策树、特征选择、熵、信息增益、Gini指数等知识点,通过解决实际问题,帮助学习者深入理解这些理论,并能在实际项目中灵活运用。同时,文档强调了信息增益和Gini指数虽然行为相似,但在特定情况下可能会支持不同的属性选择。

2021-12-05 上传

2011-11-20 上传

「已注销」

- 粉丝: 1

- 资源: 5万+

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手